Kompletny przewodnik po popularnych dużych modelach językowych

Wyobraź sobie, że zmagasz się z napisaniem idealnej historii, a twoje palce unoszą się nad klawiaturą, gdy pusta strona cię drwi. Nagle przypominasz sobie o swojej tajnej broni: dużym modelu językowym (LLM). Za pomocą kilku podpowiedzi LLM tworzy opowieść tak wciągającą, że można poczuć się jak za dotknięciem czarodziejskiej różdżki. To tylko jeden z przykładów mocy LLM, wyrafinowanych systemów sztucznej inteligencji, które zmieniają sposób, w jaki wchodzimy w interakcję z technologią.

W ciągle zmieniającym się i intrygującym świecie sztucznej inteligencji (AI), duże modele językowe (LLM) robią furorę dzięki swoim imponującym możliwościom radzenia sobie z ludzkim językiem. Ale czym dokładnie są te LLM i w jaki sposób rewolucjonizują nasze codzienne interakcje i zadania? Zagłębmy się w tę fascynującą sferę i odkryjmy niektóre z najbardziej znanych modeli LLM kształtujących przyszłość sztucznej inteligencji.

Zrozumienie dużych modeli językowych

LLM to zaawansowane modele uczenia maszynowego, które przewidują i generują tekst podobny do ludzkiego. Mogą one automatycznie uzupełniać zdania, tłumaczyć języki, a nawet tworzyć całe artykuły. Modele te ewoluowały od prostych predyktorów słów do złożonych systemów zdolnych do obsługi akapitów i dokumentów.

Jak działają duże modele językowe?

LLM szacują prawdopodobieństwo sekwencji słów, wykorzystując ogromne zbiory danych do uczenia się wzorców językowych. Są one zbudowane na architekturach takich jak Transformers, które koncentrują się na najbardziej istotnych częściach danych wejściowych w celu wydajnego przetwarzania dłuższych sekwencji.

Ewolucja technologii LLM: Od BERT do GPT-4

BERT, wprowadzony przez Google w 2018 roku, był przełomem, wykorzystując dwukierunkowy kontekst do zrozumienia niuansów języka. GPT-4, ze swoimi 178 miliardami parametrów, wyniósł generowanie tekstu na nowy poziom, pokazując zdolność do generowania tekstu podobnego do ludzkiego.

Przykłady działania dużych modeli językowych

CzatGPT, wariant modeli GPT OpenAI, stał się powszechnie znany, zasilając chatboty, które oferują interakcje podobne do ludzkich.

Wpływ BERT na zadania przetwarzania języka naturalnego

BERT znacznie poprawił wydajność zadań przetwarzania języka naturalnego, takich jak analiza nastrojów i tłumaczenie językowe.

GPT-3 i granica generowania tekstu

Zdolność GPT-3 do generowania kreatywnego i spójnego tekstu otworzyła nowe możliwości w tworzeniu treści i nie tylko.

Ściągawka z porównania znanych obecnie dużych modeli językowych

Aby lepiej zrozumieć skalę i różnorodność dużych modeli językowych, przyjrzyjmy się bliżej niektórym z najbardziej wpływowych publicznie dostępnych modeli, które obecnie dominują na rynku. Każdy model ma unikalne zalety i wyróżnia się w różnych przypadkach użycia.

Ta tabela zawiera szybki przegląd niektórych z najbardziej wpływowych dużych modeli językowych od 2024 roku. BERT, wprowadzony przez Google, jest znany ze swojej architektury opartej na transformatorach i był znaczącym postępem w zadaniach przetwarzania języka naturalnego. Klaudiuszopracowany przez Anthropic, koncentruje się na konstytucyjnej sztucznej inteligencji, dążąc do tego, aby wyniki sztucznej inteligencji były pomocne, nieszkodliwe i dokładne. CohereErnie, korporacyjny LLM, oferuje niestandardowe szkolenia i dostrajanie do konkretnych przypadków użycia w firmie. Ernie, z Baidu, ma oszałamiającą liczbę 10 bilionów parametrów i został zaprojektowany tak, aby wyróżniać się w języku mandaryńskim, ale jest również zdolny do pracy w innych językach.

Lokalne usługi LLM a usługi LLM w chmurze

Podczas gdy oparte na chmurze LLM oferują imponujące możliwości, rosnącym trendem jest wykorzystanie lokalnego wnioskowania z modelami open-source. Narzędzia takie jak LM Studio pozwalają użytkownikom uruchamiać uruchamiać LLM lokalnie bezpośrednio na swoich urządzeniach.

Podejście to priorytetowo traktuje prywatność, utrzymując wszystkie dane i przetwarzanie w trybie offline. Lokalne wnioskowanie wymaga jednak zazwyczaj bardziej wydajnego sprzętu i może ograniczać dostęp do najnowocześniejszych modeli ze względu na ich rozmiar.

15 najpopularniejszych dużych modeli językowych

| Nazwa modelu | Rozmiar (parametry) | Open Source? | Ostatnia aktualizacja (szacunkowa) | Firma | Kraj rozwoju |

| AI21 Studios Jurassic-1 Jumbo | 178B | Tak | Grudzień 2022 r. | AI21 Studios | Izrael |

| Google Gemma | 2B lub 7B | Tak | Maj 2023 r. | Google AI | Stany Zjednoczone |

| Meta LLaMA 13B | 13B | Tak | Początek 2023 r. | Meta AI | Stany Zjednoczone |

| Meta LLaMA 7B | 7B | Tak | Początek 2023 r. | Meta AI | Stany Zjednoczone |

| EleutherAI GPT-J | 6B | Tak | Maj 2023 (poprzez widełki takie jak Dolly 2) | EleutherAI (grupa badawcza) | Stany Zjednoczone |

| The Pile - EleutherAI | 900 GB danych tekstowych | Tak | Bieżący rozwój | EleutherAI (grupa badawcza) | Stany Zjednoczone |

| Mistral AI - Mistral Large | Nieujawnione publicznie (duże) | Open-source z płatnymi opcjami | Wrzesień 2023 r. | Mistral AI | Francja |

| Falcon 180B | 180B | Tak | Nie określono | Instytut Innowacji Technologicznych | ZJEDNOCZONE EMIRATY ARABSKIE |

| BERT | 342 miliony | NIE | Lipiec 2018 r. | Google AI | Stany Zjednoczone |

| Ernie | 10 bilionów | NIE | Sierpień 2023 r. | Baidu | Chiny |

| OpenAI GPT-3.5 | 175B | NIE | Pod koniec 2022 r. | OpenAI | Stany Zjednoczone |

| Klaudiusz | Nie określono | NIE | Nie określono | Antropiczny | Stany Zjednoczone |

| Cohere | Nieujawnione publicznie (ogromne) | NIE | Bieżący rozwój | Cohere | Kanada |

| Google PaLM (koncentracja na badaniach) | Nieujawnione publicznie (prawdopodobnie bardzo duże) | NIE | W trakcie opracowywania | Google AI | Stany Zjednoczone |

| OpenAI GPT-4 | Nieujawnione publicznie (następca GPT-3.5) | NIE | W trakcie opracowywania | OpenAI | Stany Zjednoczone |

Porównanie krajów rozwoju LLM

Porównując 15 największych dużych modeli językowych (LLM), Stany Zjednoczone mają prawie 67% udziału w rynku rozwoju LLM w 10 z 15 modeli.

| Kraj rozwoju | Liczba modeli |

| Kanada | 1 |

| Chiny | 1 |

| Francja | 1 |

| Izrael | 1 |

| ZJEDNOCZONE EMIRATY ARABSKIE | 1 |

| Stany Zjednoczone | 10 |

| Łącznie | 15 |

Architektury i metody szkoleniowe LLM

| Architektura/Metoda | Opis |

|---|---|

| Transformator | Architektura sieci neuronowej, która opiera się na mechanizmach uwagi w celu poprawy wydajności i dokładności przetwarzania danych sekwencyjnych. Jest to podstawa wielu nowoczesnych LLM. |

| Szkolenie wstępne | Początkowy etap szkolenia LLM, polegający na wystawieniu go na działanie ogromnej ilości nieoznakowanych danych tekstowych w celu poznania statystycznych wzorców i struktur języka. |

| Dostrajanie | Udoskonalanie wstępnie wytrenowanego modelu poprzez trenowanie go na konkretnych danych związanych z określonym zadaniem, zwiększając jego wydajność dla tego zadania. |

| QLoRA | Metoda polegająca na wstecznej propagacji gradientów przez zamrożony, 4-bitowy kwantyzowany wstępnie wytrenowany model językowy do adapterów niskiej rangi (LoRA), umożliwiająca wydajne dostrajanie. |

Architektura transformatorowa zrewolucjonizowała dziedzinę przetwarzania języka naturalnego, umożliwiając modelom bardziej efektywną obsługę długich sekwencji danych. Wstępne szkolenie i dostrajanie są krytycznymi etapami w rozwoju LLM, pozwalając im uczyć się z ogromnych ilości danych, a następnie specjalizować się w określonych zadaniach. QLoRA reprezentuje zaawansowaną technikę dostrajania LLM, zmniejszając zapotrzebowanie na pamięć przy jednoczesnym zachowaniu wydajności

Kluczowe przypadki użycia dużych modeli językowych

Jak LLM rewolucjonizują tłumaczenie językowe i analizę nastrojów

LLM przekształciły tłumaczenie językowe poprzez zrozumienie i tłumaczenie ogromnych ilości danych, podczas gdy analiza sentymentu stała się bardziej zniuansowana dzięki ich możliwościom głębokiego uczenia się.

Ulepszanie interakcji człowiek-maszyna za pomocą chatbotów

Chatboty obsługiwane przez LLM oferują spersonalizowaną i wydajną obsługę klienta, zmieniając oblicze obsługi klienta.

Transformacja tworzenia treści dzięki generatywnej sztucznej inteligencji

Modele generatywnej sztucznej inteligencji, takie jak GPT-3, umożliwiły szybkie tworzenie wysokiej jakości treści, pomagając zarówno pisarzom, jak i projektantom.

Wyzwania i ograniczenia związane z wdrażaniem LLM

Rozwiązywanie problemów związanych z uprzedzeniami i etycznym użytkowaniem

Dane szkoleniowe dla LLM mogą wprowadzać uprzedzenia, budząc obawy etyczne, którymi należy się zająć.

Zrozumienie kosztów obliczeniowych szkolenia dużych modeli

Szkolenie LLM wymaga znacznych zasobów obliczeniowych, co może być kosztowne i nieekologiczne.

Ograniczenia w rozumieniu języka i pojmowaniu kontekstu

Pomimo swoich możliwości, LLM wciąż mają trudności ze zrozumieniem kontekstu i subtelności ludzkiego języka.

Jak duże modele językowe są trenowane i dostrajane?

Znaczenie ogromnych ilości danych we wstępnym szkoleniu LLM

LLM wymagają dużych zbiorów danych, aby nauczyć się szerokiego zakresu wzorców i niuansów językowych.

Techniki dostrajania do konkretnych zastosowań

Techniki takie jak uczenie transferowe i dostrajanie za pomocą modeli transformatorowych są wykorzystywane do dostosowywania LLM do konkretnych zadań.

Pojawienie się modeli fundamentalnych w uczeniu maszynowym

Modele fundamentalne to nowy trend w uczeniu maszynowym, zapewniający bazę do budowania wyspecjalizowanych modeli.

Różnice między treningiem wstępnym a treningiem specyficznym dla zadania

Trening wstępny i trening specyficzny dla zadania (często określany jako dostrajanie) to dwie krytyczne fazy rozwoju dużych modeli językowych (LLM). Etapy te mają fundamentalne znaczenie dla sposobu, w jaki LLM rozumieją i generują tekst podobny do ludzkiego, a każdy z nich służy odrębnemu celowi w procesie uczenia się modelu.

Wstępne szkolenie LLM

Wstępne szkolenie to początkowa, obszerna faza, w której LLM uczy się na podstawie ogromnego korpusu danych tekstowych. Etap ten przypomina przekazywanie modelowi szerokiej wiedzy na temat języka, kultury i wiedzy ogólnej. Oto kluczowe aspekty szkolenia wstępnego:

- Baza wiedzy ogólnej: Model rozwija zrozumienie gramatyki, idiomów, faktów i kontekstu poprzez analizę dużego korpusu tekstu. Ta szeroka baza wiedzy umożliwia modelowi generowanie spójnych i kontekstowo odpowiednich odpowiedzi.

- Transfer Learning: Wstępnie wytrenowane modele mogą stosować wyuczone wzorce językowe do nowych zestawów danych, co jest szczególnie przydatne w przypadku zadań z ograniczoną ilością danych. Zdolność ta znacznie zmniejsza zapotrzebowanie na obszerne dane specyficzne dla zadania.

- Efektywność kosztowa: Pomimo znacznych zasobów obliczeniowych wymaganych do wstępnego szkolenia, ten sam model może być ponownie wykorzystany w różnych aplikacjach, co czyni go opłacalnym podejściem.

- Elastyczność i skalowalność: Szerokie zrozumienie uzyskane podczas wstępnego szkolenia pozwala na dostosowanie tego samego modelu do różnych zadań. Dodatkowo, w miarę dostępności nowych danych, wstępnie wytrenowane modele mogą być dalej szkolone w celu poprawy ich wydajności.

Trening specyficzny dla zadania (dostrajanie)

Po wstępnym szkoleniu modele przechodzą dostrajanie, w którym są szkolone na mniejszych, specyficznych dla zadania zestawach danych. Ta faza dostosowuje szeroką wiedzę modelu, aby dobrze radził sobie z określonymi zadaniami. Kluczowe aspekty dostrajania obejmują:

- Specjalizacja zadań: Precyzyjne dostrajanie dostosowuje wstępnie wytrenowane modele do określonych zadań lub branż, zwiększając ich wydajność w konkretnych zastosowaniach.

- Wydajność i szybkość przetwarzania danych: Ponieważ model nauczył się już ogólnych wzorców językowych podczas wstępnego szkolenia, dostrojenie wymaga mniejszej ilości danych i czasu, aby wyspecjalizować model do określonych zadań.

- Dostosowanie modelu: Precyzyjne dostrojenie pozwala na dostosowanie modelu do unikalnych wymagań różnych zadań, dzięki czemu jest on wysoce adaptowalny do niszowych zastosowań.

- Efektywne gospodarowanie zasobami: Precyzyjne dostrajanie jest szczególnie korzystne w przypadku aplikacji o ograniczonych zasobach obliczeniowych, ponieważ wykorzystuje ciężką pracę wykonaną podczas wstępnego szkolenia.

Podsumowując, wstępne szkolenie zapewnia modelom LLM szerokie zrozumienie języka i wiedzę ogólną, podczas gdy dostrajanie dostosowuje tę wiedzę do doskonałości w określonych zadaniach. Wstępne szkolenie stanowi podstawę dla możliwości językowych modelu, a dostrajanie optymalizuje te możliwości pod kątem konkretnych zastosowań, równoważąc uogólnienie modelu ze specjalizacją.

Przyszłość dużych modeli językowych

Przewidywanie LLM następnej generacji: GPT-4 i kolejne

Następna generacja LLM, jak GPT-4, oczekuje się, że jeszcze bardziej przesunie granice tego, co jest możliwe w sztucznej inteligencji.

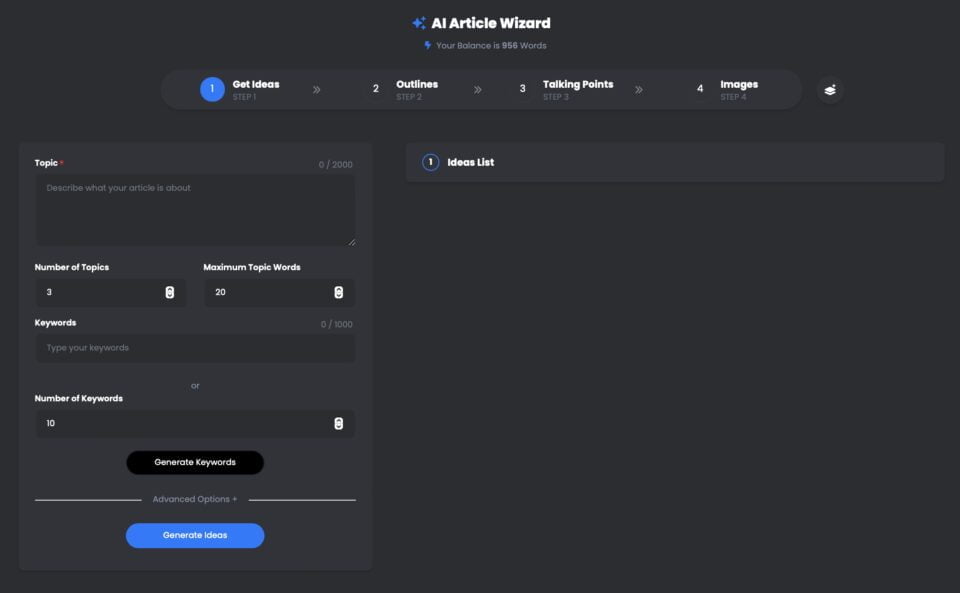

Kreator artykułów UberCreate AI to potężne narzędzie, które wykorzystuje duży model językowy OpenAI GPT-4 (LLM) do generowania wysokiej jakości artykułów w ciągu kilku minut.

Dzięki UberCreate możesz pożegnać się z blokadą pisarską i przywitać się ze szczegółowym artykułem w ciągu kilku minut. Wystarczy podać temat, słowo kluczowe i docelową liczbę słów, a UberCreate zajmie się resztą. Wygeneruje zarys artykułu, punkty do dyskusji, odpowiednie obrazy i ostateczny artykuł gotowy do publikacji.

Kreator artykułów UberCreate AI przy użyciu GPT-4

Pin

Pin UberCreate wykorzystuje zaawansowaną technologię sztucznej inteligencji do tworzenia treści, które są oryginalne, angażujące i pouczające. Może pisać na dowolny temat, od biznesu i marketingu po zdrowie i styl życia. Może również dostosowywać się do różnych tonów, stylów i formatów, w zależności od preferencji i potrzeb użytkownika.

UberCreate to nie tylko generator treści, ale także narzędzie do jej ulepszania. Może pomóc ci ulepszyć istniejące artykuły, dodając więcej szczegółów, faktów i obrazów. Może również sprawdzić gramatykę, pisownię i czytelność, a także zasugerować sposoby optymalizacji treści pod kątem SEO i mediów społecznościowych.

UberCreate to jedyne narzędzie AI do tworzenia treści, jakiego kiedykolwiek będziesz potrzebować. Łączy w sobie 17 narzędzi AI w jednym, w tym generator postów na blogu, generator treści w mediach społecznościowych, generator treści wizualnych i wiele innych. Został zaprojektowany, aby ułatwić każdy aspekt tworzenia treści, od pomysłu po produkcję.

Niezależnie od tego, czy jesteś blogerem, marketerem, studentem czy profesjonalistą, UberCreate może pomóc Ci zaoszczędzić czas, pieniądze i wysiłek związany z tworzeniem wysokiej jakości treści. Możesz wypróbować go za darmo i samemu przekonać się o rezultatach.

Poszerzanie granic współpracy człowieka ze sztuczną inteligencją

LLM mają usprawnić współpracę między ludźmi a sztuczną inteligencją, czyniąc interakcje bardziej naturalnymi i produktywnymi.

Te wybitne modele LLM to tylko wierzchołek góry lodowej, jeśli chodzi o zrozumienie ogromnego potencjału dużych modeli językowych w rewolucjonizowaniu naszych interakcji z technologią i poszerzaniu granic współpracy człowieka ze sztuczną inteligencją. Bądź na bieżąco z częścią II tej serii, w której zagłębimy się w możliwości dużych modeli językowych, ich zastosowania w różnych branżach oraz wyzwania związane z wykorzystaniem ich mocy.

Perspektywy rozumienia języka naturalnego w nadchodzącej dekadzie

Przyszłość dla rozumienia języka naturalnego rysuje się w jasnych barwach, a LLM stają się coraz bardziej zaawansowane i zintegrowane z różnymi aplikacjami.

Podsumowując, LLM, takie jak BERT, GPT-3 i ich następcy, rewolucjonizują branże, od edukacji po opiekę zdrowotną. Ponieważ nadal wykorzystujemy ich moc, musimy również radzić sobie z wyzwaniami, jakie stawiają, zapewniając ich etyczne i odpowiedzialne wykorzystanie. Podróż do świata dużych modeli językowych dopiero się rozpoczyna, a możliwości są tak ogromne, jak zbiory danych, z których się uczą. Zanurz się w tej ekscytującej dziedzinie i wspólnie kształtujmy przyszłość sztucznej inteligencji.

Często zadawane pytania (FAQ)

Czym jest Large Language Model (LLM) w kontekście NLP?

Duży model językowy (LLM), w zakresie przetwarzania języka naturalnego (NLP), odnosi się do zaawansowanego systemu sztucznej inteligencji zaprojektowanego do rozumienia, interpretowania i generowania tekstu podobnego do ludzkiego. Modele te są szkolone na dużych ilościach danych, umożliwiając im wykonywanie szerokiego zakresu zadań językowych. W procesie szkolenia model uczy się przewidywać następne słowo w zdaniu, pomagając mu generować spójny i kontekstowo odpowiedni tekst na żądanie.

Jakie są rodzaje studiów LLM dostępnych w 2024 roku?

Od 2024 r. dostępnych jest kilka różnych typów dużych modeli językowych, z których każdy ma unikalne możliwości. Do najbardziej godnych uwagi należą modele takie jak GPT-4, który jest znany ze swoich zdolności generowania tekstu i Bard, który jest odpowiednikiem Google skupiającym się na szerokim zakresie zadań NLP. Modele te różnią się liczbą parametrów, danymi, na których zostały przeszkolone, oraz konkretnymi zastosowaniami, od prostego generowania tekstu po złożone zadania rozumienia języka.

Jak trenuje się LLM na dużych zbiorach danych?

Modele LLM są szkolone przy użyciu ogromnych zbiorów danych zebranych z Internetu, w tym książek, artykułów i stron internetowych. Ten rozległy proces szkolenia obejmuje dostarczanie modelowi dużych ilości danych tekstowych, co pomaga modelowi identyfikować wzorce, rozumieć kontekst i uczyć się struktur językowych. Proces uczenia może trwać tygodnie, a nawet miesiące, w zależności od wielkości modelu i dostępnych zasobów obliczeniowych. Celem jest umożliwienie modelowi generowania tekstu, który jest nie do odróżnienia od tekstu napisanego przez ludzi.

Czy możesz wyjaśnić zastosowania LLM w codziennych zadaniach?

LLM mogą być wykorzystywane w różnych aplikacjach do upraszczania i automatyzacji codziennych zadań. Obejmuje to chatboty i wirtualnych asystentów do obsługi klienta, narzędzia do tworzenia treści do generowania artykułów lub raportów oraz usługi tłumaczeniowe do konwersji tekstu między językami. Inne zastosowania obejmują analizę nastrojów w celu oceny opinii publicznej w mediach społecznościowych, narzędzia do podsumowywania w celu skondensowania długich dokumentów w krótsze wersje, a nawet asystentów kodowania, aby pomóc programistom poprzez generowanie fragmentów kodu. Zasadniczo, LLM zrewolucjonizowały nasz sposób interakcji z technologią, czyniąc ją bardziej intuicyjną i podobną do ludzkiej.

Czym różnią się możliwości dużych modeli językowych od tradycyjnych modeli?

Duże modele językowe znacznie przewyższają tradycyjne modele na kilka sposobów. Po pierwsze, ze względu na ich rozległe szkolenie na różnych zestawach danych, LLM mogą generować bardziej spójne, zróżnicowane i kontekstowo odpowiednie odpowiedzi. Lepiej rozumieją niuanse językowe i skuteczniej radzą sobie z danymi sekwencyjnymi. Co więcej, sama liczba parametrów w LLM umożliwia bardziej wyrafinowane rozumowanie i możliwości predykcyjne w porównaniu z tradycyjnymi modelami, które były bardziej ograniczone pod względem zakresu i skalowalności. Ostatecznie, LLM oferują bardziej zniuansowane i wszechstronne podejście do przetwarzania i generowania języka.

Jakie wyzwania wiążą się z opracowywaniem i wdrażaniem programów LLM?

Opracowywanie i wdrażanie LLM wiąże się z kilkoma wyzwaniami, w tym z zasobami obliczeniowymi wymaganymi do szkolenia, które mogą być znaczne. Ponadto istnieją obawy dotyczące stronniczości w danych szkoleniowych, co może prowadzić do generowania przez model uprzedzeń lub szkodliwych treści. Kwestie prywatności wynikają również z wrażliwości danych wykorzystywanych w szkoleniach. Co więcej, interpretowalność tych modeli stanowi wyzwanie, ponieważ ich proces decyzyjny jest złożony i nie zawsze przejrzysty. Wreszcie, coraz większe obawy budzi wpływ energochłonnego procesu szkolenia na środowisko.

Jak modele językowe takie jak GPT-4 i Bard wpływają na dziedzinę NLP?

Modele takie jak GPT-4 i Bard znacząco rozwinęły dziedzinę przetwarzania języka naturalnego, wykazując bezprecedensową wydajność w szerokim zakresie zadań NLP. Ich zdolność do generowania tekstu, rozumienia kontekstu i tworzenia odpowiedzi podobnych do ludzkich wyznaczyła nowe standardy tego, co sztuczna inteligencja może osiągnąć w zakresie rozumienia i tworzenia języka. Modele te nie tylko poprawiły jakość i wydajność aplikacji takich jak chatboty, generowanie treści i tłumaczenia językowe, ale także otworzyły nowe możliwości badań i rozwoju w NLP, przesuwając granice możliwości AI.

Czy istnieje przewodnik dla początkujących dotyczący zrozumienia i pracy z LLM?

Tak, dla osób początkujących w tej dziedzinie, przewodnik dla początkujących po dużych modelach językowych może być niezwykle pomocny. Taki przewodnik zazwyczaj obejmuje podstawy tego, czym są LLM, jak są szkolone i jakie są ich zastosowania. Może oferować wgląd w najważniejsze modele w 2023 roku, wyjaśniać podstawową technologię i podawać przykłady zadań NLP, które można wykonać za pomocą LLM. Początkujący mogą poszukać zasobów online, samouczków i kursów, które oferują wprowadzenie do tych koncepcji, pomagając zbudować fundamentalne zrozumienie tego, jak działają LLM i jak można je wykorzystać w różnych projektach.