Полное руководство по популярным большим языковым моделям

Представьте, что вы пытаетесь написать идеальный рассказ, ваши пальцы зависли над клавиатурой, а чистая страница дразнит вас. Вдруг вы вспомнили о своем секретном оружии: большой языковой модели (LLM). С помощью нескольких подсказок LLM сплетает настолько увлекательную историю, что это похоже на волшебство. Это лишь один из примеров силы LLM, сложных систем искусственного интеллекта, которые меняют наши представления о взаимодействии с технологиями.

В постоянно меняющемся и интригующем мире искусственного интеллекта (ИИ) большие языковые модели (БЯМ) набирают обороты благодаря своим впечатляющим возможностям в работе с человеческим языком. Но что именно представляют собой эти LLM и как они меняют наше повседневное взаимодействие и задачи? Давайте погрузимся в эту увлекательную сферу и раскроем некоторые из самых выдающихся LLM, формирующих будущее ИИ.

Понимание больших языковых моделей

LLM - это продвинутые модели машинного обучения, которые предсказывают и генерируют человекоподобные тексты. Они могут автозаполнять предложения, переводить языки и даже создавать целые статьи. Эти модели прошли путь от простых предсказателей слов до сложных систем, способных обрабатывать абзацы и документы.

Как работают большие языковые модели?

LLM оценивают вероятности последовательностей слов, используя обширные базы данных для изучения языковых паттернов. Они построены на архитектурах типа Transformers, которые фокусируются на наиболее значимых частях входных данных для эффективной обработки длинных последовательностей.

Эволюция LLM: От BERT до GPT-4

BERT, представленный Google в 2018 году, стал прорывом, используя двунаправленный контекст для понимания нюансов языка. GPT-4 с его 178 миллиардами параметров поднял генерацию текста на новую высоту, продемонстрировав способность генерировать человекоподобный текст.

Примеры больших языковых моделей в действии

ChatGPTВариант моделей GPT от OpenAI стал известным благодаря чат-ботам, которые обеспечивают человекоподобное взаимодействие.

Влияние BERT на задачи обработки естественного языка

BERT позволил значительно повысить производительность задач обработки естественного языка, таких как анализ настроения и языковой перевод.

GPT-3 и граница генерации текста

Способность GPT-3 генерировать креативный и связный текст открыла новые возможности в создании контента и не только.

Шпаргалка по сравнению современных крупных языковых моделей

Чтобы лучше понять масштабы и разнообразие больших языковых моделей, давайте рассмотрим некоторые из наиболее влиятельных общедоступных моделей, которые в настоящее время доминируют на рынке. Каждая модель обладает уникальными достоинствами и отлично подходит для различных случаев использования.

В этой таблице представлен краткий обзор некоторых наиболее влиятельных больших языковых моделей по состоянию на 2024 год. BERT, представленная компанией Google, известна своей архитектурой на основе трансформаторов и стала значительным достижением в решении задач обработки естественного языка. КлодРазработанная компанией Anthropic, она посвящена конституционному ИИ и нацелена на то, чтобы сделать результаты работы ИИ полезными, безвредными и точными. CohereLLM для предприятий предлагает индивидуальное обучение и тонкую настройку для конкретных случаев использования в компании. Эрни из Baidu обладает ошеломляющим количеством параметров - 10 триллионов - и предназначен для работы на мандаринском языке, но способен работать и на других языках.

Локальные LLM против облачных LLM

Хотя облачные LLM предлагают впечатляющие возможности, растущей тенденцией является использование локального вывода с моделями с открытым исходным кодом. Такие инструменты, как LM Studio, позволяют пользователям запускать запускать LLM локально непосредственно на их машинах.

В этом подходе приоритет отдается конфиденциальности, поскольку все данные и обработка выполняются в автономном режиме. Однако для локального вывода обычно требуется более мощное оборудование, и доступ к самым современным моделям может быть ограничен из-за их размера.

Топ-15 популярных моделей больших языков

| Название модели | Размер (параметры) | Открытый исходный код? | Последнее обновление (оценочное) | Компания | Страна разработки |

| AI21 Studios Jurassic-1 Jumbo | 178B | Да | Декабрь 2022 года | AI21 Studios | Израиль |

| Google Джемма | 2B или 7B | Да | Май 2023 года | Google AI | Соединенные Штаты |

| Meta LLaMA 13B | 13B | Да | Начало 2023 года | Мета ИИ | Соединенные Штаты |

| Meta LLaMA 7B | 7B | Да | Начало 2023 года | Мета ИИ | Соединенные Штаты |

| EleutherAI GPT-J | 6B | Да | Май 2023 года (через развилки типа Dolly 2) | EleutherAI (исследовательская группа) | Соединенные Штаты |

| Куча - EleutherAI | 900 ГБ текстовых данных | Да | Постоянное развитие | EleutherAI (исследовательская группа) | Соединенные Штаты |

| Mistral AI - Mistral Large | Не разглашается (крупный) | Открытый исходный код с платными опциями | Сентябрь 2023 года | Мистраль ИИ | Франция |

| Falcon 180B | 180B | Да | Не указано | Институт технологических инноваций | ОАЭ |

| БЕРТ | 342 миллиона | Нет | Июль 2018 г. | Google AI | Соединенные Штаты |

| Эрни | 10 триллионов | Нет | Август 2023 года | Baidu | Китай |

| OpenAI GPT-3.5 | 175B | Нет | Конец 2022 года | OpenAI | Соединенные Штаты |

| Клод | Не указано | Нет | Не указано | Антропология | Соединенные Штаты |

| Cohere | Не разглашается (массово) | Нет | Постоянное развитие | Cohere | Канада |

| Google PaLM (исследовательский фокус) | Не разглашается (скорее всего, очень крупная) | Нет | В стадии разработки | Google AI | Соединенные Штаты |

| OpenAI GPT-4 | Не разглашается (преемник GPT-3.5) | Нет | В стадии разработки | OpenAI | Соединенные Штаты |

Сравнение стран развития LLM

Если сравнивать 15 лучших больших языковых моделей (LLM), то на долю Соединенных Штатов приходится почти 67% доли рынка разработки LLM в 10 случаях из 15.

| Страна разработки | Количество моделей |

| Канада | 1 |

| Китай | 1 |

| Франция | 1 |

| Израиль | 1 |

| ОАЭ | 1 |

| Соединенные Штаты | 10 |

| Итого | 15 |

Архитектуры и методы обучения LLM

| Архитектура/метод | Описание |

|---|---|

| Трансформатор | Архитектура нейронной сети, которая опирается на механизмы внимания для повышения эффективности и точности обработки последовательных данных. Она лежит в основе многих современных LLM. |

| Предтренировочный курс | Начальная стадия обучения LLM, когда он подвергается воздействию огромного количества немаркированных текстовых данных для изучения статистических моделей и структур языка. |

| Тонкая настройка | Уточнение предварительно обученной модели путем ее тренировки на конкретных данных, связанных с конкретной задачей, что повышает ее эффективность для этой задачи. |

| QLoRA | Метод обратного распространения градиентов через замороженную 4-битную квантованную предварительно обученную языковую модель в адаптеры низкого ранга (LoRA), позволяющий эффективно выполнять тонкую настройку. |

Архитектура трансформаторов произвела революцию в области обработки естественного языка, позволив моделям более эффективно обрабатывать длинные последовательности данных. Предварительное обучение и тонкая настройка являются важнейшими этапами в развитии LLM, позволяя им обучаться на огромных объемах данных и затем специализироваться на выполнении конкретных задач. QLoRA представляет собой передовую методику тонкой настройки LLM, позволяющую снизить требования к памяти при сохранении производительности.

Ключевые случаи использования больших языковых моделей

Как LLM революционизируют языковой перевод и анализ настроения

LLM-технологии изменили языковой перевод, позволяя понимать и переводить огромные объемы данных, а анализ настроений стал более тонким благодаря возможностям глубокого обучения.

Улучшение человеко-машинного взаимодействия с помощью чатботов

Чат-боты, созданные на базе LLM, обеспечивают персонализированную и эффективную поддержку клиентов, меняя представление об обслуживании клиентов.

Преобразование создания контента с помощью генеративного искусственного интеллекта

Генеративные модели ИИ, такие как GPT-3, позволяют быстро создавать высококачественный контент, помогая как писателям, так и дизайнерам.

Проблемы и ограничения при внедрении LLM

Решение проблем, связанных с предвзятостью и этичностью использования

Учебные данные для LLM могут быть предвзятыми, что вызывает этические проблемы, требующие решения.

Понимание вычислительных затрат на обучение больших моделей

Обучение LLM требует значительных вычислительных ресурсов, что может быть дорогостоящим и экологически неустойчивым.

Ограничения в понимании языка и восприятии контекста

Несмотря на свои возможности, LLM все еще испытывают трудности с пониманием контекста и тонкостей человеческого языка.

Как обучаются и настраиваются большие языковые модели

Важность огромных объемов данных для предварительной подготовки магистров

Для изучения широкого спектра языковых моделей и нюансов LLM требуются большие массивы данных.

Тонкая настройка техники для конкретных задач

Для адаптации LLM к конкретным задачам используются такие техники, как трансферное обучение и тонкая настройка с помощью трансформаторных моделей.

Появление базовых моделей в машинном обучении

Базовые модели - новое направление в машинном обучении, обеспечивающее основу для построения специализированных моделей.

Различия между предтренировочным и специфическим обучением

Предварительное обучение и обучение под конкретную задачу (часто называемое тонкой настройкой) - два важнейших этапа в разработке больших языковых моделей (БЯМ). Эти этапы являются основой того, как LLM понимают и генерируют человекоподобный текст, и каждый из них служит отдельной цели в процессе обучения модели.

Предварительное обучение LLM

Предварительное обучение - это начальный, обширный этап, на котором LLM обучается на обширном корпусе текстовых данных. Этот этап сродни тому, чтобы дать модели широкое образование в области языка, культуры и общих знаний. Вот ключевые аспекты предварительного обучения:

- Общая база знаний: Модель развивает понимание грамматики, идиом, фактов и контекста, анализируя большой корпус текстов. Эта обширная база знаний позволяет модели генерировать связные и контекстуально подходящие ответы.

- Трансферное обучение: Предварительно обученные модели могут применять изученные языковые паттерны к новым наборам данных, что особенно полезно для задач с ограниченным количеством данных. Эта способность значительно снижает потребность в обширных данных для конкретной задачи.

- Экономическая эффективность: Несмотря на значительные вычислительные ресурсы, необходимые для предварительного обучения, одна и та же модель может быть повторно использована в различных приложениях, что делает этот подход экономически эффективным.

- Гибкость и масштабируемость: Широкое понимание, полученное в ходе предварительного обучения, позволяет адаптировать одну и ту же модель для решения различных задач. Кроме того, по мере поступления новых данных можно продолжить обучение предварительно обученных моделей, чтобы повысить их производительность.

Обучение конкретным задачам (тонкая настройка)

После предварительного обучения модели подвергаются тонкой настройке, в ходе которой они обучаются на небольших наборах данных, специфичных для конкретной задачи. На этом этапе широкие знания модели адаптируются для успешного решения конкретных задач. Ключевые аспекты тонкой настройки включают:

- Специализация задач: Тонкая настройка адаптирует предварительно обученные модели к конкретным задачам или отраслям, повышая их производительность в конкретных приложениях.

- Эффективность и скорость обработки данных: Поскольку модель уже изучила общие языковые шаблоны во время предварительного обучения, тонкая настройка требует меньше данных и времени для специализации модели под конкретные задачи.

- Персонализация модели: Тонкая настройка позволяет подстраивать модель под уникальные требования различных задач, что делает ее легко адаптируемой к нишевым приложениям.

- Эффективность использования ресурсов: Тонкая настройка особенно полезна для приложений с ограниченными вычислительными ресурсами, поскольку она позволяет использовать тяжелую работу, выполненную во время предварительного обучения.

Таким образом, предварительное обучение вооружает LLM широким пониманием языка и общими знаниями, а тонкая настройка адаптирует эти знания для успешного выполнения конкретных задач. Предварительное обучение закладывает основу языковых возможностей модели, а тонкая настройка оптимизирует эти возможности для целевых приложений, балансируя между обобщением и специализацией модели.

Будущее больших языковых моделей

Предвосхищение LLM следующего поколения: GPT-4 и далее

Следующее поколение LLM, как и GPT-4, как ожидается, еще больше расширит границы возможного в искусственном интеллекте.

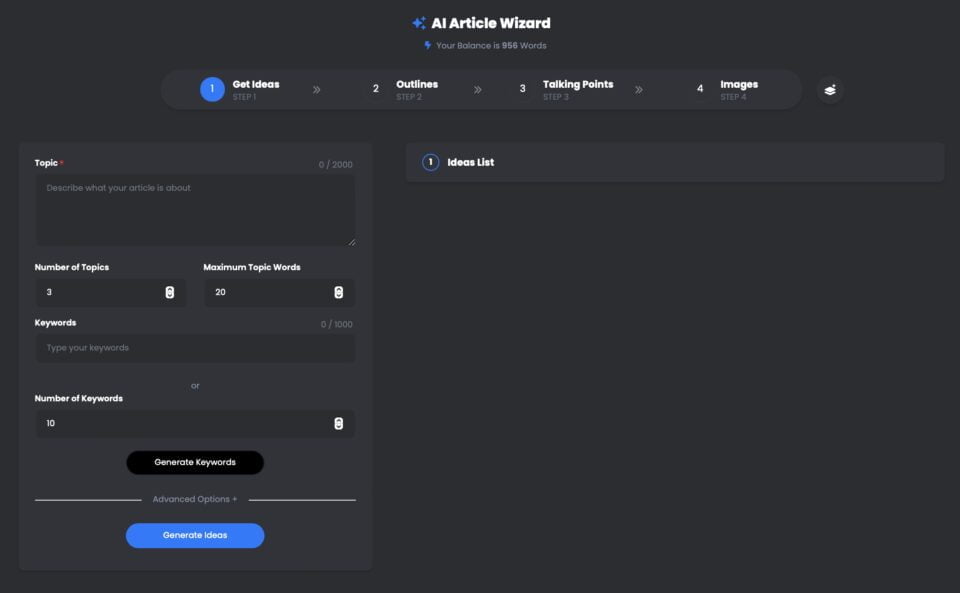

Мастер создания статей UberCreate AI Это мощный инструмент, использующий большую языковую модель (LLM) OpenAI GPT-4 для создания высококачественных статей за считанные минуты.

С UberCreate вы можете попрощаться с писательским блоком и поздороваться с подробной статьей за считанные минуты. Вам нужно только указать тему, ключевое слово и количество слов, а UberCreate позаботится обо всем остальном. Он создаст набросок статьи, тезисы, соответствующие изображения и готовую к публикации статью.

UberCreate AI Article Wizard Using GPT-4

Pin

Pin UberCreate использует передовую технологию искусственного интеллекта для создания оригинального, увлекательного и информативного контента. Он может писать на любые темы - от бизнеса и маркетинга до здоровья и образа жизни. Он также может адаптироваться к различным тонам, стилям и форматам в зависимости от ваших предпочтений и потребностей.

UberCreate - это не только генератор контента, но и его улучшитель. Он поможет вам улучшить существующие статьи, добавив в них больше деталей, фактов и изображений. Он также может проверить грамматику, орфографию и читабельность, а также предложить способы оптимизации контента для SEO и социальных сетей.

UberCreate - это единственный инструмент для создания контента с искусственным интеллектом, который вам когда-либо понадобится. Он объединяет в себе 17 инструментов искусственного интеллекта, включая генератор постов для блога, генератор контента для социальных сетей, генератор визуального контента и многое другое. Он призван облегчить все аспекты создания контента - от идеи до производства.

Будь вы блогер, маркетолог, студент или профессионал, UberCreate поможет вам сэкономить время, деньги и силы на создание качественного контента. Вы можете попробовать его бесплатно и убедиться в результатах сами.

Расширение границ сотрудничества человека и ИИ

LLMs призваны расширить сотрудничество между людьми и ИИ, сделав взаимодействие более естественным и продуктивным.

Эти выдающиеся LLM - лишь верхушка айсберга, когда речь заходит о понимании огромного потенциала больших языковых моделей в революционном изменении нашего взаимодействия с технологиями и расширении границ сотрудничества человека и ИИ. Следите за новостями во второй части этой серии, где мы подробнее рассмотрим возможности больших языковых моделей, их применение в различных отраслях и проблемы, возникающие при использовании их потенциала.

Перспективы развития понимания естественного языка в ближайшее десятилетие

Будущее понимания естественного языка выглядит блестяще, поскольку LLM становятся все более сложными и интегрируются в различные приложения.

В заключениеТакие LLM, как BERT, GPT-3 и их преемники, совершают революцию в различных отраслях, от образования до здравоохранения. По мере того как мы продолжаем использовать их возможности, мы также должны преодолевать проблемы, которые они представляют, обеспечивая их этичное и ответственное использование. Путешествие в мир больших языковых моделей только начинается, и его возможности столь же обширны, как и наборы данных, на которых они обучаются. Погрузитесь в эту захватывающую область, и давайте вместе формировать будущее ИИ.

Часто задаваемые вопросы (FAQ)

Что такое большая языковая модель (LLM) в контексте НЛП?

Большая языковая модель (LLM) в рамках обработки естественного языка (NLP) относится к продвинутой системе искусственного интеллекта, предназначенной для понимания, интерпретации и генерации человекоподобного текста. Эти модели обучаются на больших объемах данных, что позволяет им выполнять широкий спектр языковых задач. В процессе обучения модель учится предсказывать следующее слово в предложении, что помогает ей генерировать связный и контекстуально релевантный текст по запросу.

Какие различные виды магистратуры будут доступны в 2024 году?

По состоянию на 2024 год существует несколько различных типов больших языковых моделей, каждая из которых обладает уникальными возможностями. Наиболее заметные из них включают такие модели, как GPT-4, известная своими способностями к генерации текста, и Bard - аналог Google, ориентированный на широкий спектр задач НЛП. Эти модели различаются количеством параметров, данными, на которых они обучались, и спецификой применения - от простой генерации текста до сложных задач понимания языка.

Как обучают LLM на больших наборах данных?

Для обучения LLM используются обширные массивы данных, собранные в Интернете, включая книги, статьи и веб-сайты. Этот обширный процесс обучения включает в себя подачу модели большого количества текстовых данных, что помогает ей выявлять закономерности, понимать контекст и изучать языковые структуры. Процесс обучения может занимать недели или даже месяцы, в зависимости от размера модели и доступных вычислительных ресурсов. Цель состоит в том, чтобы модель могла генерировать текст, неотличимый от написанного человеком.

Можете ли вы объяснить применение LLM в повседневных задачах?

LLM могут использоваться в различных приложениях для упрощения и автоматизации повседневных задач. К ним относятся чат-боты и виртуальные помощники для обслуживания клиентов, инструменты создания контента для подготовки статей или отчетов, а также сервисы перевода для преобразования текста с одного языка на другой. Другие приложения включают анализ настроений для изучения общественного мнения в социальных сетях, инструменты для сжатия длинных документов в более короткие версии и даже помощники по кодированию, помогающие программистам генерировать фрагменты кода. По сути, LLM произвели революцию в нашем взаимодействии с технологиями, сделав его более интуитивным и человекоподобным.

Чем возможности больших языковых моделей отличаются от традиционных моделей?

Большие языковые модели значительно превосходят традиционные модели по нескольким параметрам. Во-первых, благодаря обширному обучению на разнообразных наборах данных, LLM могут генерировать более последовательные, разнообразные и контекстуально подходящие ответы. Они лучше понимают нюансы языка и эффективнее обрабатывают последовательные данные. Более того, огромное количество параметров в LLM позволяет проводить более сложные рассуждения и предсказания по сравнению с традиционными моделями, которые были более ограничены в масштабах и возможностях. В конечном итоге, LLM предлагают более тонкий и универсальный подход к обработке и созданию языка.

Какие проблемы связаны с разработкой и внедрением LLM?

Разработка и внедрение LLM сопряжены с рядом проблем, включая вычислительные ресурсы, необходимые для обучения, которые могут быть значительными. Кроме того, существуют опасения относительно предвзятости обучающих данных, что может привести к тому, что модель будет генерировать предвзятый или вредный контент. Вопросы конфиденциальности также возникают из-за чувствительности данных, используемых в обучении. Кроме того, возникает проблема интерпретируемости этих моделей, поскольку процесс принятия решений в них сложен и не всегда прозрачен. Наконец, все большую озабоченность вызывает воздействие энергоемкого процесса обучения на окружающую среду.

Как такие языковые модели, как GPT-4 и Bard, влияют на область НЛП?

Такие модели, как GPT-4 и Bard, значительно продвинули область обработки естественного языка, продемонстрировав беспрецедентную производительность в широком спектре задач НЛП. Их способность генерировать текст, понимать контекст и выдавать человекоподобные ответы установила новые стандарты того, чего может достичь ИИ в понимании и создании языка. Эти модели не только повысили качество и эффективность таких приложений, как чат-боты, генерация контента и языковой перевод, но и открыли новые пути для исследований и разработок в области НЛП, расширив границы возможностей ИИ.

Существует ли руководство для начинающих по пониманию и работе с LLM?

Да, для новичков в этой области руководство для начинающих по большим языковым моделям может быть невероятно полезным. Как правило, такое руководство охватывает основы того, что такое LLM, как они обучаются и где применяются. В нем можно узнать о наиболее значимых моделях в 2023 году, объяснить технологию, лежащую в их основе, и привести примеры задач НЛП, которые могут быть выполнены с помощью LLM. Начинающие могут поискать онлайн-ресурсы, учебники и курсы, которые предлагают введение в эти понятия, помогая сформировать базовое понимание того, как работают LLM и как их можно использовать в различных проектах.