La guida definitiva ai modelli linguistici più diffusi

Immaginate di stare lottando per scrivere la storia perfetta, con le dita in bilico sulla tastiera mentre la pagina bianca vi perseguita. Improvvisamente, vi ricordate della vostra arma segreta: un modello linguistico di grandi dimensioni (LLM). Con pochi suggerimenti, l'LLM tesse un racconto così accattivante da sembrare magico. Questo è solo un esempio della potenza degli LLM, sofisticati sistemi di intelligenza artificiale che stanno ridisegnando il modo in cui interagiamo con la tecnologia.

Nell'intrigante mondo dell'Intelligenza Artificiale (IA), in continua evoluzione, i modelli linguistici di grandi dimensioni (LLM) hanno fatto scalpore per le loro impressionanti capacità di gestire il linguaggio umano. Ma cosa sono esattamente questi LLM e come rivoluzionano le nostre interazioni e attività quotidiane? Addentriamoci in questo regno affascinante e scopriamo alcuni dei più importanti LLM che stanno plasmando il futuro dell'IA.

Comprendere i modelli linguistici di grandi dimensioni

Gli LLM sono modelli avanzati di apprendimento automatico che prevedono e generano testi simili a quelli umani. Possono completare automaticamente le frasi, tradurre le lingue e persino creare interi articoli. Questi modelli si sono evoluti da semplici predittori di parole a sistemi complessi in grado di gestire paragrafi e documenti.

Come funzionano i grandi modelli linguistici?

I LLM stimano la probabilità di sequenze di parole, utilizzando vaste serie di dati per apprendere modelli linguistici. Si basano su architetture come i trasformatori, che si concentrano sulle parti più rilevanti dell'input per elaborare in modo efficiente le sequenze più lunghe.

L'evoluzione degli LLM: Dal BERT al GPT-4

BERT, introdotto da Google nel 2018, ha rappresentato una svolta, utilizzando il contesto bidirezionale per comprendere le sfumature del linguaggio. GPT-4, con i suoi 178 miliardi di parametri, ha portato la generazione di testo a nuovi livelli, mostrando la capacità di generare testo simile a quello umano.

Esempi di grandi modelli linguistici in azione

ChatGPT, una variante dei modelli GPT di OpenAI, è diventato un nome familiare, alimentando chatbot che offrono interazioni simili a quelle umane.

L'impatto del BERT sui compiti di elaborazione del linguaggio naturale

Il BERT ha migliorato in modo significativo le prestazioni delle attività di elaborazione del linguaggio naturale, come l'analisi del sentiment e la traduzione linguistica.

GPT-3 e la frontiera della generazione del testo

La capacità di GPT-3 di generare testi creativi e coerenti ha aperto nuove possibilità nella creazione di contenuti e non solo.

Una scheda informativa sui principali modelli linguistici odierni a confronto

Per comprendere meglio l'ampiezza e la diversità dei modelli linguistici di grandi dimensioni, diamo un'occhiata più da vicino ad alcuni dei modelli più influenti disponibili pubblicamente che attualmente dominano il panorama. Ciascun modello presenta punti di forza unici ed eccelle in diversi casi d'uso.

Questa tabella fornisce una rapida panoramica di alcuni dei modelli linguistici di grandi dimensioni più influenti nel 2024. BERT, introdotto da Google, è noto per la sua architettura basata su trasformatori e ha rappresentato un progresso significativo nelle attività di elaborazione del linguaggio naturale. Claude, sviluppato da Anthropic, si concentra sull'IA costituzionale, con l'obiettivo di rendere i risultati dell'IA utili, innocui e accurati. Cohere, un LLM aziendale, offre una formazione personalizzata e una messa a punto per casi d'uso specifici dell'azienda. Ernie, di Baidu, dispone di ben 10 trilioni di parametri ed è progettato per eccellere in mandarino, ma è in grado di farlo anche in altre lingue.

LLM locali vs LLM in cloud

Sebbene gli LLM basati su cloud offrano capacità impressionanti, una tendenza in crescita è l'uso dell'inferenza locale con modelli open-source. Strumenti come LM Studio consentono agli utenti di eseguire eseguire LLM in locale direttamente sulle loro macchine.

Questo approccio privilegia la privacy mantenendo tutti i dati e l'elaborazione offline. Tuttavia, l'inferenza locale richiede in genere un hardware più potente e può limitare l'accesso ai modelli più all'avanguardia a causa delle loro dimensioni.

I 15 modelli di lingua più diffusi

| Nome del modello | Dimensioni (parametri) | Open Source? | Ultimo aggiornamento (stimato) | Azienda | Paese di sviluppo |

| AI21 Studios Jurassic-1 Jumbo | 178B | Sì | Dicembre 2022 | Studi AI21 | Israele |

| Google Gemma | 2B o 7B | Sì | Maggio 2023 | Google AI | Stati Uniti |

| Meta LLaMA 13B | 13B | Sì | Inizio 2023 | Meta AI | Stati Uniti |

| Meta LLaMA 7B | 7B | Sì | Inizio 2023 | Meta AI | Stati Uniti |

| EleutherAI GPT-J | 6B | Sì | Maggio 2023 (attraverso le forchette come Dolly 2) | EleutherAI (gruppo di ricerca) | Stati Uniti |

| Il mucchio - EleutherAI | 900 GB di dati di testo | Sì | Sviluppo in corso | EleutherAI (gruppo di ricerca) | Stati Uniti |

| Mistral AI - Mistral Grande | Non divulgato al pubblico (Grande) | Open-source con opzioni a pagamento | Settembre 2023 | Mistral AI | Francia |

| Falcon 180B | 180B | Sì | Non specificato | Istituto per l'innovazione tecnologica | EMIRATI ARABI UNITI |

| BERT | 342 milioni di euro | No | Luglio 2018 | Google AI | Stati Uniti |

| Ernie | 10 trilioni | No | Agosto 2023 | Baidu | Cina |

| OpenAI GPT-3.5 | 175B | No | Fine 2022 | OpenAI | Stati Uniti |

| Claude | Non specificato | No | Non specificato | Antropico | Stati Uniti |

| Cohere | Non divulgato pubblicamente (massiccio) | No | Sviluppo in corso | Cohere | Canada |

| Google PaLM (obiettivo della ricerca) | Non divulgato pubblicamente (probabilmente molto grande) | No | In fase di sviluppo | Google AI | Stati Uniti |

| OpenAI GPT-4 | Non divulgato al pubblico (Successore di GPT-3.5) | No | In fase di sviluppo | OpenAI | Stati Uniti |

Confronto tra i paesi di sviluppo degli LLM

Se si confrontano i 15 principali modelli linguistici di grandi dimensioni (LLM), gli Stati Uniti contribuiscono per quasi 67% alla quota di mercato dello sviluppo di LLM da parte di 10 dei 15 paesi.

| Paese di sviluppo | Numero di modelli |

| Canada | 1 |

| Cina | 1 |

| Francia | 1 |

| Israele | 1 |

| EMIRATI ARABI UNITI | 1 |

| Stati Uniti | 10 |

| Totale generale | 15 |

Architetture LLM e metodi di formazione

| Architettura/Metodo | Descrizione |

|---|---|

| Trasformatore | Un'architettura di rete neurale che si basa su meccanismi di attenzione per migliorare l'efficienza e l'accuratezza dell'elaborazione di dati sequenziali. È la base di molti LLM moderni. |

| Preformazione | La fase iniziale dell'addestramento di un LLM consiste nell'esporlo a una vasta quantità di dati testuali non etichettati per apprendere i modelli statistici e le strutture del linguaggio. |

| Messa a punto | Affinamento di un modello pre-addestrato mediante l'addestramento su dati specifici relativi a un particolare compito, migliorando le sue prestazioni per quel compito. |

| QLoRA | Un metodo che prevede la retropropagazione dei gradienti attraverso un modello linguistico preaddestrato congelato e quantizzato a 4 bit in Low Rank Adapters (LoRA), consentendo un'efficiente messa a punto. |

L'architettura dei trasformatori ha rivoluzionato il campo dell'elaborazione del linguaggio naturale, consentendo ai modelli di gestire in modo più efficace lunghe sequenze di dati. Il pre-addestramento e la messa a punto sono fasi critiche nello sviluppo degli LLM, che consentono loro di apprendere da grandi quantità di dati e di specializzarsi in compiti specifici. QLoRA rappresenta una tecnica avanzata per la messa a punto dei LLM, riducendo la richiesta di memoria e mantenendo le prestazioni.

Casi d'uso chiave per i modelli linguistici di grandi dimensioni

Come i LLM rivoluzionano la traduzione linguistica e l'analisi del sentimento

Le LLM hanno trasformato la traduzione linguistica comprendendo e traducendo grandi quantità di dati, mentre l'analisi del sentiment è diventata più sfumata grazie alle loro capacità di deep learning.

Migliorare le interazioni uomo-macchina con i chatbot

I chatbot alimentati da LLM offrono un'assistenza clienti personalizzata ed efficiente, cambiando il volto del servizio clienti.

Trasformare la creazione di contenuti attraverso l'intelligenza artificiale generativa

I modelli di intelligenza artificiale generativa come GPT-3 hanno reso possibile la creazione di contenuti di alta qualità in tempi rapidi, aiutando scrittori e designer.

Sfide e limiti dell'implementazione dei LLM

Affrontare le preoccupazioni relative a pregiudizi e uso etico

I dati di formazione per i LLM possono introdurre pregiudizi, sollevando problemi etici che devono essere affrontati.

Comprendere i costi computazionali dell'addestramento di modelli di grandi dimensioni

La formazione di LLM richiede risorse computazionali significative, che possono essere costose e non sostenibili dal punto di vista ambientale.

I limiti nella comprensione del linguaggio e nella comprensione del contesto

Nonostante le loro capacità, i LLM fanno ancora fatica a comprendere il contesto e le sottigliezze del linguaggio umano.

Come vengono addestrati e messi a punto i modelli linguistici di grandi dimensioni

L'importanza di una grande quantità di dati nella preformazione dei LLM

I LLM richiedono grandi insiemi di dati per apprendere un'ampia gamma di modelli e sfumature linguistiche.

Tecniche di messa a punto per applicazioni specifiche

Tecniche come l'apprendimento per trasferimento e la messa a punto con modelli di trasformazione vengono utilizzate per adattare gli LLM a compiti specifici.

Emersione dei modelli di base nell'apprendimento automatico

I modelli di base sono una nuova tendenza nell'apprendimento automatico e forniscono una base per la costruzione di modelli specializzati.

Differenze tra l'addestramento preliminare e l'addestramento specifico al compito

Il pre-addestramento e l'addestramento specifico (spesso chiamato "fine-tuning") sono due fasi critiche nello sviluppo dei modelli linguistici di grandi dimensioni (LLM). Queste fasi sono fondamentali per la comprensione e la generazione di testi simili a quelli umani da parte dei LLM, e ciascuna di esse ha uno scopo distinto nel processo di apprendimento del modello.

LLM pre-formazione

Il pre-addestramento è la fase iniziale, ampia, in cui un LLM apprende da un vasto corpus di dati testuali. Questa fase è simile a quella in cui si impartisce al modello un'ampia formazione sulla lingua, sulla cultura e sulle conoscenze generali. Ecco gli aspetti principali del pre-addestramento:

- Base di conoscenza generale: Il modello sviluppa una comprensione della grammatica, dei modi di dire, dei fatti e del contesto analizzando un ampio corpus di testi. Questa ampia base di conoscenze consente al modello di generare risposte coerenti e adeguate al contesto.

- Apprendimento per trasferimento: I modelli preaddestrati possono applicare i modelli linguistici appresi a nuovi insiemi di dati, il che è particolarmente utile per i compiti con dati limitati. Questa capacità riduce in modo significativo la necessità di disporre di dati estesi specifici per l'attività.

- Costo-efficacia: Nonostante le notevoli risorse computazionali richieste per il pre-addestramento, lo stesso modello può essere riutilizzato in diverse applicazioni, il che lo rende un approccio economicamente vantaggioso.

- Flessibilità e scalabilità: L'ampia comprensione ottenuta durante il pre-addestramento consente di adattare lo stesso modello a diversi compiti. Inoltre, man mano che si rendono disponibili nuovi dati, i modelli pre-addestrati possono essere ulteriormente addestrati per migliorare le loro prestazioni.

Formazione specifica per il compito (messa a punto)

Dopo il pre-addestramento, i modelli vengono sottoposti a una fase di messa a punto, in cui vengono addestrati su insiemi di dati più piccoli e specifici per le attività. Questa fase consente di adattare l'ampia conoscenza del modello per ottenere buone prestazioni in compiti particolari. Gli aspetti chiave del fine-tuning includono:

- Specializzazione dei compiti: Il fine-tuning adatta i modelli pre-addestrati a compiti o settori specifici, migliorando le loro prestazioni su applicazioni particolari.

- Efficienza e velocità dei dati: Poiché il modello ha già appreso modelli linguistici generali durante il pre-addestramento, la messa a punto richiede meno dati e tempo per specializzare il modello per compiti specifici.

- Personalizzazione del modello: La messa a punto consente di personalizzare il modello per adattarlo alle esigenze specifiche delle diverse attività, rendendolo altamente adattabile ad applicazioni di nicchia.

- Efficienza delle risorse: Il fine-tuning è particolarmente vantaggioso per le applicazioni con risorse computazionali limitate, in quanto sfrutta il lavoro pesante svolto durante il pre-training.

In sintesi, il pre-addestramento fornisce ai LLM un'ampia comprensione del linguaggio e delle conoscenze generali, mentre la messa a punto precisa le personalizza per eccellere in compiti specifici. Il pre-addestramento pone le basi per le capacità linguistiche del modello, mentre la messa a punto ottimizza queste capacità per le applicazioni mirate, bilanciando la generalizzazione e la specializzazione del modello.

Il futuro dei modelli linguistici di grandi dimensioni

Anticipare i LLM di prossima generazione: GPT-4 e oltre

La prossima generazione di LLM, come GPT-4, si prevede che spingerà ancora più in là i confini di ciò che è possibile fare con l'intelligenza artificiale.

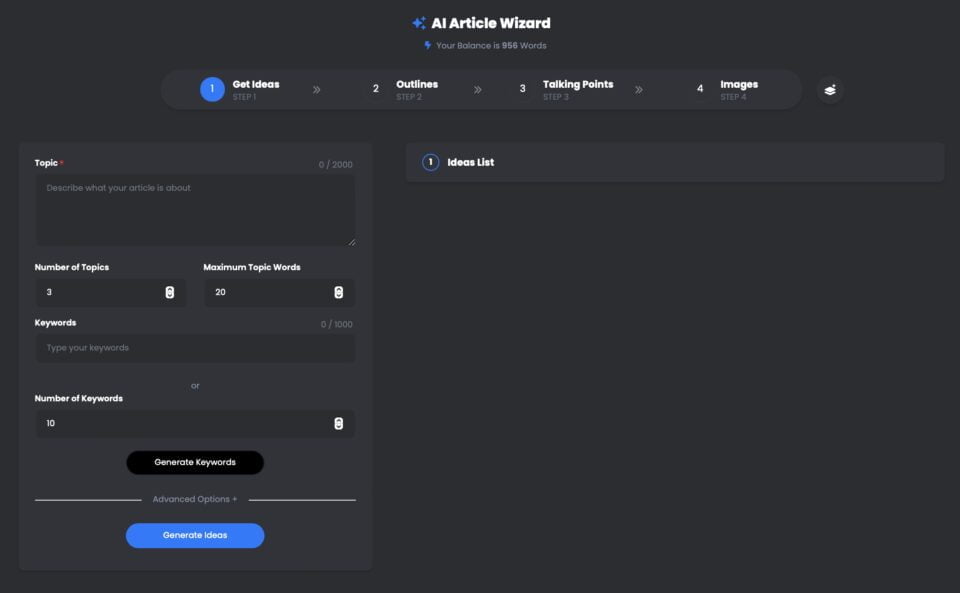

UberCreate AI Article Wizard è un potente strumento che sfrutta il modello linguistico OpenAI GPT-4 (LLM) per generare articoli di alta qualità in pochi minuti.

Con UberCreate, potete dire addio al blocco dello scrittore e dare il benvenuto a un articolo dettagliato in pochi minuti. È sufficiente fornire un argomento, una parola chiave e un numero di parole da scrivere e UberCreate si occuperà di tutto il resto. Genererà uno schema dell'articolo, punti di discussione, immagini pertinenti e un articolo finale pronto per essere pubblicato.

Creazione guidata dell'articolo Uber AI con GPT-4

Pin

Pin UberCreate utilizza una tecnologia avanzata di intelligenza artificiale per creare contenuti originali, coinvolgenti e informativi. Può scrivere su qualsiasi argomento, dal business al marketing, dalla salute allo stile di vita. Può anche adattarsi a toni, stili e formati diversi, a seconda delle preferenze e delle esigenze dell'utente.

UberCreate non è solo un generatore di contenuti, ma anche un miglioratore di contenuti. Può aiutarvi a migliorare gli articoli esistenti aggiungendo ulteriori dettagli, fatti e immagini. Può anche controllare la grammatica, l'ortografia e la leggibilità e suggerire modi per ottimizzare i contenuti per la SEO e i social media.

UberCreate è l'unico strumento di creazione di contenuti AI di cui avrete bisogno. Combina 17 strumenti di intelligenza artificiale in uno, tra cui un generatore di post per blog, un generatore di contenuti per i social media, un generatore di contenuti visivi e altro ancora. È stato progettato per facilitare ogni aspetto della creazione di contenuti, dall'ideazione alla produzione.

Che siate blogger, marketer, studenti o professionisti, UberCreate può aiutarvi a risparmiare tempo, denaro e fatica nella creazione di contenuti di alta qualità. Potete provarlo gratuitamente e vedere voi stessi i risultati.

Ampliare i confini della collaborazione tra uomo e IA

LLM Le LLM sono destinate a migliorare la collaborazione tra esseri umani e IA, rendendo le interazioni più naturali e produttive.

Questi importanti LLM sono solo la punta dell'iceberg quando si tratta di comprendere il vasto potenziale dei modelli linguistici di grandi dimensioni nel rivoluzionare le nostre interazioni con la tecnologia e nell'espandere i confini della collaborazione tra uomo e IA. Rimanete sintonizzati per la seconda parte di questa serie, in cui approfondiremo le capacità dei modelli linguistici di grandi dimensioni, le loro applicazioni in vari settori e le sfide che derivano dallo sfruttamento della loro potenza.

Prospettive della comprensione del linguaggio naturale nel prossimo decennio

Il futuro si prospetta roseo per la comprensione del linguaggio naturale, con LLM sempre più sofisticati e integrati in varie applicazioni.

In conclusioneLLM come BERT, GPT-3 e i loro successori stanno rivoluzionando i settori, dall'istruzione alla sanità. Mentre continuiamo a sfruttare la loro potenza, dobbiamo anche affrontare le sfide che presentano, garantendo un uso etico e responsabile. Il viaggio nel mondo dei modelli linguistici di grandi dimensioni è appena iniziato e le possibilità sono tanto vaste quanto i set di dati da cui imparano. Immergetevi in questo campo entusiasmante e plasmiamo insieme il futuro dell'IA.

Domande frequenti (FAQ)

Che cos'è un Large Language Model (LLM) nel contesto della PNL?

Un Large Language Model (LLM), nell'ambito dell'elaborazione del linguaggio naturale (NLP), si riferisce a un sistema avanzato di intelligenza artificiale progettato per comprendere, interpretare e generare testi simili a quelli umani. Questi modelli vengono addestrati su grandi quantità di dati, consentendo loro di eseguire un'ampia gamma di compiti linguistici. Attraverso il processo di addestramento, il modello impara a prevedere la parola successiva in una frase, aiutandolo a generare testo coerente e contestualmente rilevante su richiesta.

Quali sono i diversi tipi di LLM disponibili nel 2024?

A partire dal 2024, sono disponibili diversi tipi di Large Language Models, ciascuno con capacità uniche. I più importanti includono modelli come GPT-4, noto per le sue capacità generative di testo, e Bard, la controparte di Google che si concentra su un'ampia gamma di compiti NLP. Questi modelli si differenziano per il numero di parametri, per i dati su cui sono stati addestrati e per le loro applicazioni specifiche, che vanno dalla semplice generazione di testo a complessi compiti di comprensione del linguaggio.

Come vengono addestrati gli LLM su grandi insiemi di dati?

Gli LLM vengono addestrati utilizzando vasti insiemi di dati raccolti da Internet, tra cui libri, articoli e siti web. Questo ampio processo di addestramento comporta l'alimentazione del modello con grandi quantità di dati testuali, che lo aiutano a identificare schemi, a comprendere il contesto e ad apprendere le strutture linguistiche. Il processo di addestramento può richiedere settimane o addirittura mesi, a seconda delle dimensioni del modello e delle risorse computazionali disponibili. L'obiettivo è consentire al modello di generare testi indistinguibili da quelli scritti da esseri umani.

Può spiegare le applicazioni degli LLM nelle attività quotidiane?

Gli LLM possono essere utilizzati in diverse applicazioni per semplificare e automatizzare le attività quotidiane. Tra queste, i chatbot e gli assistenti virtuali per il servizio clienti, gli strumenti di creazione di contenuti per generare articoli o relazioni e i servizi di traduzione per convertire il testo tra le lingue. Altre applicazioni riguardano l'analisi del sentiment per valutare l'opinione pubblica sui social media, gli strumenti di riassunto per condensare lunghi documenti in versioni più brevi e persino gli assistenti di codifica per aiutare i programmatori generando snippet di codice. In sostanza, le LLM hanno rivoluzionato il modo in cui interagiamo con la tecnologia, rendendola più intuitiva e simile a quella umana.

In che modo le capacità dei modelli linguistici di grandi dimensioni differiscono da quelle dei modelli tradizionali?

I modelli linguistici di grandi dimensioni superano in modo significativo i modelli tradizionali sotto diversi aspetti. In primo luogo, grazie all'addestramento estensivo su insiemi di dati diversi, i LLM possono generare risposte più coerenti, varie e adeguate al contesto. Sono in grado di comprendere meglio le sfumature del linguaggio e di gestire in modo più efficiente i dati sequenziali. Inoltre, l'elevato numero di parametri presenti nei LLM consente di sviluppare ragionamenti più sofisticati e capacità predittive rispetto ai modelli tradizionali, che erano più limitati in termini di portata e scalabilità. In definitiva, gli LLM offrono un approccio più sfumato e versatile all'elaborazione e alla generazione del linguaggio.

Quali sono le sfide associate allo sviluppo e all'implementazione degli LLM?

Lo sviluppo e l'impiego di LLM presentano diverse sfide, tra cui le risorse computazionali necessarie per l'addestramento, che possono essere notevoli. Inoltre, vi sono preoccupazioni relative alla parzialità dei dati di addestramento, che possono portare il modello a generare contenuti pregiudizievoli o dannosi. I problemi di privacy derivano anche dalla sensibilità dei dati utilizzati per l'addestramento. Inoltre, l'interpretabilità di questi modelli rappresenta una sfida, poiché il loro processo decisionale è complesso e non sempre trasparente. Infine, l'impatto ambientale del processo di addestramento ad alta intensità energetica è una preoccupazione crescente.

Che impatto hanno i modelli linguistici come GPT-4 e Bard sul campo della PNL?

Modelli come GPT-4 e Bard hanno fatto progredire in modo significativo il campo dell'elaborazione del linguaggio naturale, dimostrando prestazioni senza precedenti in un'ampia gamma di compiti NLP. La loro capacità di generare testo, comprendere il contesto e produrre risposte simili a quelle umane ha stabilito nuovi standard per ciò che l'IA può raggiungere nella comprensione e nella produzione del linguaggio. Questi modelli non solo hanno migliorato la qualità e l'efficienza di applicazioni come i chatbot, la generazione di contenuti e la traduzione linguistica, ma hanno anche aperto nuove strade per la ricerca e lo sviluppo in NLP, spingendo i confini delle capacità dell'IA.

Esiste una guida per principianti per capire e lavorare con gli LLM?

Sì, per chi è alle prime armi, una guida per principianti ai modelli linguistici di grandi dimensioni può essere incredibilmente utile. Una guida di questo tipo copre in genere le basi di cosa sono i LLM, come vengono addestrati e le loro applicazioni. Può offrire approfondimenti sui modelli più importanti del 2023, spiegare la tecnologia sottostante e fornire esempi di attività NLP che possono essere eseguite con i LLM. I principianti possono cercare risorse online, tutorial e corsi che offrano un'introduzione a questi concetti, aiutando a costruire una comprensione fondamentale di come funzionano gli LLM e di come possono essere utilizzati in vari progetti.