Si utilizzano modelli linguistici di grandi dimensioni (LLM) come ChatGPT, CoPilot, Gemini, ecc.

Un mio amico ha recentemente espresso preoccupazioni in merito alla privacy delle persone che utilizzano assistenti di chat AI come ChatGPT sul posto di lavoro e che condividono con loro informazioni commerciali. Esiste la possibilità di utilizzare strumenti simili anche offline senza dover condividere informazioni online?

La risposta è SÌe la soluzione consiste nell'utilizzare gli LLM a livello locale.

Questo articolo si rivolge ai proprietari di aziende, ai dipendenti, ai creatori di contenuti e a tutti coloro che sono interessati a scrivere sull'IA tenendo conto della privacy.

Problemi con gli strumenti di scrittura AI online

Strumenti di scrittura basati sull'intelligenza artificiale sono sempre più popolari, ma sollevano valide preoccupazioni sulla privacy. I servizi di scrittura AI tradizionali spesso coinvolgono i dati degli utenti, il che può essere fonte di preoccupazione. Tuttavia, esiste una soluzione che consente di eseguire modelli linguistici di grandi dimensioni (LLM) localmente sulla propria macchina, garantendo la privacy in ogni fase.

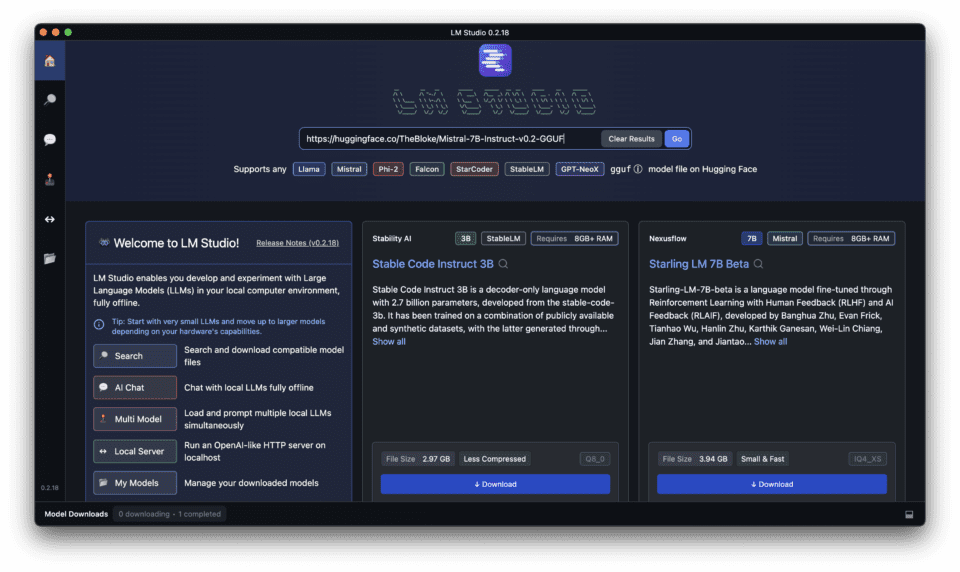

Introduzione di LM Studio per l'esecuzione di LLM a livello locale

I vantaggi dei LLM locali rispetto alle soluzioni basate sul cloud

L'esecuzione di modelli linguistici di grandi dimensioni (LLM) in locale sul computer offre diversi vantaggi rispetto alle soluzioni basate su cloud, tra cui i vantaggi locali e open-source.

- Privacy e controllo: La conservazione dei dati sul proprio computer garantisce il pieno controllo delle informazioni.

- Tempi di risposta più rapidi: L'esecuzione di LLM in locale elimina la necessità di connettersi a Internet, con conseguenti tempi di risposta più rapidi.

- Conveniente: I LLM locali possono essere più convenienti nel lungo periodo, in quanto non è necessario pagare per i servizi cloud.

Garantire privacy e controllo con LM Studio

LM Studio è stato progettato per fornire privacy e controllo durante l'esecuzione di LLM a livello locale. Offre un funzionamento offline, nessuna dipendenza dal cloud e modelli open-source, assicurando che i dati rimangano sotto il vostro controllo, sottolineando i suoi vantaggi locali e open-source.

Come LM Studio si distingue dalle altre piattaforme LLM locali

LM Studio si differenzia dalle altre piattaforme LLM locali per l'interfaccia facile da usare, la compatibilità con vari dispositivi e una forte comunità di sviluppatori e utenti.

Scaricare e installare LM Studio: Passo dopo passo

Seguite la seguente guida completa per scaricare, installare ed eseguire LLM locali con LM Studio sul vostro PC o laptop.

Impostazione di un server di inferenza locale efficiente con LM Studio

Imparate a configurare un efficiente server di inferenza locale con LM Studio per ottenere tempi di risposta più rapidi e prestazioni migliori.

LM Studio offre un modo semplice per eseguire modelli linguistici di grandi dimensioni (LLM) localmente sul computer. Ecco cosa occorre sapere per una configurazione efficiente:

1. Requisiti di sistema:

Prima di scaricare e installare LM Studio, assicurarsi che il computer con LM Studio soddisfi i seguenti requisiti.

LM Studio funziona al meglio con risorse hardware adeguate, in particolare con una quantità elevata di VRAM. Ecco una linea guida generale:

- Sistema operativo: Compatibile con Windows, Mac e Linux.

- GPU: Supporto per diverse GPU, tra cui RTX, M1 e AMD.

- Processore: Processore multi-core (i5 o equivalente) per prestazioni più fluide.

- RAM: Si consiglia un minimo di 8 GB di RAM, con oltre 16 GB ideali per i modelli più grandi.

- Stoccaggio: Spazio libero sufficiente per ospitare l'LLM scelto (i modelli possono variare da pochi GB a decine di GB).

- Connessione a Internet: Per scaricare il software è necessaria una connessione Internet stabile.

2. Installazione:

Per scaricare LM Studio, procedere come segue:

- Visita il sito Studio LM sito web.

- Fare clic sul pulsante "Download".

- Scegliete la versione appropriata per il vostro sistema operativo.

Scegliere il modello giusto per le proprie esigenze

3. Scegliere un LLM:

LM Studio offre una varietà di LLM tra cui scegliere, ognuna con capacità e dimensioni diverse. Considerate le vostre specifiche esigenze di scrittura e scegliete il modello più adatto.

- LM Studio offre una serie di LLM open-source. Considerate questi fattori:

- Dimensioni del modello: I modelli più grandi offrono maggiori capacità, ma richiedono più risorse.

- Focus: Alcuni modelli sono specializzati in compiti specifici, come la scrittura o la generazione di codice.

- Quantizzazione: Cercate le versioni "quantizzate" dei modelli. Queste sono più piccole e funzionano più velocemente con una perdita minima di precisione.

La tabella seguente mette a confronto alcuni dei diversi modelli di LLM disponibili in LM Studio, evidenziandone le capacità e i casi d'uso ideali.

Se avete bisogno di un elenco dettagliato ed esaustivo di modelli, date un'occhiata a questo articolo in cui ho messo a confronto i modelli di Top 15 Modelli linguistici di grandi dimensioni compresi quelli Open Source con le loro dimensioni, il paese di sviluppo, ecc. Consultatelo per saperne di più.

| Nome del modello | Dimensione | Capacità | Casi d'uso ideali |

|---|---|---|---|

| Maestrale | Piccolo | Generazione di testo di base, compiti NLP semplici | Bozze rapide, generazione di idee |

| Ollama | Medio | Generazione di testo avanzata, compiti NLP moderati | Creazione di contenuti, analisi di moderata complessità |

| ExLamaV2 | Grande | Generazione di testi di alta qualità, compiti NLP complessi | Articoli dettagliati, analisi di dati complessi |

| Gemelli | Extra Large | Generazione di testi all'avanguardia, compiti NLP altamente complessi | Documenti di ricerca, creazione di contenuti avanzati |

4. Scaricare l'LLM:

- Una volta scaricato LM Studio, all'interno di LM Studio, cercare e scaricare l'LLM desiderato. Il tempo di download può variare a seconda delle dimensioni del modello e della velocità di Internet.

Esecuzione della prima inferenza locale

5. Avvio del server di inferenza locale:

- Una volta scaricato l'LLM, passare alla scheda Server di LM Studio.

- Fare clic su "Avvia server" per avviare il server di inferenza locale. Questo processo potrebbe richiedere alcuni istanti, a seconda delle dimensioni del modello.

6. Ottimizzare l'efficienza:

- Abbinare il modello alle esigenze: Scegliete un LLM che sia in linea con i vostri compiti specifici. Non scegliete un modello gigante se avete bisogno solo di un'assistenza di base per la scrittura.

- Elaborazione in batch: Per alcuni modelli si può considerare l'invio di più richieste contemporaneamente, che può essere più efficiente rispetto alle richieste individuali. (Consultare la documentazione di LM Studio per le funzionalità specifiche del modello).

- Monitoraggio delle risorse: Tenere sotto controllo l'utilizzo delle risorse del sistema durante l'esecuzione del server. Regolate le impostazioni di LM Studio o scegliete un modello più piccolo se la vostra macchina ne risente.

Risorse aggiuntive:

- Documentazione di LM Studio fornisce informazioni dettagliate sui modelli disponibili, sulle opzioni di configurazione e sui suggerimenti per la risoluzione dei problemi.

Come utilizzare LM Studio per le attività di elaborazione del linguaggio naturale

Liberare la potenza di LM Studio per le attività di elaborazione del linguaggio naturale

Scoprite come LM Studio può essere utilizzato per diverse attività di elaborazione del linguaggio naturale, dalla creazione di contenuti all'analisi dei dati.

LM Studio è in grado di affrontare diversi compiti di elaborazione del linguaggio naturale (NLP), offrendo assistenza AI senza compromettere la privacy. Ecco come sfruttare le sue capacità:

1. Generazione del testo:

- Creare testi di marketing, descrizioni di prodotti o post per i social media convincenti, fornendo spunti o schemi che LM Studio può elaborare.

- Brainstorming di idee creative per i contenuti, fornendo linee di partenza e lasciando che il modello generi variazioni.

- Generate diversi stili di scrittura modificando le richieste e sperimentando diversi LLM.

2. Riassunto del testo:

- Fornite a LM Studio articoli lunghi o documenti di ricerca e il programma è in grado di generare riassunti concisi, facendovi risparmiare tempo prezioso per la lettura.

- Riassumere le recensioni dei clienti o i rapporti di feedback per cogliere rapidamente i punti chiave e identificare le tendenze.

3. Traduzione automatica:

- Traducete un testo da una lingua all'altra con le LLM di LM Studio dedicate alla traduzione. Anche se alcuni non sono all'altezza dei servizi di traduzione dedicati, possono essere uno strumento utile per le esigenze di base.

4. Classificazione del testo:

- Addestrare un LLM per classificare i dati in base a criteri specifici. Ad esempio, classificare le e-mail di assistenza clienti in base al tipo di problema o al sentiment.

- Questa funzionalità può essere utile per organizzare grandi insiemi di dati o per automatizzare le attività di filtraggio di base.

5. Codificazione testuale:

- Determinare se una specifica affermazione segue logicamente un'altra utilizzando le capacità di ragionamento di LM Studio.

- Questo può essere utile per compiti come l'analisi di documenti legali o l'identificazione di incongruenze nel testo.

6. Risposta alle domande:

- Addestrare un LLM su una base di conoscenza specifica e utilizzarlo per rispondere alle domande in un formato di linguaggio naturale.

- Questo può essere utile per creare FAQ interne o chatbot per il servizio clienti, sfruttando la potenza di LLM come ChatGPT.

Utilizzo di LM Studio per attività di PNL:

- Scegliere il giusto LLM: Selezionare un LLM specificamente addestrato per l'attività NLP (Natural Language Processing) che si desidera eseguire. La documentazione indica spesso i punti di forza del modello.

- Creare suggerimenti efficaci: Fornire suggerimenti chiari e concisi che guidino l'LLM verso il risultato desiderato, in modo simile all'interazione con ChatGPT. Migliori sono i suggerimenti, più accurati saranno i risultati.

- Sperimentare e iterare: Non abbiate paura di sperimentare con diversi prompt e impostazioni LLM. Si tratta di un processo iterativo per ottenere risultati ottimali, che spesso richiede modifiche all'interfaccia utente per mettere a punto il comportamento dell'applicazione.

- Perfezionamento e post-elaborazione: Il risultato dell'LLM potrebbe richiedere una certa pulizia o una supervisione umana per compiti specifici. È necessario prevedere una revisione e un editing per garantire l'accuratezza, soprattutto per i compiti critici.

Ricorda:

- LM Studio offre notevoli capacità NLP, ma è ancora in fase di sviluppo. I risultati possono variare a seconda della complessità del compito e del modello scelto.

Caratteristiche avanzate di LM Studio: Miglioramento dell'esperienza LLM locale

Esplorare le impostazioni e le opzioni avanzate di LM Studio

LM Studio offre impostazioni e opzioni avanzate per migliorare la vostra esperienza di LLM locale, tra cui:

- Tecniche di quantizzazione e ottimizzazione: Queste tecniche possono migliorare i tempi di risposta e ridurre l'utilizzo delle risorse.

- Integrazione con altre applicazioni e API: LM Studio può essere integrato con diverse applicazioni e API per un utilizzo senza soluzione di continuità.

LM Studio: Compatibilità, supporto e comunità

Garanzia di compatibilità: Supporto di LM Studio per Windows, Mac, Linux e diverse GPU

LM Studio è compatibile con diversi sistemi operativi e GPU, assicurando che possa essere utilizzato da un'ampia gamma di utenti.

Ottenere aiuto: Sfruttare la comunità e i canali di supporto di LM Studio

Se avete bisogno di assistenza con LM Studio, consultate la comunità o i canali di supporto per trovare risorse utili e risposte alle vostre domande.

Contribuire al progetto LM Studio: Sviluppo open-source

Se siete interessati a contribuire al progetto Progetto LM Studio, esplorare le opportunità di sviluppo open-source e unirsi alla comunità di sviluppatori.

Domande frequenti (FAQ)

Quali sono i requisiti di LM studio per l'esecuzione in locale su Mac e Windows?

Per utilizzare un LLM in locale attraverso l'applicazione gratuita e potente LM Studio, il computer Mac o Windows deve soddisfare requisiti specifici. Per entrambi i sistemi operativi, LM Studio richiede almeno 8 GB di RAM, anche se per ottenere prestazioni ottimali si consigliano 16 GB. Su Windows è necessario Windows 10 o più recente, mentre su macOS è necessario utilizzare macOS 10.14 (Mojave) o più recente. Altri requisiti includono circa 400 MB di spazio di archiviazione per ospitare l'applicazione e i modelli locali selezionati e, per i casi d'uso avanzati, si suggerisce una GPU compatibile per l'accelerazione GPU.

Come si scarica e si installa LM Studio sul computer?

Il download e l'installazione di LM Studio sono semplici. Iniziare con la fase 1 visitando il sito ufficiale di LM Studio o un repository affidabile come GitHub o HuggingFace per scaricare l'applicazione per il proprio sistema operativo (macOS o Windows). Per il passaggio 2, individuare il file scaricato nella cartella Download e fare doppio clic per avviare il processo di installazione. Seguire le istruzioni sullo schermo per il passaggio 3, che prevede l'accettazione dei termini di servizio e la selezione di una posizione di installazione. Una volta completata l'installazione, è possibile avviare LM Studio dall'elenco delle applicazioni o dal menu di avvio.

Come si sceglie un modello da scaricare in LM Studio per l'uso locale?

Per scegliere un modello da scaricare per utilizzarlo in LM Studio, iniziare lanciando l'applicazione e collegandosi a Internet. Passate alla sezione "Modelli", dove vedrete un elenco di LLM disponibili, come Mistral, Ollama e Mixtral. Considerate le vostre esigenze specifiche, ad esempio se state cercando un modello ottimizzato per la comprensione del linguaggio (Mistral), la generazione di contenuti creativi (Ollama) o attività personalizzate (Mixtral). Passate il mouse sul modello scelto per visualizzare ulteriori dettagli e fate clic su "Scarica" per iniziare. Si noti che il download dei modelli può richiedere un po' di tempo, a seconda delle dimensioni e della velocità di Internet.

Come posso avviare una sessione di chat utilizzando il mio LLM scaricato in LM Studio?

Dopo aver scaricato e configurato localmente un LLM in LM Studio, avviare una sessione di chat è semplice. Aprire LM Studio e, nel menu principale, selezionare la funzione "Chat". Da qui, scegliere il modello scaricato che si desidera utilizzare per la sessione. Verrà visualizzata un'interfaccia di chat in cui è possibile digitare le proprie domande o richieste. Premendo "Invio" o facendo clic su "Invia" per inviare il testo, LLM genererà una risposta basata sull'input e la visualizzerà nella finestra di chat. Questa funzione può essere utilizzata per diverse interazioni, dall'assistenza alla scrittura al debug del codice.

Posso utilizzare LM Studio per generare trascrizioni a livello locale?

Sì, LM Studio supporta la generazione di trascrizioni in locale utilizzando LLM ottimizzati per compiti di riconoscimento vocale come Mistral. Per generare una trascrizione, assicurarsi di aver scaricato un modello adatto alla trascrizione. Aprire l'applicazione e selezionare l'opzione "Trascrizione", quindi scegliere il modello. È possibile caricare file audio direttamente in LM Studio e l'LLM selezionato elaborerà l'audio e produrrà una trascrizione di testo. Questo può essere particolarmente utile per gli utenti che necessitano di un accesso rapido e offline ai servizi di trascrizione per riunioni, interviste o creazione di contenuti.

Che cos'è la quantizzazione in LM Studio e come migliora le prestazioni?

La quantizzazione è un processo utilizzato in LM Studio per ottimizzare le prestazioni del modello riducendo la precisione dei numeri utilizzati nel modello. Questa tecnica consente all'applicazione di eseguire modelli più grandi su dispositivi con risorse limitate, riducendo le dimensioni complessive del modello e accelerando i calcoli, con particolare vantaggio per i dispositivi senza accelerazione GPU dedicata. Questa tecnica permette di bilanciare prestazioni e qualità, rendendo possibile l'uso di modelli locali avanzati su una gamma più ampia di computer. Gli utenti possono attivare la quantizzazione dal menu delle impostazioni di LM Studio, selezionando il livello di quantizzazione che meglio si adatta al loro equilibrio tra prestazioni e precisione.

È possibile integrare gli LLM locali di LM Studio con applicazioni esterne tramite API?

Sì, LM Studio offre l'integrazione API per i modelli locali impostati, consentendo agli sviluppatori di estendere le funzionalità delle loro applicazioni o servizi esterni sfruttando la potenza dei modelli linguistici di grandi dimensioni (LLM) a livello locale. Questa funzione supporta una serie di casi d'uso, dal miglioramento delle applicazioni di chat con l'elaborazione del linguaggio naturale all'integrazione di analisi testuali avanzate nei sistemi di gestione dei contenuti. Per accedere all'API, accedere alle impostazioni di LM Studio e abilitare l'uso dell'API. Verrà fornita una chiave API e le informazioni sull'endpoint per integrare l'LLM nella propria applicazione.

Come posso garantire le migliori prestazioni quando utilizzo l'accelerazione GPU in LM Studio?

Per garantire le migliori prestazioni con l'accelerazione GPU in LM Studio, verificare innanzitutto che l'hardware del computer includa una GPU compatibile con risorse adeguate. Le GPU Nvidia sono comunemente supportate per queste attività. Quindi, aggiornare i driver della GPU alla versione più recente per garantire la compatibilità e le prestazioni ottimali. All'interno di LM Studio, navigare nelle impostazioni e assicurarsi che l'accelerazione GPU sia abilitata. Per compiti o modelli specifici, si possono trovare anche impostazioni aggiuntive per ottimizzare le prestazioni, come la regolazione dell'allocazione della memoria per il modello o la selezione di opzioni di quantizzazione orientate alle prestazioni. Anche il monitoraggio delle prestazioni e della temperatura della GPU può aiutare a regolare con precisione le impostazioni per un funzionamento prolungato.