Você está usando modelos de linguagem grandes (LLMs), como ChatGPT, CoPilot, Gemini, etc.?

Recentemente, meu amigo expressou preocupação com a privacidade das pessoas que usam assistentes de bate-papo com IA, como o ChatGPT, no local de trabalho e compartilham informações comerciais com eles. Existe uma opção para usar ferramentas semelhantes off-line sem precisar compartilhar informações on-line?

A resposta é SIMe a solução é usar LLMs localmente.

Este artigo é destinado a proprietários de empresas, funcionários, criadores de conteúdo e qualquer pessoa interessada em escrever com IA tendo em mente a privacidade.

Problema com as ferramentas de redação de IA on-line

Ferramentas de escrita com IA são cada vez mais populares, mas levantam preocupações válidas sobre privacidade. Os serviços tradicionais de redação de IA geralmente envolvem dados do usuário, o que pode ser motivo de preocupação. No entanto, há uma solução que permite executar modelos de linguagem grandes (LLMs) localmente em sua própria máquina, garantindo a privacidade em cada etapa.

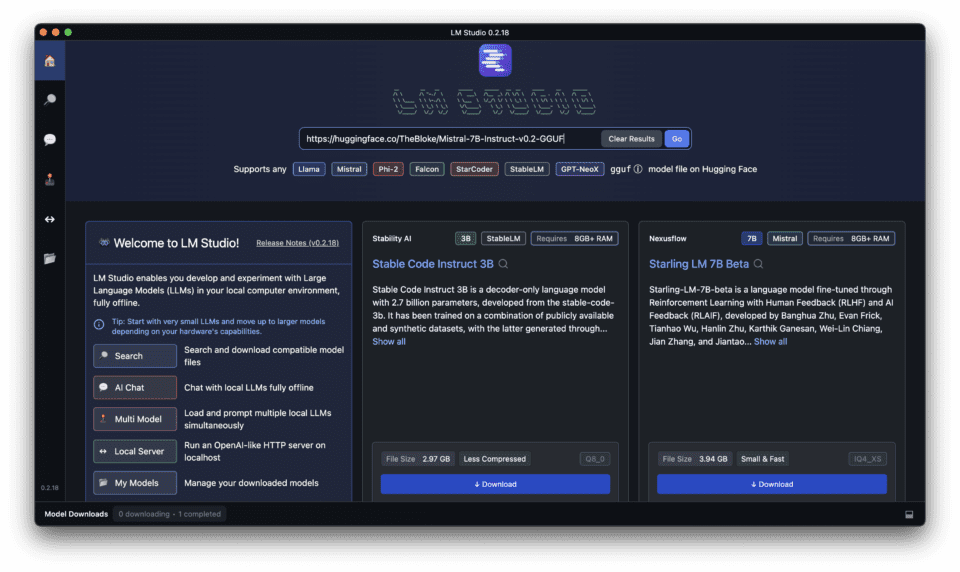

Apresentando o LM Studio para executar LLMs localmente

As vantagens dos LLMs locais em relação às soluções baseadas em nuvem

A execução de modelos de linguagem grandes (LLMs) localmente em seu computador oferece várias vantagens em relação às soluções baseadas em nuvem, incluindo benefícios locais e de código aberto.

- Privacidade e controle: Manter seus dados em sua própria máquina garante que você tenha controle total sobre suas informações.

- Tempos de resposta mais rápidos: A execução de LLMs localmente elimina a necessidade de conectividade com a Internet, resultando em tempos de resposta mais rápidos.

- Custo-benefício: Os LLMs locais podem ser mais econômicos a longo prazo, pois você não precisa pagar por serviços de nuvem.

Garantia de privacidade e controle com o LM Studio

O LM Studio foi projetado para oferecer privacidade e controle ao executar LLMs localmente. Ele oferece operação off-line, sem dependência de nuvem e modelos de código aberto, garantindo que seus dados permaneçam sob seu controle, enfatizando suas vantagens locais e de código aberto.

Como o LM Studio se destaca de outras plataformas locais de LLM

O LM Studio se diferencia de outras plataformas locais de LLM por oferecer uma interface amigável, compatibilidade com vários dispositivos e uma forte comunidade de desenvolvedores e usuários.

Faça o download e instale o LM Studio: Passo a passo

Siga o tutorial detalhado abaixo para baixar, instalar e executar LLMs locais com o LM Studio em seu PC ou laptop

Configuração de um servidor de inferência local eficiente com o LM Studio

Saiba como configurar um servidor de inferência local eficiente com o LM Studio para obter tempos de resposta mais rápidos e melhor desempenho.

O LM Studio oferece uma maneira fácil de executar modelos de linguagem grandes (LLMs) localmente em seu computador. Veja a seguir o que você precisa saber para uma configuração eficiente:

1. Requisitos do sistema:

Antes de fazer o download e instalar o LM Studio, certifique-se de que seu computador com o LM Studio atenda aos seguintes requisitos.

O LM Studio funciona melhor com recursos de hardware decentes, especialmente com uma grande quantidade de VRAM. Aqui está uma diretriz geral:

- Sistema operacional: Compatível com Windows, Mac e Linux.

- GPU: Suporte para várias GPUs, incluindo RTX, M1 e AMD.

- Processador: Processador de vários núcleos (i5 ou equivalente) para um desempenho mais suave.

- RAM: Recomenda-se um mínimo de 8 GB de RAM, com mais de 16 GB ideal para modelos maiores.

- Armazenamento: Espaço livre suficiente para acomodar o LLM escolhido (os modelos podem variar de alguns GB a dezenas de GB).

- Conexão com a Internet: É necessária uma conexão estável com a Internet para fazer o download do software.

2. Instalação:

Para fazer o download do LM Studio, siga estas etapas:

- Visite o Estúdio LM site.

- Clique no botão "Download".

- Escolha a versão apropriada para seu sistema operacional.

Escolhendo o modelo certo para suas necessidades

3. Escolha de um LLM:

O LM Studio oferece uma variedade de LLMs para você escolher, cada um com diferentes recursos e tamanhos. Considere suas necessidades específicas de escrita e escolha o modelo mais adequado.

- O LM Studio oferece uma variedade de LLMs de código aberto. Considere estes fatores:

- Tamanho do modelo: Modelos maiores oferecem mais recursos, mas exigem mais recursos.

- Foco: Alguns modelos são especializados em tarefas específicas, como escrita ou geração de código.

- Quantização: Procure versões "quantizadas" dos modelos. Elas são menores e são executadas mais rapidamente com perda mínima de precisão.

A tabela abaixo compara alguns dos diferentes modelos de LLM disponíveis no LM Studio, destacando seus recursos e casos de uso ideais

Se você precisar de uma lista detalhada e abrangente de modelos, consulte este artigo, no qual comparei os Top 15 Grandes modelos de linguagem incluindo os de código aberto com seu tamanho, país de desenvolvimento, etc. Dê uma olhada para saber mais.

| Nome do modelo | Tamanho | Recursos | Casos de uso ideais |

|---|---|---|---|

| Mistral | Pequeno | Geração de texto básico, tarefas simples de PNL | Rascunhos rápidos, geração de ideias |

| Ollama | Médio | Geração avançada de texto, tarefas moderadas de PNL | Criação de conteúdo, análise de complexidade moderada |

| ExLlamaV2 | Grande | Geração de texto de alta qualidade, tarefas complexas de PNL | Artigos detalhados, análise de dados complexos |

| Gêmeos | Extragrande | Geração de texto de última geração, tarefas de PNL altamente complexas | Artigos de pesquisa, criação de conteúdo avançado |

4. Download do LLM:

- Depois de fazer o download do LM Studio, no LM Studio, procure e faça o download do LLM desejado. O tempo de download pode variar dependendo do tamanho do modelo e da velocidade de sua internet.

Executando sua primeira inferência local

5. Iniciando o servidor de inferência local:

- Depois que o LLM for baixado, navegue até a guia Server (Servidor) no LM Studio.

- Clique em "Start Server" (Iniciar servidor) para iniciar o servidor de inferência local. Esse processo pode levar alguns minutos, dependendo do tamanho do modelo.

6. Otimização da eficiência:

- Adequar o modelo às necessidades: Escolha um LLM que se alinhe com suas tarefas específicas. Não opte por um modelo gigantesco se você só precisa de assistência básica para escrever.

- Processamento em lote: Considere enviar vários prompts de uma vez para alguns modelos, o que pode ser mais eficiente do que solicitações individuais. (Consulte a documentação do LM Studio para conhecer os recursos específicos do modelo).

- Monitoramento de recursos: Fique atento ao uso de recursos do sistema durante a execução do servidor. Ajuste as configurações do LM Studio ou escolha um modelo menor se isso sobrecarregar sua máquina.

Recursos adicionais:

- Documentação do LM Studio fornece informações detalhadas sobre os modelos disponíveis, opções de configuração e dicas de solução de problemas.

Como usar o LM Studio para tarefas de processamento de linguagem natural

Liberando o poder do LM Studio para tarefas de processamento de linguagem natural

Descubra como o LM Studio pode ser usado para várias tarefas de processamento de linguagem natural, desde a criação de conteúdo até a análise de dados.

O LM Studio é excelente para lidar com várias tarefas de processamento de linguagem natural (NLP), capacitando-o com assistência de IA sem comprometer a privacidade. Veja a seguir como aproveitar seus recursos:

1. Geração de texto:

- Elabore textos de marketing, descrições de produtos ou publicações em mídias sociais convincentes, fornecendo sugestões ou esboços para o LM Studio elaborar.

- Faça um brainstorming de ideias de conteúdo criativo, alimentando-o com linhas iniciais e permitindo que o modelo gere variações.

- Crie diferentes estilos de redação ajustando seus prompts e experimentando diferentes LLMs.

2. Sumarização de textos:

- Forneça artigos longos ou trabalhos de pesquisa ao LM Studio e ele poderá gerar resumos concisos, economizando seu valioso tempo de leitura.

- Resuma as avaliações dos clientes ou os relatórios de feedback para compreender rapidamente os pontos principais e identificar tendências.

3. Tradução automática:

- Traduza textos de um idioma para outro com os LLMs voltados para tradução do LM Studio. Embora alguns possam não estar no mesmo nível dos serviços de tradução dedicados, eles podem ser uma ferramenta útil para as necessidades básicas.

4. Classificação de textos:

- Treine um LLM para categorizar seus dados com base em critérios específicos. Por exemplo, classificar e-mails de suporte ao cliente por tipo de problema ou sentimento.

- Essa funcionalidade pode ser útil para organizar grandes conjuntos de dados ou automatizar tarefas básicas de filtragem.

5. Enfeite textual:

- Determinar se uma declaração específica decorre logicamente de outra usando os recursos de raciocínio do LM Studio.

- Isso pode ser útil para tarefas como análise de documentos legais ou identificação de inconsistências no texto.

6. Resposta a perguntas:

- Treine um LLM em uma base de conhecimento específica e use-o para responder às suas perguntas em um formato de linguagem natural.

- Isso pode ser útil para criar FAQs internas ou chatbots para atendimento ao cliente, aproveitando o poder de LLMs como o ChatGPT.

Utilização do LM Studio para tarefas de PNL:

- Escolha o LLM certo: Selecione um LLM treinado especificamente para a tarefa de NLP (Processamento de Linguagem Natural) que você deseja executar. A documentação geralmente indica os pontos fortes do modelo.

- Crie prompts eficazes: Forneça avisos claros e concisos que orientem o LLM em direção ao resultado desejado, de forma semelhante à interação com o ChatGPT. Quanto melhores forem suas instruções, mais precisos serão os resultados.

- Faça experimentos e itere: Não tenha medo de experimentar diferentes prompts e configurações do LLM. Trata-se de um processo iterativo para obter os melhores resultados, muitas vezes exigindo ajustes na interface do usuário para aperfeiçoar o comportamento do aplicativo.

- Refinar e pós-processar: O resultado do LLM pode exigir algum polimento ou supervisão humana para tarefas específicas. Leve em conta a revisão e a edição para garantir a precisão, especialmente em tarefas críticas.

Lembre-se:

- Embora o LM Studio ofereça recursos impressionantes de PNL, ele ainda está em desenvolvimento. Os resultados podem variar de acordo com a complexidade da tarefa e o modelo escolhido.

Recursos avançados do LM Studio: Aprimorando sua experiência com o LLM local

Explorando configurações e opções avançadas no LM Studio

O LM Studio oferece configurações e opções avançadas para aprimorar sua experiência com o LLM local, incluindo:

- Técnicas de quantificação e otimização: Essas técnicas podem melhorar os tempos de resposta e reduzir o uso de recursos.

- Integração com outros aplicativos e APIs: O LM Studio pode ser integrado a vários aplicativos e APIs para uso contínuo.

LM Studio: Compatibilidade, suporte e comunidade

Garantia de compatibilidade: Suporte do LM Studio para Windows, Mac, Linux e várias GPUs

O LM Studio é compatível com vários sistemas operacionais e GPUs, garantindo que possa ser usado por uma ampla gama de usuários.

Obtendo ajuda: Aproveitando a comunidade e os canais de suporte do LM Studio

Se precisar de ajuda com o LM Studio, consulte a comunidade ou os canais de suporte para obter recursos úteis e respostas às suas perguntas.

Contribuindo com o projeto LM Studio: Desenvolvimento de código aberto

Se você estiver interessado em contribuir com o Projeto do LM StudioExplore as oportunidades de desenvolvimento de código aberto e participe da comunidade de desenvolvedores.

Perguntas frequentes (FAQ)

Quais são os requisitos do LM studio para execução local no Mac e no Windows?

Para usar um LLM localmente por meio do aplicativo gratuito e avançado LM Studio, seu computador Mac ou Windows deve atender a requisitos específicos. Para ambos os sistemas operacionais, o LM Studio requer pelo menos 8 GB de RAM, embora 16 GB sejam recomendados para um desempenho ideal. No Windows, ele exige o Windows 10 ou mais recente, e no macOS, você deve estar executando o macOS 10.14 (Mojave) ou mais recente. Os requisitos adicionais incluem cerca de 400 MB de espaço de armazenamento para acomodar o aplicativo e os modelos locais selecionados e, para casos de uso avançado, sugere-se uma GPU compatível para aceleração de GPU.

Como faço o download e instalo o LM Studio em meu computador?

O download e a instalação do LM Studio são simples. Comece com a etapa 1 visitando o site oficial do LM Studio ou um repositório confiável, como o GitHub ou o HuggingFace, para baixar o aplicativo para seu sistema operacional (macOS ou Windows). Na etapa 2, localize o arquivo baixado na pasta Downloads e clique duas vezes para iniciar o processo de instalação. Siga as instruções na tela para a etapa 3, que envolve concordar com os termos de serviço e selecionar um local de instalação. Após a conclusão da instalação, você poderá iniciar o LM Studio na lista de aplicativos ou no menu Iniciar.

Como faço para escolher um modelo para download no LM Studio para uso local?

Para escolher um modelo a ser baixado para uso no LM Studio, comece iniciando o aplicativo e conectando-se à Internet. Navegue até a seção "Models" (Modelos), onde você verá uma lista de LLMs disponíveis, como Mistral, Ollama e Mixtral. Considere suas necessidades específicas, por exemplo, se você está procurando um modelo otimizado para compreensão de idiomas (Mistral), geração de conteúdo criativo (Ollama) ou tarefas personalizadas (Mixtral). Passe o mouse sobre o modelo escolhido para ver mais detalhes e clique em "Download" para começar. Observe que os modelos podem demorar um pouco para serem baixados, dependendo do tamanho e da velocidade da Internet.

Como faço para iniciar uma sessão de bate-papo usando meu LLM baixado no LM Studio?

Depois de fazer o download e configurar com êxito um LLM localmente no LM Studio, é simples iniciar uma sessão de bate-papo. Abra o LM Studio e, no menu principal, selecione o recurso "Chat". A partir daí, escolha o modelo baixado que deseja usar para a sessão. Você será levado a uma interface de bate-papo onde poderá digitar suas perguntas ou solicitações. Pressione "Enter" ou clique em "Send" (Enviar) para enviar o texto, e o LLM gerará uma resposta com base na entrada, exibindo-a na janela de bate-papo. Esse recurso pode ser usado para várias interações, desde a obtenção de ajuda para escrever até a depuração de código.

Posso usar o LM Studio para gerar transcrições localmente?

Sim, o LM Studio suporta a geração de transcrições localmente usando LLMs otimizados para tarefas de reconhecimento de fala como o Mistral. Para gerar uma transcrição, certifique-se de ter baixado um modelo adequado para transcrição. Abra o aplicativo e selecione a opção "Transcription" (Transcrição) e, em seguida, escolha seu modelo. Você pode carregar arquivos de áudio diretamente no LM Studio, e o LLM selecionado processará o áudio e produzirá uma transcrição de texto. Isso pode ser particularmente útil para usuários que precisam de acesso rápido e off-line a serviços de transcrição para reuniões, entrevistas ou criação de conteúdo.

O que é quantização no LM Studio e como ela melhora o desempenho?

A quantização é um processo usado no LM Studio para otimizar o desempenho do modelo, reduzindo a precisão dos números usados no modelo. Essa técnica permite que o aplicativo execute modelos maiores em dispositivos com recursos limitados, diminuindo o tamanho geral do modelo e acelerando a computação, o que é especialmente benéfico para dispositivos sem aceleração de GPU dedicada. Ela equilibra desempenho e qualidade, possibilitando o uso de modelos locais avançados em uma variedade maior de computadores. Os usuários podem ativar a quantização no menu de configurações do LM Studio, selecionando o nível de quantização mais adequado ao equilíbrio entre desempenho e precisão.

É possível integrar LLMs locais do LM Studio com aplicativos externos por meio da API?

Sim, o LM Studio oferece integração de API para os modelos locais que você configurou, permitindo que os desenvolvedores ampliem os recursos de seus aplicativos ou serviços externos aproveitando o poder dos modelos de linguagem grandes (LLMs) localmente. Esse recurso oferece suporte a uma variedade de casos de uso, desde o aprimoramento de aplicativos de bate-papo com processamento de linguagem natural até a incorporação de análise avançada de texto em sistemas de gerenciamento de conteúdo. Para acessar a API, navegue até as configurações do LM Studio e ative o uso da API. Você receberá uma chave de API e informações de ponto final para integrar o LLM ao seu aplicativo.

Como posso garantir o melhor desempenho ao usar a aceleração de GPU no LM Studio?

Para garantir o melhor desempenho com a aceleração de GPU no LM Studio, primeiro verifique se o hardware de seu computador inclui uma GPU compatível com recursos adequados. As GPUs da Nvidia são geralmente compatíveis com essas tarefas. Em seguida, atualize os drivers da GPU para a versão mais recente a fim de garantir a compatibilidade e o desempenho ideal. No LM Studio, navegue até as configurações e verifique se a aceleração da GPU está ativada. Para tarefas ou modelos específicos, você também poderá encontrar configurações adicionais para otimizar o desempenho, como o ajuste da alocação de memória para o modelo ou a seleção de opções de quantização orientadas para o desempenho. O monitoramento do desempenho e da temperatura da GPU também pode ajudar no ajuste fino das configurações para uma operação sustentada.