¿Está utilizando grandes modelos lingüísticos (LLM) como ChatGPT, CoPilot, Gemini, etc.?

Mi amigo expresó recientemente su preocupación por la privacidad de las personas que utilizan asistentes de chat de IA como ChatGPT en el lugar de trabajo y comparten información empresarial con ellos. Existe alguna opción para utilizar herramientas similares fuera de línea sin tener que compartir información en línea?

La respuesta es SÍy la solución es utilizar LLM a nivel local.

Este artículo está dirigido a propietarios de empresas, empleados, creadores de contenidos y a cualquier persona interesada en escribir sobre IA teniendo en cuenta la privacidad.

Problemas con las herramientas de escritura de IA en línea

Herramientas de escritura de IA son cada vez más populares, pero plantean preocupaciones válidas sobre la privacidad. Los servicios tradicionales de escritura de IA suelen implicar datos del usuario, lo que puede ser motivo de preocupación. Sin embargo, existe una solución que permite ejecutar grandes modelos lingüísticos (LLM) localmente en tu propia máquina, garantizando la privacidad en cada paso.

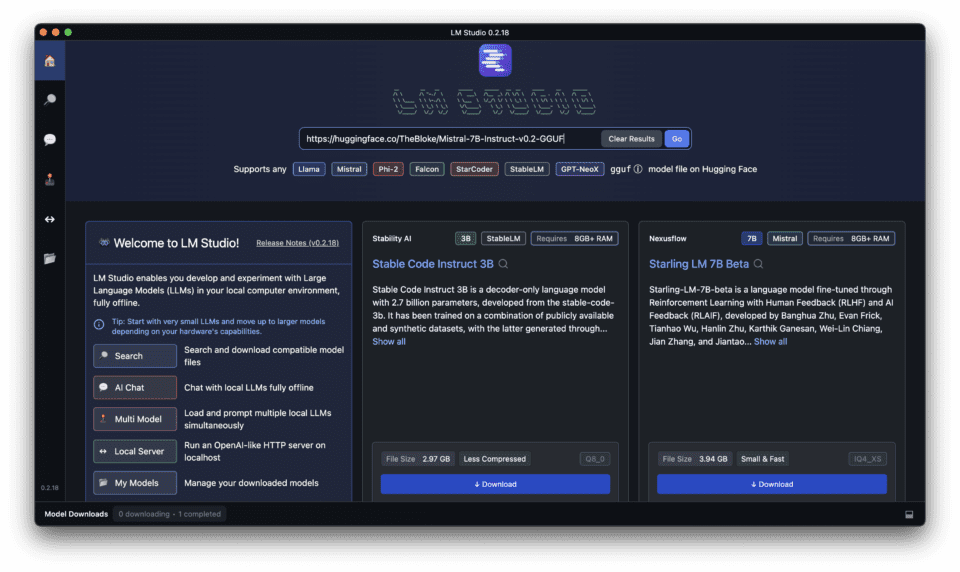

Presentación de LM Studio para ejecutar LLM localmente

Las ventajas de los LLM locales frente a las soluciones basadas en la nube

Ejecutar grandes modelos lingüísticos (LLM) localmente en su ordenador ofrece varias ventajas frente a las soluciones basadas en la nube, como los beneficios locales y de código abierto.

- Privacidad y control: Mantener tus datos en tu propia máquina te garantiza el control total de tu información.

- Tiempos de respuesta más rápidos: La ejecución local de los LLM elimina la necesidad de conexión a Internet, lo que se traduce en tiempos de respuesta más rápidos.

- Rentable: Los LLM locales pueden ser más rentables a largo plazo, ya que no es necesario pagar por los servicios en la nube.

Garantizar la privacidad y el control con LM Studio

LM Studio está diseñado para proporcionar privacidad y control al ejecutar LLM localmente. Ofrece funcionamiento sin conexión, sin dependencia de la nube y modelos de código abierto, lo que garantiza que tus datos permanezcan bajo tu control, destacando sus ventajas locales y de código abierto.

LM Studio se diferencia de otras plataformas LLM locales

LM Studio se diferencia de otras plataformas LLM locales por ofrecer una interfaz fácil de usar, compatibilidad con varios dispositivos y una sólida comunidad de desarrolladores y usuarios.

Descargar e instalar LM Studio: Paso a paso

Siga el siguiente tutorial completo para descargar, instalar y ejecutar LLM locales con LM Studio en su PC o portátil

Configuración de un servidor de inferencia local eficiente con LM Studio

Aprenda a configurar un servidor de inferencia local eficaz con LM Studio para obtener tiempos de respuesta más rápidos y un rendimiento mejorado.

LM Studio ofrece una forma sencilla de ejecutar grandes modelos lingüísticos (LLM) localmente en su ordenador. Esto es lo que necesita saber para una configuración eficaz:

1. Requisitos del sistema:

Antes de descargar e instalar LM Studio, asegúrese de que su ordenador con LM Studio cumple los siguientes requisitos.

LM Studio funciona mejor con recursos de hardware decentes, en particular con una gran cantidad de VRAM. He aquí una pauta general:

- Sistema operativo: Compatible con Windows, Mac y Linux.

- GPU: Compatibilidad con varias GPU, incluidas RTX, M1 y AMD.

- Procesador: Procesador multinúcleo (i5 o equivalente) para un rendimiento más fluido.

- RAM: Se recomienda un mínimo de 8 GB de RAM, con 16 GB+ ideal para los modelos más grandes.

- Almacenamiento: Suficiente espacio libre para alojar el LLM elegido (los modelos pueden variar desde unos pocos GB hasta decenas de GB).

- Conexión a Internet: Se requiere una conexión estable a Internet para descargar el software.

2. Instalación:

Para descargar LM Studio, sigue estos pasos:

- Visite el Estudio LM sitio web.

- Haga clic en el botón "Descargar".

- Elija la versión adecuada para su sistema operativo.

Elegir el modelo adecuado a sus necesidades

3. Elegir un LLM:

LM Studio ofrece una variedad de LLM para elegir, cada uno con diferentes capacidades y tamaños. Tenga en cuenta sus necesidades específicas de escritura y elija el modelo más adecuado.

- LM Studio ofrece diversos LLM de código abierto. Ten en cuenta estos factores:

- Tamaño del modelo: Los modelos más grandes ofrecen más capacidades, pero requieren más recursos.

- Enfoque: Algunos modelos se especializan en tareas específicas como la escritura o la generación de código.

- Cuantización: Busca versiones "cuantizadas" de los modelos. Son más pequeñas y se ejecutan más rápido con una pérdida de precisión mínima.

En la tabla siguiente se comparan algunos de los distintos modelos de LLM disponibles en LM Studio, destacando sus capacidades y casos de uso ideales

Si necesita una lista detallada y completa de modelos, consulte este artículo en el que he comparado los Los 15 primeros Modelos de lenguaje grandes incluidas las de código abierto, con su tamaño, país de desarrollo, etc. Compruébelo para saber más.

| Nombre del modelo | Talla | Capacidades | Casos de uso ideales |

|---|---|---|---|

| Mistral | Pequeño | Generación básica de textos, tareas sencillas de PNL | Borradores rápidos, generación de ideas |

| Ollama | Medio | Generación avanzada de textos, tareas moderadas de PNL | Creación de contenidos, análisis de complejidad moderada |

| ExLlamaV2 | Grande | Generación de textos de alta calidad, tareas complejas de PLN | Artículos detallados, análisis de datos complejos |

| Géminis | Extra grande | Generación de textos de última generación, tareas de PNL muy complejas | Documentos de investigación, creación de contenidos avanzados |

4. Descarga del LLM:

- Una vez que haya descargado LM Studio, dentro de LM Studio, busque y descargue el LLM deseado. El tiempo de descarga puede variar en función del tamaño del modelo y de la velocidad de Internet.

Ejecutar su primera inferencia local

5. Inicio del servidor de inferencia local:

- Una vez descargado el LLM, vaya a la pestaña Servidor de LM Studio.

- Haga clic en "Iniciar servidor" para iniciar el servidor de inferencia local. Este proceso puede tardar unos instantes en función del tamaño del modelo.

6. Optimización de la eficiencia:

- Adaptar el modelo a las necesidades: Elige un LLM que se ajuste a tus tareas específicas. No te decantes por un modelo gigantesco si solo necesitas asistencia básica en redacción.

- Procesamiento por lotes: Considere la posibilidad de enviar varias solicitudes a la vez para algunos modelos, lo que puede resultar más eficaz que las solicitudes individuales. (Consulte la documentación de LM Studio para conocer las capacidades específicas de cada modelo).

- Supervisión de recursos: Vigila el uso de recursos del sistema mientras se ejecuta el servidor. Ajusta la configuración de LM Studio o elige un modelo más pequeño si sobrecarga tu máquina.

Recursos adicionales:

- Documentación de LM Studio ofrece información detallada sobre los modelos disponibles, las opciones de configuración y consejos para solucionar problemas.

Cómo utilizar LM Studio para tareas de procesamiento del lenguaje natural

Libere la potencia de LM Studio para tareas de procesamiento del lenguaje natural

Descubra cómo LM Studio puede utilizarse para diversas tareas de procesamiento del lenguaje natural, desde la creación de contenidos hasta el análisis de datos.

LM Studio destaca a la hora de abordar diversas tareas de Procesamiento del Lenguaje Natural (PLN), ofreciéndole asistencia de IA sin comprometer la privacidad. A continuación te explicamos cómo aprovechar sus capacidades:

1. Generación de textos:

- Elabore textos de marketing, descripciones de productos o publicaciones en redes sociales convincentes proporcionando indicaciones o esquemas para que LM Studio los desarrolle.

- Aporta ideas creativas sobre contenidos a partir de líneas de partida y deja que el modelo genere variaciones.

- Genere diferentes estilos de escritura ajustando sus indicaciones y experimentando con diferentes LLM.

2. Resumir textos:

- LM Studio puede generar resúmenes concisos de artículos o trabajos de investigación extensos, lo que le ahorrará un valioso tiempo de lectura.

- Resuma las opiniones de los clientes o los informes de comentarios para comprender rápidamente los puntos clave e identificar tendencias.

3. Traducción automática:

- Traduzca texto de un idioma a otro con los LLM de LM Studio centrados en la traducción. Aunque algunos no estén a la altura de los servicios de traducción especializados, pueden ser una herramienta útil para las necesidades básicas.

4. Clasificación de textos:

- Entrene un LLM para categorizar sus datos basándose en criterios específicos. Por ejemplo, clasifique los correos electrónicos de atención al cliente por tipo de incidencia o sentimiento.

- Esta funcionalidad puede ser útil para organizar grandes conjuntos de datos o automatizar tareas básicas de filtrado.

5. Vinculación textual:

- Determine si una afirmación específica se deduce lógicamente de otra utilizando las capacidades de razonamiento de LM Studio.

- Esto puede ser útil para tareas como el análisis de documentos jurídicos o la identificación de incoherencias en el texto.

6. Respuesta a preguntas:

- Entrene un LLM en una base de conocimientos específica y utilícelo para responder a sus preguntas en un formato de lenguaje natural.

- Esto puede ser útil para crear FAQs internas o chatbots para atención al cliente, aprovechando la potencia de LLMs como ChatGPT.

Utilización de LM Studio para tareas de PNL:

- Elegir el LLM adecuado: Seleccione un LLM específicamente entrenado para la tarea de PLN (Procesamiento del Lenguaje Natural) que desee realizar. La documentación suele indicar los puntos fuertes del modelo.

- Crear estímulos eficaces: Proporcione indicaciones claras y concisas que guíen al LLM hacia el resultado deseado, de forma similar a la interacción con ChatGPT. Cuanto mejores sean las instrucciones, más precisos serán los resultados.

- Experimentar e iterar: No tengas miedo de experimentar con diferentes avisos y ajustes de LLM. Se trata de un proceso iterativo para lograr resultados óptimos, que a menudo requiere ajustes en la interfaz de usuario para afinar el comportamiento de la aplicación.

- Afinar y postprocesar: El resultado del LLM puede requerir cierto pulido o supervisión humana para tareas específicas. Ten en cuenta la revisión y edición para garantizar la precisión, especialmente en tareas críticas.

Acuérdate:

- Aunque LM Studio ofrece impresionantes capacidades de PNL, aún está en fase de desarrollo. Los resultados pueden variar en función de la complejidad de la tarea y del modelo elegido.

Funciones avanzadas de LM Studio: Mejora tu experiencia LLM local

Exploración de opciones y ajustes avanzados en LM Studio

LM Studio ofrece configuraciones y opciones avanzadas para mejorar tu experiencia local LLM, incluyendo:

- Técnicas de cuantificación y optimización: Estas técnicas pueden mejorar los tiempos de respuesta y reducir el uso de recursos.

- Integración con otras aplicaciones y API: LM Studio puede integrarse con varias aplicaciones y API para un uso sin problemas.

LM Studio: Compatibilidad, asistencia y comunidad

Compatibilidad garantizada: LM Studio es compatible con Windows, Mac, Linux y varias GPU.

LM Studio es compatible con varios sistemas operativos y GPU, lo que garantiza que pueda ser utilizado por una amplia gama de usuarios.

Obtener ayuda: Aprovechar la comunidad de LM Studio y los canales de asistencia

Si necesitas ayuda con LM Studio, consulta la comunidad o los canales de asistencia para obtener recursos útiles y respuestas a tus preguntas.

Contribución al proyecto LM Studio: Desarrollo de código abierto

Si está interesado en contribuir a la Proyecto LM Studioexplore las oportunidades de desarrollo de código abierto y únase a la comunidad de desarrolladores.

Preguntas frecuentes (FAQ)

¿Cuáles son los requisitos de LM Studio para funcionar localmente en Mac y Windows?

Para utilizar un LLM localmente a través de la potente y gratuita aplicación LM Studio, tu ordenador Mac o Windows debe cumplir unos requisitos específicos. Para ambos sistemas operativos, LM Studio requiere al menos 8 GB de RAM, aunque se recomiendan 16 GB para un rendimiento óptimo. En Windows, requiere Windows 10 o posterior, y en macOS, debe ejecutar macOS 10.14 (Mojave) o posterior. Entre los requisitos adicionales se incluyen unos 400 MB de espacio de almacenamiento para alojar la aplicación y los modelos locales seleccionados, y para casos de uso avanzados, se sugiere una GPU compatible para la aceleración de GPU.

¿Cómo descargo e instalo LM Studio en mi ordenador?

Descargar e instalar LM Studio es muy sencillo. Comienza con el paso 1 visitando el sitio web oficial de LM Studio o un repositorio de confianza como GitHub o HuggingFace para descargar la aplicación para tu sistema operativo (macOS o Windows). Para el paso 2, localiza el archivo descargado en tu carpeta de descargas y haz doble clic para iniciar el proceso de instalación. Siga las instrucciones que aparecen en pantalla para el paso 3, que consiste en aceptar las condiciones del servicio y seleccionar una ubicación de instalación. Una vez finalizada la instalación, puede iniciar LM Studio desde la lista de aplicaciones o el menú de inicio.

¿Cómo elijo un modelo para descargarlo en LM Studio para uso local?

Para elegir un modelo y descargarlo para utilizarlo en LM Studio, inicie la aplicación y conéctese a Internet. Vaya a la sección "Modelos", donde verá una lista de los LLM disponibles, como Mistral, Ollama y Mixtral. Ten en cuenta tus necesidades específicas, por ejemplo, si buscas un modelo optimizado para la comprensión lingüística (Mistral), la generación de contenidos creativos (Ollama) o tareas personalizadas (Mixtral). Pase el ratón por encima del modelo elegido para ver más detalles y haga clic en "Descargar" para empezar. Ten en cuenta que los modelos pueden tardar un poco en descargarse, dependiendo de su tamaño y de tu velocidad de Internet.

¿Cómo inicio una sesión de chat utilizando mi LLM descargado en LM Studio?

Después de descargar y configurar correctamente un LLM localmente en LM Studio, iniciar una sesión de chat es muy sencillo. Abra LM Studio y, en el menú principal, seleccione la función "Chat". A continuación, seleccione el modelo descargado que desea utilizar para la sesión. Accederá a una interfaz de chat en la que podrá escribir sus consultas o preguntas. Pulsa "Intro" o "Enviar" para enviar el texto, y el LLM generará una respuesta basada en la información introducida y la mostrará en la ventana de chat. Esta función puede utilizarse para diversas interacciones, desde obtener ayuda para escribir hasta depurar código.

¿Puedo utilizar LM Studio para generar transcripciones localmente?

Sí, LM Studio permite generar transcripciones localmente utilizando LLM optimizados para tareas de reconocimiento del habla como Mistral. Para generar una transcripción, asegúrate de haber descargado un modelo adecuado para la transcripción. Abre la aplicación, selecciona la opción "Transcripción" y elige tu modelo. Puede cargar archivos de audio directamente en LM Studio, y el LLM seleccionado procesará el audio y generará una transcripción de texto. Esto puede ser especialmente útil para los usuarios que necesitan un acceso rápido y sin conexión a servicios de transcripción para reuniones, entrevistas o creación de contenidos.

¿Qué es la cuantización en LM Studio y cómo mejora el rendimiento?

La cuantización es un proceso utilizado en LM Studio para optimizar el rendimiento del modelo reduciendo la precisión de los números utilizados en el modelo. Esta técnica permite a la aplicación ejecutar modelos más grandes en dispositivos con recursos limitados, ya que reduce el tamaño total del modelo y acelera el cálculo, lo que resulta especialmente beneficioso para dispositivos sin aceleración GPU dedicada. Equilibra el rendimiento y la calidad, lo que permite utilizar modelos locales avanzados en una gama más amplia de ordenadores. Los usuarios pueden activar la cuantización desde el menú de ajustes de LM Studio, seleccionando el nivel de cuantización que mejor se adapte a su equilibrio entre rendimiento y precisión.

¿Es posible integrar los LLM locales de LM Studio con aplicaciones externas a través de la API?

Sí, LM Studio ofrece integración API para los modelos locales que haya configurado, lo que permite a los desarrolladores ampliar las capacidades de sus aplicaciones o servicios externos aprovechando la potencia de los grandes modelos lingüísticos (LLM) a nivel local. Esta función admite una gran variedad de casos de uso, desde la mejora de aplicaciones de chat con procesamiento de lenguaje natural hasta la incorporación de análisis de texto avanzados en sistemas de gestión de contenidos. Para acceder a la API, vaya a la configuración de LM Studio y active el uso de la API. Se le proporcionará una clave de API y la información del punto final para integrar el LLM en su aplicación.

¿Cómo puedo garantizar el mejor rendimiento al utilizar la aceleración por GPU en LM Studio?

Para garantizar el mejor rendimiento con la aceleración de GPU en LM Studio, compruebe primero que el hardware de su ordenador incluye una GPU compatible con los recursos adecuados. Las GPU Nvidia suelen ser compatibles con estas tareas. A continuación, actualiza los controladores de la GPU a la última versión para garantizar la compatibilidad y un rendimiento óptimo. En LM Studio, ve a la configuración y asegúrate de que la aceleración de la GPU está activada. En el caso de tareas o modelos específicos, es posible que también encuentres opciones adicionales para optimizar el rendimiento, como ajustar la asignación de memoria para el modelo o seleccionar opciones de cuantización orientadas al rendimiento. Monitorizar el rendimiento y la temperatura de la GPU también puede ayudar a ajustar la configuración para un funcionamiento sostenido.