Utilisez-vous de grands modèles linguistiques (LLM) tels que ChatGPT, CoPilot, Gemini, etc.

Mon ami a récemment fait part de ses préoccupations en matière de protection de la vie privée concernant l'utilisation d'assistants de conversation IA tels que ChatGPT sur le lieu de travail et le partage d'informations professionnelles avec eux. Est-il possible d'utiliser des outils similaires hors ligne sans avoir à partager des informations en ligne ?

La réponse est OUIet la solution consiste à utiliser les MLD au niveau local.

Cet article s'adresse aux chefs d'entreprise, aux employés, aux créateurs de contenu et à toute personne intéressée par l'écriture AI dans le respect de la vie privée.

Problème des outils de rédaction d'IA en ligne

Outils d'écriture d'IA sont de plus en plus populaires, mais elles soulèvent des préoccupations valables en matière de protection de la vie privée. Les services traditionnels de rédaction d'IA impliquent souvent des données d'utilisateur, ce qui peut être une source d'inquiétude. Il existe toutefois une solution qui vous permet d'exécuter localement de grands modèles de langage (LLM) sur votre propre machine, en garantissant la confidentialité à chaque étape.

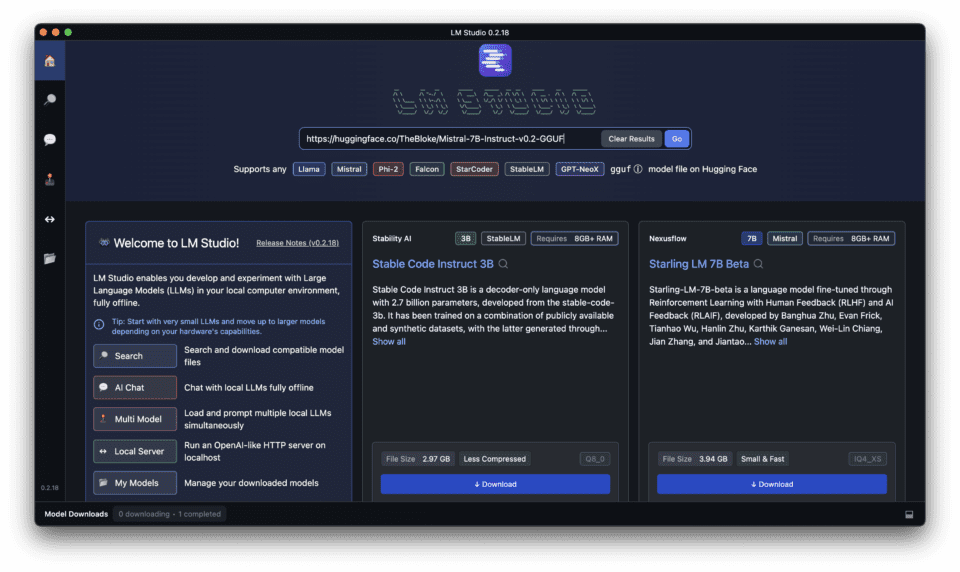

Introduction de LM Studio pour l'exécution locale de LLM

Les avantages des LLM locaux par rapport aux solutions basées sur l'informatique en nuage

L'exécution de grands modèles de langage (LLM) localement sur votre ordinateur présente plusieurs avantages par rapport aux solutions basées sur le cloud, notamment des avantages locaux et open-source.

- Vie privée et contrôle: Le fait de conserver vos données sur votre propre machine vous garantit un contrôle total sur vos informations.

- Des temps de réponse plus rapides: L'exécution locale des LLM élimine la nécessité d'une connectivité internet, ce qui se traduit par des temps de réponse plus rapides.

- Rentable: Les LLM locaux peuvent être plus rentables à long terme, car vous n'avez pas besoin de payer pour des services en nuage.

Garantir la confidentialité et le contrôle avec LM Studio

LM Studio est conçu pour assurer la confidentialité et le contrôle lors de l'exécution locale des LLM. Il offre un fonctionnement hors ligne, aucune dépendance au cloud, et des modèles open-source, garantissant que vos données restent sous votre contrôle, soulignant ses avantages locaux et open-source.

Comment LM Studio se distingue-t-il des autres plateformes locales de formation continue ?

LM Studio se différencie des autres plateformes locales de LLM en offrant une interface conviviale, une compatibilité avec différents appareils et une forte communauté de développeurs et d'utilisateurs.

Télécharger et installer LM Studio : Pas à pas

Suivez le tutoriel complet ci-dessous pour télécharger, installer et exécuter des LLM locaux avec LM Studio sur votre PC ou votre ordinateur portable.

Mise en place d'un serveur d'inférence locale efficace avec LM Studio

Apprenez à mettre en place un serveur d'inférence local efficace avec LM Studio pour des temps de réponse plus rapides et des performances améliorées.

LM Studio offre un moyen convivial d'exécuter de grands modèles de langage (LLM) localement sur votre ordinateur. Voici ce qu'il faut savoir pour une installation efficace :

1. Configuration requise :

Avant de télécharger et d'installer LM Studio, assurez-vous que votre ordinateur équipé de LM Studio répond aux exigences suivantes.

LM Studio fonctionne mieux avec des ressources matérielles décentes, en particulier une grande quantité de VRAM. Voici une ligne directrice générale :

- Système d'exploitation: Compatible avec Windows, Mac et Linux.

- GPU: Prise en charge de divers GPU, y compris RTX, M1 et AMD.

- Processeur : Processeur multicœur (i5 ou équivalent) pour des performances plus fluides.

- RAM : Un minimum de 8 Go de RAM est recommandé, 16 Go ou plus étant l'idéal pour les grands modèles.

- Stockage : Suffisamment d'espace libre pour accueillir le LLM choisi (les modèles peuvent varier de quelques Go à plusieurs dizaines de Go).

- Connexion Internet: Une connexion internet stable est nécessaire pour télécharger le logiciel.

2. L'installation :

Pour télécharger LM Studio, suivez les étapes suivantes :

- Visitez le site LM Studio site web.

- Cliquez sur le bouton "Télécharger".

- Choisissez la version appropriée pour votre système d'exploitation.

Choisir le bon modèle pour vos besoins

3. Le choix d'un LLM :

LM Studio propose une variété de LLM, chacun avec des capacités et des tailles différentes. Tenez compte de vos besoins spécifiques en matière d'écriture et choisissez le modèle le plus approprié.

- LM Studio propose une variété de LLM open-source. Tenez compte des facteurs suivants :

- Taille du modèle : Les modèles plus grands offrent plus de possibilités mais nécessitent plus de ressources.

- Focus : Certains modèles se spécialisent dans des tâches spécifiques telles que l'écriture ou la génération de code.

- Quantification : Recherchez les versions "quantifiées" des modèles. Elles sont plus petites et s'exécutent plus rapidement avec une perte de précision minimale.

Le tableau ci-dessous compare certains des différents modèles LLM disponibles dans LM Studio, en mettant en évidence leurs capacités et les cas d'utilisation idéaux.

Si vous avez besoin d'une liste détaillée et complète des modèles, consultez cet article dans lequel j'ai comparé les Top 15 Grands modèles de langage y compris les logiciels libres avec leur taille, leur pays de développement, etc. Consultez-le pour en savoir plus.

| Nom du modèle | Taille | Capacités | Cas d'utilisation idéaux |

|---|---|---|---|

| Mistral | Petit | Génération de textes de base, tâches NLP simples | Projets rapides, génération d'idées |

| Ollama | Moyen | Génération avancée de textes, tâches NLP modérées | Création de contenu, analyse de complexité modérée |

| ExLlamaV2 | Grandes dimensions | Génération de textes de haute qualité, tâches NLP complexes | Articles détaillés, analyse de données complexes |

| Gémeaux | Très grand | Génération de textes à la pointe de la technologie, tâches NLP très complexes | Documents de recherche, création de contenu avancé |

4. Téléchargement du LLM :

- Une fois que vous avez téléchargé LM Studio, recherchez et téléchargez le LLM souhaité dans LM Studio. Le temps de téléchargement peut varier en fonction de la taille du modèle et de votre vitesse internet.

Exécution de votre première inférence locale

5. Démarrage du serveur d'inférence local :

- Une fois le LLM téléchargé, naviguez vers l'onglet Serveur dans LM Studio.

- Cliquez sur "Démarrer le serveur" pour lancer le serveur d'inférence local. Ce processus peut prendre quelques instants en fonction de la taille du modèle.

6. Optimiser l'efficacité :

- Adapter le modèle aux besoins : Choisissez un LLM qui corresponde à vos tâches spécifiques. N'optez pas pour un modèle géant si vous n'avez besoin que d'une aide à la rédaction de base.

- Traitement par lots : Pour certains modèles, il est possible d'envoyer plusieurs messages en même temps, ce qui peut être plus efficace que des demandes individuelles. (Consultez la documentation de LM Studio pour connaître les capacités spécifiques de chaque modèle).

- Suivi des ressources : Gardez un œil sur l'utilisation des ressources de votre système lorsque vous faites tourner le serveur. Ajustez les paramètres de LM Studio ou choisissez un modèle plus petit si votre machine est trop sollicitée.

Ressources complémentaires :

- Documentation de LM Studio fournit des informations détaillées sur les modèles disponibles, les options de configuration et les conseils de dépannage.

Comment utiliser LM Studio pour des tâches de traitement du langage naturel ?

Exploiter la puissance de LM Studio pour les tâches de traitement du langage naturel

Découvrez comment LM Studio peut être utilisé pour diverses tâches de traitement du langage naturel, de la création de contenu à l'analyse de données.

LM Studio excelle dans la réalisation de diverses tâches de traitement du langage naturel (NLP), vous permettant de bénéficier de l'assistance de l'IA sans compromettre la protection de la vie privée. Voici comment tirer parti de ses capacités :

1. Génération de texte :

- Rédigez des textes marketing, des descriptions de produits ou des messages sur les réseaux sociaux convaincants en fournissant des idées ou des schémas que LM Studio pourra développer.

- Faites un remue-méninges pour trouver des idées de contenu créatif en lui donnant des lignes de départ et en laissant le modèle générer des variations.

- Créez différents styles d'écriture en adaptant vos messages-guides et en expérimentant différents MLD.

2. Résumés de textes :

- Fournissez de longs articles ou documents de recherche à LM Studio, et il peut générer des résumés concis, vous faisant gagner un temps précieux de lecture.

- Résumez les commentaires des clients ou les rapports de rétroaction pour saisir rapidement les points clés et identifier les tendances.

3. Traduction automatique :

- Traduisez des textes d'une langue à l'autre avec les LLM de LM Studio axés sur la traduction. Bien que certains ne soient pas à la hauteur des services de traduction spécialisés, ils peuvent constituer un outil pratique pour les besoins de base.

4. Classification des textes :

- Entraînez un LLM à classer vos données en fonction de critères spécifiques. Par exemple, classer les courriels de l'assistance clientèle par type de problème ou par sentiment.

- Cette fonctionnalité peut être utile pour organiser de grands ensembles de données ou pour automatiser des tâches de filtrage de base.

5. Entaillement textuel :

- Déterminer si une déclaration spécifique découle logiquement d'une autre en utilisant les capacités de raisonnement de LM Studio.

- Cela peut être utile pour des tâches telles que l'analyse de documents juridiques ou l'identification d'incohérences dans un texte.

6. Réponse aux questions :

- Entraînez un LLM sur une base de connaissances spécifique et utilisez-le pour répondre à vos questions en langage naturel.

- Cela peut être utile pour créer des FAQ internes ou des chatbots pour le service client, en tirant parti de la puissance des LLM comme ChatGPT.

Utilisation de LM Studio pour les tâches NLP :

- Choisir le bon LLM : Sélectionnez un LLM spécifiquement formé pour la tâche NLP (Natural Language Processing) que vous souhaitez effectuer. La documentation indique souvent les points forts du modèle.

- Rédiger des messages-guides efficaces : Fournissez des invites claires et concises qui guident le MLD vers le résultat souhaité, comme dans le cas d'une interaction avec ChatGPT. Plus les messages sont clairs, plus les résultats sont précis.

- Expérimenter et répéter : N'hésitez pas à expérimenter différentes invites et différents paramètres LLM. Il s'agit d'un processus itératif qui permet d'obtenir des résultats optimaux et qui nécessite souvent des ajustements de l'interface utilisateur pour affiner le comportement de l'application.

- Affiner et post-traiter : Les résultats du LLM peuvent nécessiter un polissage ou une supervision humaine pour des tâches spécifiques. Prévoyez une révision et une édition pour garantir l'exactitude, en particulier pour les tâches critiques.

Rappelez-vous :

- Bien que LM Studio offre des capacités NLP impressionnantes, il est encore en cours de développement. Les résultats peuvent varier en fonction de la complexité de la tâche et du modèle choisi.

Fonctionnalités avancées de LM Studio : Améliorer votre expérience locale du LLM

Exploration des paramètres et options avancés dans LM Studio

LM Studio offre des paramètres et des options avancés pour améliorer votre expérience locale du LLM, y compris :

- Techniques de quantification et d'optimisation: Ces techniques permettent d'améliorer les temps de réponse et de réduire l'utilisation des ressources.

- Intégration avec d'autres applications et API: LM Studio peut être intégré à diverses applications et API pour une utilisation transparente.

LM Studio : Compatibilité, support et communauté

Assurer la compatibilité : Prise en charge de LM Studio pour Windows, Mac, Linux et divers GPU

LM Studio est compatible avec différents systèmes d'exploitation et GPU, ce qui lui permet d'être utilisé par un large éventail d'utilisateurs.

Obtenir de l'aide : Exploiter la communauté et les canaux d'assistance de LM Studio

Si vous avez besoin d'aide avec LM Studio, consultez la communauté ou les canaux d'assistance pour obtenir des ressources utiles et des réponses à vos questions.

Contribuer au projet LM Studio : Développement Open-Source

Si vous souhaitez contribuer à la Projet LM StudioLe site Web de la Commission européenne, le site Web de la Commission européenne, le site Web de la Commission européenne, le site Web de la Commission européenne et le site Web de la Commission européenne.

Foire aux questions (FAQ)

Quelle est la configuration requise par LM studio pour fonctionner localement sur Mac et Windows ?

Pour utiliser un LLM localement grâce à l'application gratuite et puissante LM Studio, votre ordinateur Mac ou Windows doit répondre à des exigences spécifiques. Pour les deux systèmes d'exploitation, LM Studio nécessite au moins 8 Go de RAM, mais 16 Go sont recommandés pour des performances optimales. Sous Windows, il faut Windows 10 ou une version plus récente, et sous macOS, vous devez utiliser macOS 10.14 (Mojave) ou une version plus récente. Les exigences supplémentaires comprennent environ 400 Mo d'espace de stockage pour accueillir l'application et les modèles locaux sélectionnés, et pour les cas d'utilisation avancés, un GPU compatible pour l'accélération GPU est suggéré.

Comment télécharger et installer LM Studio sur mon ordinateur ?

Le téléchargement et l'installation de LM Studio sont simples. Commencez par l'étape 1 en visitant le site officiel de LM Studio ou un dépôt de confiance comme GitHub ou HuggingFace pour télécharger l'application pour votre système d'exploitation (macOS ou Windows). Pour l'étape 2, localisez le fichier téléchargé dans votre dossier Téléchargements et double-cliquez pour lancer le processus d'installation. Suivez les instructions à l'écran pour l'étape 3, qui consiste à accepter les conditions de service et à sélectionner un emplacement d'installation. Une fois l'installation terminée, vous pouvez lancer LM Studio à partir de votre liste d'applications ou du menu Démarrer.

Comment choisir un modèle à télécharger dans LM Studio pour une utilisation locale ?

Pour choisir un modèle à télécharger pour l'utiliser dans LM Studio, commencez par lancer l'application et connectez-vous à Internet. Naviguez jusqu'à la section "Modèles" où vous verrez une liste de LLM disponibles tels que Mistral, Ollama et Mixtral. Tenez compte de vos besoins spécifiques, par exemple si vous recherchez un modèle optimisé pour la compréhension du langage (Mistral), la génération de contenu créatif (Ollama) ou les tâches personnalisées (Mixtral). Survolez le modèle de votre choix pour en savoir plus et cliquez sur "Télécharger" pour commencer. Notez que le téléchargement des modèles peut prendre un certain temps, en fonction de leur taille et de votre vitesse d'accès à Internet.

Comment démarrer une session de chat en utilisant mon LLM téléchargé dans LM Studio ?

Après avoir téléchargé et configuré localement un LLM dans LM Studio, il est facile de démarrer une session de chat. Ouvrez LM Studio, et dans le menu principal, sélectionnez la fonction 'Chat'. Choisissez ensuite le modèle téléchargé que vous souhaitez utiliser pour la session. Vous serez dirigé vers une interface de chat où vous pourrez taper vos questions ou vos demandes. Appuyez sur "Enter" ou cliquez sur "Send" pour soumettre votre texte, et le LLM générera une réponse basée sur l'entrée, en l'affichant dans la fenêtre de chat. Cette fonction peut être utilisée pour diverses interactions, de l'aide à la rédaction au débogage de code.

Puis-je utiliser LM Studio pour générer des transcriptions localement ?

Oui, LM Studio permet de générer des transcriptions localement en utilisant des LLM optimisés pour les tâches de reconnaissance vocale comme Mistral. Pour générer une transcription, assurez-vous d'avoir téléchargé un modèle approprié pour la transcription. Ouvrez l'application et sélectionnez l'option "Transcription", puis choisissez votre modèle. Vous pouvez télécharger des fichiers audio directement dans LM Studio, et le LLM sélectionné traitera l'audio et produira une transcription textuelle. Cela peut être particulièrement utile pour les utilisateurs qui ont besoin d'un accès rapide et hors ligne à des services de transcription pour des réunions, des entretiens ou la création de contenu.

Qu'est-ce que la quantification dans LM Studio et comment améliore-t-elle les performances ?

La quantification est un processus utilisé dans LM Studio pour optimiser les performances du modèle en réduisant la précision des nombres utilisés dans le modèle. Cette technique permet à l'application d'exécuter des modèles plus importants sur des appareils aux ressources limitées en diminuant la taille globale du modèle et en accélérant les calculs, ce qui est particulièrement bénéfique pour les appareils ne disposant pas d'une accélération GPU dédiée. Elle permet d'équilibrer les performances et la qualité, ce qui rend possible l'utilisation de modèles locaux avancés sur un plus grand nombre d'ordinateurs. Les utilisateurs peuvent activer la quantification à partir du menu des paramètres de LM Studio, en sélectionnant le niveau de quantification qui correspond le mieux à leur équilibre entre performance et précision.

Est-il possible d'intégrer les LLM locaux de LM Studio à des applications externes via l'API ?

Oui, LM Studio offre une intégration API pour les modèles locaux que vous avez mis en place, permettant aux développeurs d'étendre les capacités de leurs applications ou services externes en exploitant la puissance des grands modèles de langage (LLM) localement. Cette fonctionnalité prend en charge une variété de cas d'utilisation, de l'amélioration des applications de chat avec le traitement du langage naturel à l'incorporation d'une analyse de texte avancée dans les systèmes de gestion de contenu. Pour accéder à l'API, naviguez dans les paramètres de LM Studio et activez l'utilisation de l'API. Vous recevrez une clé API et des informations sur les points de terminaison pour intégrer le LLM dans votre application.

Comment puis-je garantir les meilleures performances lorsque j'utilise l'accélération GPU dans LM Studio ?

Pour garantir les meilleures performances avec l'accélération GPU dans LM Studio, vérifiez d'abord que le matériel de votre ordinateur comprend un GPU compatible avec des ressources adéquates. Les GPU Nvidia sont généralement pris en charge pour ces tâches. Ensuite, mettez à jour les pilotes de votre GPU avec la dernière version pour garantir la compatibilité et des performances optimales. Dans LM Studio, accédez aux paramètres et assurez-vous que l'accélération GPU est activée. Pour des tâches ou des modèles spécifiques, vous pouvez également trouver des paramètres supplémentaires pour optimiser les performances, tels que l'ajustement de l'allocation de mémoire pour le modèle ou la sélection d'options de quantification axées sur les performances. La surveillance des performances et de la température du GPU peut également aider à affiner les paramètres pour un fonctionnement durable.