Verwenden Sie große Sprachmodelle (LLMs) wie ChatGPT, CoPilot, Gemini usw.?

Mein Freund äußerte kürzlich Bedenken hinsichtlich des Datenschutzes bei der Verwendung von KI-Chat-Assistenten wie ChatGPT am Arbeitsplatz und der Weitergabe von Geschäftsdaten an diese. Gibt es eine Möglichkeit, ähnliche Tools offline zu nutzen, ohne Informationen online teilen zu müssen?

Die Antwort lautet YESund die Lösung besteht darin, LLMs lokal zu verwenden.

Dieser Artikel richtet sich an Geschäftsinhaber, Mitarbeiter, Autoren von Inhalten und alle, die sich für KI unter Berücksichtigung des Datenschutzes interessieren.

Probleme mit Online-AI-Schreibwerkzeugen

KI-Schreibwerkzeuge erfreuen sich zunehmender Beliebtheit, werfen aber berechtigte Bedenken hinsichtlich des Datenschutzes auf. Herkömmliche KI-Schreibdienste beziehen oft Nutzerdaten mit ein, was Anlass zur Sorge geben kann. Es gibt jedoch eine Lösung, die es Ihnen ermöglicht, große Sprachmodelle (LLMs) lokal auf Ihrem eigenen Rechner auszuführen, wobei der Datenschutz bei jedem Schritt gewährleistet ist.

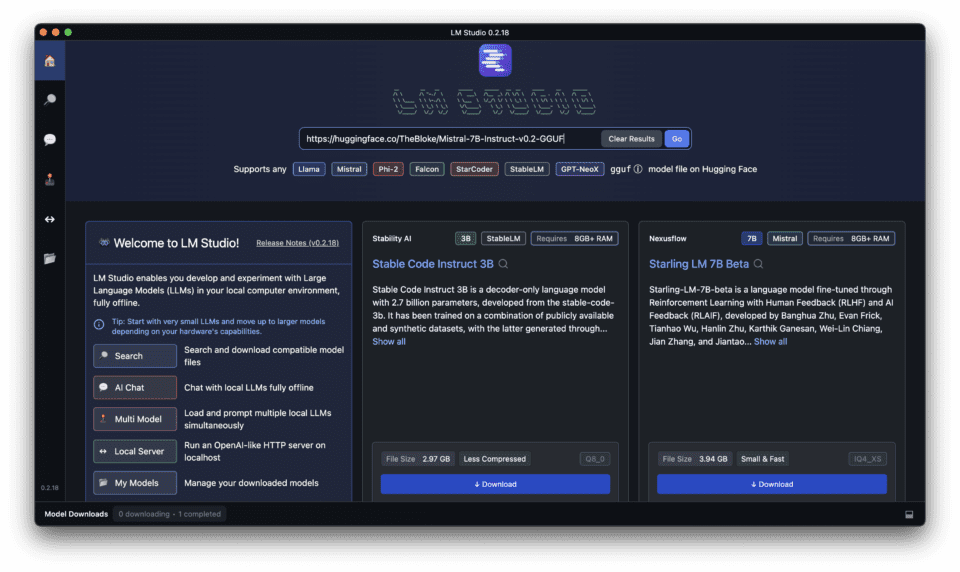

Einführung von LM Studio für die lokale Durchführung von LLMs

Die Vorteile lokaler LLMs gegenüber Cloud-basierten Lösungen

Die lokale Ausführung von großen Sprachmodellen (LLMs) auf Ihrem Computer bietet mehrere Vorteile gegenüber Cloud-basierten Lösungen, darunter die Vorteile von lokalen und Open-Source-Lösungen.

- Datenschutz und Kontrolle: Wenn Sie Ihre Daten auf Ihrem eigenen Rechner speichern, haben Sie die volle Kontrolle über Ihre Daten.

- Schnellere Reaktionszeiten: Durch die lokale Ausführung von LLMs entfällt die Notwendigkeit einer Internetverbindung, was zu schnelleren Reaktionszeiten führt.

- Kosteneffizient: Lokale LLM können auf lange Sicht kostengünstiger sein, da Sie nicht für Cloud-Dienste bezahlen müssen.

Sicherstellung von Datenschutz und Kontrolle mit LM Studio

LM Studio wurde entwickelt, um Privatsphäre und Kontrolle bei der lokalen Ausführung von LLMs zu gewährleisten. Es bietet Offline-Betrieb, keine Cloud-Abhängigkeit und Open-Source-Modelle, wodurch sichergestellt wird, dass Ihre Daten unter Ihrer Kontrolle bleiben, was seine lokalen und Open-Source-Vorteile unterstreicht.

Wie sich LM Studio von anderen lokalen LLM-Plattformen abhebt

LM Studio unterscheidet sich von anderen lokalen LLM-Plattformen durch eine benutzerfreundliche Oberfläche, Kompatibilität mit verschiedenen Geräten und eine starke Gemeinschaft von Entwicklern und Benutzern.

LM Studio herunterladen und installieren: Schritt für Schritt

Folgen Sie der nachstehenden umfassenden Anleitung zum Herunterladen, Installieren und Ausführen lokaler LLMs mit LM Studio auf Ihrem PC oder Laptop

Einrichten eines effizienten lokalen Inferenzservers mit LM Studio

Erfahren Sie, wie Sie mit LM Studio einen effizienten lokalen Inferenzserver einrichten können, um schnellere Antwortzeiten und eine bessere Leistung zu erzielen.

LM Studio bietet eine benutzerfreundliche Möglichkeit, große Sprachmodelle (LLMs) lokal auf Ihrem Computer auszuführen. Hier erfahren Sie, was Sie für eine effiziente Einrichtung wissen müssen:

1. Systemanforderungen:

Bevor Sie LM Studio herunterladen und installieren, stellen Sie sicher, dass Ihr Computer mit LM Studio die folgenden Anforderungen erfüllt.

LM Studio funktioniert am besten mit angemessenen Hardware-Ressourcen, insbesondere mit einer großen Menge an VRAM. Hier ist eine allgemeine Richtlinie:

- Betriebssystem: Kompatibel mit Windows, Mac und Linux.

- GPU: Unterstützung für verschiedene GPUs, einschließlich RTX, M1 und AMD.

- Prozessor: Multi-Core-Prozessor (i5 oder gleichwertig) für bessere Leistung.

- RAM: Empfohlen werden mindestens 8 GB RAM, bei größeren Modellen sind 16 GB und mehr ideal.

- Lagerung: Genügend freier Speicherplatz für das gewählte LLM (die Modelle können zwischen einigen GB und mehreren Dutzend GB groß sein).

- Internetverbindung: Für das Herunterladen der Software ist eine stabile Internetverbindung erforderlich.

2. Einbau:

Um LM Studio herunterzuladen, gehen Sie folgendermaßen vor:

- Besuchen Sie die LM-Studio Website.

- Klicken Sie auf die Schaltfläche "Herunterladen".

- Wählen Sie die für Ihr Betriebssystem geeignete Version.

Die Wahl des richtigen Modells für Ihre Bedürfnisse

3. Die Wahl eines LLM:

LM Studio bietet eine Vielzahl von LLMs mit unterschiedlichen Funktionen und Größen an, aus denen Sie wählen können. Berücksichtigen Sie Ihre spezifischen Schreibanforderungen und wählen Sie das am besten geeignete Modell.

- LM Studio bietet eine Reihe von Open-Source-LLMs an. Berücksichtigen Sie diese Faktoren:

- Modell Größe: Größere Modelle bieten mehr Möglichkeiten, erfordern aber auch mehr Ressourcen.

- Schwerpunkt: Einige Modelle sind auf bestimmte Aufgaben wie das Schreiben oder die Codegenerierung spezialisiert.

- Quantisierung: Suchen Sie nach "quantisierten" Versionen von Modellen. Diese sind kleiner und laufen schneller bei minimalem Genauigkeitsverlust.

Die folgende Tabelle vergleicht einige der verschiedenen in LM Studio verfügbaren LLM-Modelle und hebt ihre Fähigkeiten und idealen Anwendungsfälle hervor

Wenn Sie eine detaillierte und umfassende Liste der Modelle benötigen, lesen Sie diesen Artikel, in dem ich die folgenden Modelle verglichen habe Top 15 Große Sprachmodelle einschließlich der Open-Source-Programme mit ihrer Größe, dem Land, in dem sie entwickelt wurden, usw. Bitte schauen Sie sich das an, um mehr zu erfahren.

| Name des Modells | Größe | Fähigkeiten | Ideale Anwendungsfälle |

|---|---|---|---|

| Mistral | Klein | Einfache Texterstellung, einfache NLP-Aufgaben | Schnelle Entwürfe, Ideenfindung |

| Ollama | Mittel | Fortgeschrittene Texterstellung, moderate NLP-Aufgaben | Erstellung von Inhalten, Analyse mittlerer Komplexität |

| ExLlamaV2 | Groß | Hochwertige Texterstellung, komplexe NLP-Aufgaben | Ausführliche Artikel, komplexe Datenanalyse |

| Zwillinge | Extra groß | Textgenerierung auf dem neuesten Stand der Technik, hochkomplexe NLP-Aufgaben | Forschungsarbeiten, Erstellung fortgeschrittener Inhalte |

4. Herunterladen des LLM:

- Sobald Sie LM Studio heruntergeladen haben, suchen Sie in LM Studio nach dem gewünschten LLM und laden es herunter. Die Downloadzeit kann je nach Größe des Modells und Ihrer Internetgeschwindigkeit variieren.

Ausführen Ihrer ersten lokalen Inferenz

5. Starten des lokalen Inferenzservers:

- Sobald die LLM heruntergeladen ist, navigieren Sie zur Registerkarte Server in LM Studio.

- Klicken Sie auf "Server starten", um den lokalen Inferenzserver zu starten. Dieser Vorgang kann je nach Größe des Modells einige Augenblicke dauern.

6. Optimierung der Effizienz:

- Modell an Bedürfnisse anpassen: Wählen Sie einen LLM-Studiengang, der auf Ihre spezifischen Aufgaben abgestimmt ist. Entscheiden Sie sich nicht für ein riesiges Modell, wenn Sie nur grundlegende Unterstützung beim Schreiben benötigen.

- Stapelverarbeitung: Ziehen Sie in Erwägung, für einige Modelle mehrere Aufforderungen auf einmal zu senden, was effizienter sein kann als einzelne Anfragen. (Konsultieren Sie die LM Studio-Dokumentation für spezifische Modellfunktionen).

- Überwachung der Ressourcen: Achten Sie auf die Auslastung Ihrer Systemressourcen, während der Server läuft. Passen Sie die LM Studio-Einstellungen an oder wählen Sie ein kleineres Modell, wenn es Ihren Rechner belastet.

Zusätzliche Ressourcen:

- LM Studio Dokumentation bietet detaillierte Informationen zu den verfügbaren Modellen, Konfigurationsoptionen und Tipps zur Fehlerbehebung.

Wie man LM Studio für Aufgaben der natürlichen Sprachverarbeitung verwendet

Entfesseln Sie die Leistung von LM Studio für Aufgaben der natürlichen Sprachverarbeitung

Entdecken Sie, wie LM Studio für verschiedene Aufgaben der natürlichen Sprachverarbeitung eingesetzt werden kann, von der Erstellung von Inhalten bis zur Datenanalyse.

LM Studio glänzt bei der Bewältigung verschiedener NLP-Aufgaben (Natural Language Processing) und bietet Ihnen KI-Unterstützung, ohne den Datenschutz zu gefährden. Hier erfahren Sie, wie Sie seine Fähigkeiten nutzen können:

1. Textgenerierung:

- Entwerfen Sie überzeugende Marketingtexte, Produktbeschreibungen oder Beiträge für soziale Medien, indem Sie LM Studio Vorschläge oder Skizzen zur Verfügung stellen, die es dann ausarbeiten kann.

- Brainstorming von kreativen Inhaltsideen, indem Sie das Modell mit Anfangszeilen füttern und es Variationen generieren lassen.

- Erzeugen Sie verschiedene Schreibstile, indem Sie Ihre Aufforderungen anpassen und mit verschiedenen LLMs experimentieren.

2. Text-Zusammenfassung:

- Wenn Sie LM Studio längere Artikel oder Forschungsarbeiten zur Verfügung stellen, kann es kurze Zusammenfassungen erstellen und Ihnen so wertvolle Lesezeit sparen.

- Fassen Sie Kundenrezensionen oder Feedbackberichte zusammen, um die wichtigsten Punkte schnell zu erfassen und Trends zu erkennen.

3. Maschinelle Übersetzung:

- Übersetzen Sie Texte von einer Sprache in eine andere mit den übersetzungsorientierten LLMs von LM Studio. Auch wenn einige von ihnen nicht mit speziellen Übersetzungsdiensten mithalten können, so sind sie doch ein praktisches Hilfsmittel für grundlegende Anforderungen.

4. Text Klassifizierung:

- Trainieren Sie ein LLM, um Ihre Daten nach bestimmten Kriterien zu kategorisieren. Klassifizieren Sie z. B. E-Mails des Kundensupports nach Problemtyp oder Stimmung.

- Diese Funktion kann bei der Organisation großer Datensätze oder bei der Automatisierung grundlegender Filterungsaufgaben hilfreich sein.

5. Textual Entailment:

- Bestimmen Sie, ob eine bestimmte Aussage logisch aus einer anderen folgt, indem Sie die Argumentationsfähigkeiten von LM Studio nutzen.

- Dies kann für Aufgaben wie die Analyse von Rechtsdokumenten oder das Aufspüren von Unstimmigkeiten im Text nützlich sein.

6. Beantwortung von Fragen:

- Trainieren Sie ein LLM auf einer spezifischen Wissensbasis und verwenden Sie es, um Ihre Fragen in einem natürlichsprachlichen Format zu beantworten.

- Dies kann bei der Erstellung interner FAQs oder Chatbots für den Kundendienst hilfreich sein, indem die Leistungsfähigkeit von LLMs wie ChatGPT genutzt wird.

Verwendung von LM Studio für NLP-Aufgaben:

- Wählen Sie den richtigen LLM: Wählen Sie ein LLM, das speziell für die NLP-Aufgabe (Natural Language Processing), die Sie durchführen möchten, trainiert wurde. In der Dokumentation werden oft die Stärken des Modells angegeben.

- Wirksame Aufforderungen formulieren: Geben Sie klare und prägnante Anweisungen, die den LLM zum gewünschten Ergebnis führen, ähnlich wie bei der Interaktion mit ChatGPT. Je besser die Eingabeaufforderungen sind, desto genauer sind die Ergebnisse.

- Experimentieren und iterieren: Scheuen Sie sich nicht, mit verschiedenen Eingabeaufforderungen und LLM-Einstellungen zu experimentieren. Es ist ein iterativer Prozess, um optimale Ergebnisse zu erzielen, der oft Anpassungen in der Benutzeroberfläche erfordert, um das Verhalten der App fein abzustimmen.

- Verfeinern und Nachbearbeiten: Der LLM-Output könnte für bestimmte Aufgaben einen gewissen Feinschliff oder menschliche Aufsicht erfordern. Berücksichtigen Sie die Überprüfung und Bearbeitung für die Genauigkeit, insbesondere für kritische Aufgaben.

Erinnern Sie sich:

- LM Studio bietet zwar beeindruckende NLP-Funktionen, befindet sich aber noch in der Entwicklung. Die Ergebnisse können je nach Komplexität der Aufgabe und des gewählten Modells variieren.

Erweiterte Funktionen von LM Studio: Verbessern Sie Ihr lokales LLM-Erlebnis

Erweiterte Einstellungen und Optionen in LM Studio erforschen

LM Studio bietet erweiterte Einstellungen und Optionen, um Ihr lokales LLM-Erlebnis zu verbessern, einschließlich:

- Quantisierungs- und Optimierungstechniken: Diese Techniken können die Antwortzeiten verbessern und den Ressourcenverbrauch verringern.

- Integration mit anderen Anwendungen und APIs: LM Studio kann in verschiedene Anwendungen und APIs integriert werden, um eine nahtlose Nutzung zu ermöglichen.

LM Studio: Kompatibilität, Unterstützung und Gemeinschaft

Sicherstellung der Kompatibilität: LM Studio Unterstützung für Windows, Mac, Linux und verschiedene GPUs

LM Studio ist mit verschiedenen Betriebssystemen und GPUs kompatibel, so dass es von einer Vielzahl von Benutzern verwendet werden kann.

Hilfe erhalten: Nutzung der LM Studio Community und der Support-Kanäle

Wenn Sie Hilfe mit LM Studio benötigen, finden Sie in der Community oder in den Support-Kanälen hilfreiche Ressourcen und Antworten auf Ihre Fragen.

Mitwirkung am LM Studio Projekt: Open-Source-Entwicklung

Wenn Sie daran interessiert sind, einen Beitrag zur LM Studio-Projekterkunden Sie die Möglichkeiten der Open-Source-Entwicklung und schließen Sie sich der Gemeinschaft der Entwickler an.

Häufig gestellte Fragen (FAQs)

Was sind die Anforderungen für LM Studio, um lokal auf Mac und Windows zu laufen?

Um ein LLM lokal über die kostenlose und leistungsstarke LM Studio-App zu nutzen, muss Ihr Mac oder Windows-Computer bestimmte Anforderungen erfüllen. Für beide Betriebssysteme benötigt LM Studio mindestens 8 GB RAM, wobei 16 GB für eine optimale Leistung empfohlen werden. Unter Windows ist Windows 10 oder neuer erforderlich, und unter macOS sollten Sie macOS 10.14 (Mojave) oder neuer verwenden. Weitere Anforderungen sind etwa 400 MB Speicherplatz, um die App und ausgewählte lokale Modelle unterzubringen, und für fortgeschrittene Anwendungsfälle wird ein kompatibler Grafikprozessor für die GPU-Beschleunigung empfohlen.

Wie kann ich LM Studio herunterladen und auf meinem Computer installieren?

Das Herunterladen und Installieren von LM Studio ist ganz einfach. Beginnen Sie mit Schritt 1, indem Sie die offizielle LM Studio-Website oder ein vertrauenswürdiges Repository wie GitHub oder HuggingFace besuchen, um die App für Ihr Betriebssystem (macOS oder Windows) herunterzuladen. Für Schritt 2 suchen Sie die heruntergeladene Datei in Ihrem Download-Ordner und doppelklicken Sie darauf, um den Installationsprozess zu starten. Folgen Sie den Anweisungen auf dem Bildschirm für Schritt 3, in dem Sie den Nutzungsbedingungen zustimmen und einen Installationsort auswählen müssen. Sobald die Installation abgeschlossen ist, können Sie LM Studio über Ihre Anwendungsliste oder das Startmenü starten.

Wie wähle ich ein Modell aus, das ich in LM Studio zur lokalen Verwendung herunterladen möchte?

Um ein Modell für die Verwendung in LM Studio herunterzuladen, starten Sie die App und stellen Sie eine Verbindung zum Internet her. Navigieren Sie zum Abschnitt "Modelle", wo Sie eine Liste der verfügbaren LLMs wie Mistral, Ollama und Mixtral sehen. Überlegen Sie, ob Sie ein Modell suchen, das für das Sprachverstehen (Mistral), die Erstellung kreativer Inhalte (Ollama) oder für individuelle Aufgaben (Mixtral) optimiert ist. Bewegen Sie den Mauszeiger über das von Ihnen gewählte Modell, um weitere Details zu sehen, und klicken Sie auf "Herunterladen", um zu beginnen. Beachten Sie, dass das Herunterladen der Modelle je nach Größe und Internetgeschwindigkeit eine Weile dauern kann.

Wie starte ich eine Chatsitzung mit meinem heruntergeladenen LLM in LM Studio?

Nach dem erfolgreichen Herunterladen und Einrichten eines LLM lokal in LM Studio ist es einfach, eine Chatsitzung zu starten. Öffnen Sie LM Studio, und wählen Sie im Hauptmenü die Funktion "Chat". Wählen Sie dort das heruntergeladene Modell aus, das Sie für die Sitzung verwenden möchten. Sie werden zu einer Chat-Schnittstelle weitergeleitet, in die Sie Ihre Fragen oder Aufforderungen eingeben können. Drücken Sie die Eingabetaste oder klicken Sie auf "Senden", um Ihren Text zu übermitteln, und der LLM generiert eine Antwort auf der Grundlage der Eingabe und zeigt sie im Chatfenster an. Diese Funktion kann für verschiedene Interaktionen genutzt werden, von der Unterstützung beim Schreiben bis hin zum Code-Debugging.

Kann ich LM Studio für die lokale Erstellung von Transkripten verwenden?

Ja, LM Studio unterstützt die lokale Erstellung von Transkripten mit LLMs, die für Spracherkennungsaufgaben wie Mistral optimiert sind. Um ein Transkript zu erstellen, stellen Sie sicher, dass Sie ein geeignetes Modell für die Transkription heruntergeladen haben. Öffnen Sie die Anwendung und wählen Sie die Option "Transkription", dann wählen Sie Ihr Modell. Sie können Audiodateien direkt in LM Studio hochladen, und das ausgewählte LLM wird die Audiodaten verarbeiten und eine Texttranskription ausgeben. Dies kann besonders für Benutzer nützlich sein, die einen schnellen Offline-Zugang zu Transkriptionsdiensten für Meetings, Interviews oder die Erstellung von Inhalten benötigen.

Was ist Quantisierung in LM Studio, und wie verbessert sie die Leistung?

Die Quantisierung ist ein Prozess, der in LM Studio zur Optimierung der Modellleistung verwendet wird, indem die Genauigkeit der im Modell verwendeten Zahlen verringert wird. Diese Technik ermöglicht es der App, größere Modelle auf Geräten mit begrenzten Ressourcen auszuführen, indem die Gesamtgröße des Modells verringert und die Berechnung beschleunigt wird, was insbesondere für Geräte ohne spezielle GPU-Beschleunigung von Vorteil ist. Es schafft ein Gleichgewicht zwischen Leistung und Qualität und ermöglicht die Verwendung fortschrittlicher lokaler Modelle auf einer größeren Anzahl von Computern. Die Benutzer können die Quantisierung über das Einstellungsmenü in LM Studio aktivieren und den Grad der Quantisierung auswählen, der am besten zu ihrem Gleichgewicht zwischen Leistung und Genauigkeit passt.

Ist es möglich, lokale LLMs von LM Studio über API in externe Anwendungen zu integrieren?

Ja, LM Studio bietet API-Integration für die lokalen Modelle, die Sie eingerichtet haben, so dass Entwickler die Fähigkeiten ihrer externen Anwendungen oder Dienste erweitern können, indem sie die Leistung großer Sprachmodelle (LLMs) lokal nutzen. Diese Funktion unterstützt eine Vielzahl von Anwendungsfällen, von der Verbesserung von Chat-Anwendungen mit natürlicher Sprachverarbeitung bis hin zur Einbindung fortschrittlicher Textanalyse in Content-Management-Systeme. Um auf die API zuzugreifen, navigieren Sie zu den Einstellungen von LM Studio und aktivieren Sie die API-Nutzung. Sie erhalten einen API-Schlüssel und Endpunktinformationen, um den LLM in Ihre Anwendung zu integrieren.

Wie kann ich die beste Leistung bei der Verwendung der GPU-Beschleunigung in LM Studio sicherstellen?

Um die beste Leistung mit der GPU-Beschleunigung in LM Studio zu gewährleisten, sollten Sie zunächst überprüfen, ob die Hardware Ihres Computers einen kompatiblen Grafikprozessor mit ausreichenden Ressourcen enthält. Nvidia-GPUs werden für diese Aufgaben in der Regel unterstützt. Aktualisieren Sie anschließend Ihre GPU-Treiber auf die neueste Version, um Kompatibilität und optimale Leistung zu gewährleisten. Navigieren Sie in LM Studio zu den Einstellungen und stellen Sie sicher, dass die GPU-Beschleunigung aktiviert ist. Für bestimmte Aufgaben oder Modelle können Sie auch zusätzliche Einstellungen zur Leistungsoptimierung finden, wie z. B. die Anpassung der Speicherzuweisung für das Modell oder die Auswahl leistungsorientierter Quantisierungsoptionen. Die Überwachung der Leistung und der Temperatur des Grafikprozessors kann auch bei der Feinabstimmung der Einstellungen für einen dauerhaften Betrieb helfen.