Der ultimative Leitfaden für beliebte große Sprachmodelle

Stellen Sie sich vor, Sie haben Mühe, die perfekte Geschichte zu schreiben, Ihre Finger schweben über der Tastatur, während die leere Seite Sie verhöhnt. Plötzlich erinnern Sie sich an Ihre Geheimwaffe: ein großes Sprachmodell (LLM). Mit ein paar Eingaben webt das LLM eine Geschichte, die so fesselnd ist, dass sie sich wie Magie anfühlt. Dies ist nur ein Beispiel für die Leistungsfähigkeit von LLMs, hochentwickelten KI-Systemen, die die Art und Weise, wie wir mit Technologie interagieren, neu gestalten.

In der sich ständig verändernden und faszinierenden Welt der künstlichen Intelligenz (KI) haben große Sprachmodelle (LLMs) mit ihren beeindruckenden Fähigkeiten im Umgang mit menschlicher Sprache Wellen geschlagen. Aber was genau sind diese LLMs, und wie revolutionieren sie unsere täglichen Interaktionen und Aufgaben? Tauchen wir ein in diesen fesselnden Bereich und entdecken wir einige der prominentesten LLMs, die die Zukunft der KI gestalten.

Verstehen großer Sprachmodelle

LLMs sind fortschrittliche maschinelle Lernmodelle, die menschenähnlichen Text vorhersagen und generieren. Sie können Sätze automatisch vervollständigen, Sprachen übersetzen und sogar ganze Artikel verfassen. Diese Modelle haben sich von einfachen Wortprädiktoren zu komplexen Systemen entwickelt, die Absätze und Dokumente verarbeiten können.

Wie funktionieren große Sprachmodelle?

LLMs schätzen die Wahrscheinlichkeit von Wortfolgen und nutzen umfangreiche Datensätze, um Sprachmuster zu lernen. Sie basieren auf Architekturen wie Transformers, die sich auf die wichtigsten Teile der Eingabe konzentrieren, um längere Sequenzen effizient zu verarbeiten.

Die Entwicklung der LLMs: Vom BERT zum GPT-4

Das von Google 2018 eingeführte BERT war ein Durchbruch, da es den bidirektionalen Kontext nutzt, um die Nuancen der Sprache zu verstehen. GPT-4 mit seinen 178 Milliarden Parametern hat die Texterzeugung auf ein neues Niveau gehoben und die Fähigkeit gezeigt, menschenähnlichen Text zu erzeugen.

Beispiele für große Sprachmodelle in Aktion

ChatGPT, eine Variante der GPT-Modelle von OpenAI, ist zu einem bekannten Namen geworden, der Chatbots betreibt, die menschenähnliche Interaktionen bieten.

Die Auswirkungen des BERT auf Aufgaben der natürlichen Sprachverarbeitung

BERT hat die Leistung von Aufgaben zur Verarbeitung natürlicher Sprache, wie z. B. Stimmungsanalyse und Sprachübersetzung, erheblich verbessert.

GPT-3 und die Grenzen der Texterstellung

Die Fähigkeit von GPT-3, kreative und kohärente Texte zu erstellen, hat neue Möglichkeiten für die Erstellung von Inhalten und darüber hinaus eröffnet.

Ein Spickzettel für den Vergleich der heute bekannten großen Sprachmodelle

Um das Ausmaß und die Vielfalt großer Sprachmodelle besser zu verstehen, sollten wir uns einige der einflussreichsten öffentlich verfügbaren Modelle, die derzeit die Landschaft beherrschen, genauer ansehen. Jedes Modell hat seine eigenen Stärken und zeichnet sich in verschiedenen Anwendungsfällen aus.

Diese Tabelle bietet einen schnellen Überblick über einige der einflussreichsten großen Sprachmodelle im Jahr 2024. BERT, das von Google eingeführt wurde, ist für seine transformatorbasierte Architektur bekannt und war ein bedeutender Fortschritt bei der Verarbeitung natürlicher Sprache. ClaudeDas von Anthropic entwickelte Programm konzentriert sich auf konstitutionelle KI und zielt darauf ab, KI-Ergebnisse hilfreich, harmlos und genau zu machen. Cohere, ein LLM für Unternehmen, bietet maßgeschneiderte Schulungen und Feinabstimmungen für spezifische Unternehmensanwendungen. Ernie von Baidu verfügt über eine unglaubliche Anzahl von 10 Billionen Parametern und ist für Mandarin ausgelegt, kann aber auch in anderen Sprachen eingesetzt werden.

Lokale LLMs vs. Cloud LLMs

Während Cloud-basierte LLMs beeindruckende Fähigkeiten bieten, ist ein wachsender Trend die Verwendung lokaler Inferenz mit Open-Source-Modellen. Mit Tools wie LM Studio können Benutzer LLMs lokal ausführen direkt auf ihren Rechnern.

Bei diesem Ansatz steht der Datenschutz im Vordergrund, da alle Daten und die Verarbeitung offline bleiben. Lokale Schlussfolgerungen erfordern jedoch in der Regel leistungsfähigere Hardware und können den Zugang zu den modernsten Modellen aufgrund ihrer Größe einschränken.

Top 15 der beliebtesten Großsprachenmodelle

| Name des Modells | Größe (Parameter) | Open Source? | Letzte Aktualisierung (Schätzung) | Unternehmen | Land der Entwicklung |

| AI21 Studios Jurassic-1 Jumbo | 178B | Ja | Dezember 2022 | AI21 Studios | Israel |

| Google Gemma | 2B oder 7B | Ja | Mai 2023 | Google KI | Vereinigte Staaten |

| Meta LLaMA 13B | 13B | Ja | Anfang 2023 | Meta-KI | Vereinigte Staaten |

| Meta LLaMA 7B | 7B | Ja | Anfang 2023 | Meta-KI | Vereinigte Staaten |

| EleutherAI GPT-J | 6B | Ja | Mai 2023 (durch Abzweigungen wie Dolly 2) | EleutherAI (Forschungsgruppe) | Vereinigte Staaten |

| Der Stapel - EleutherAI | 900 GB Textdaten | Ja | Laufende Entwicklung | EleutherAI (Forschungsgruppe) | Vereinigte Staaten |

| Mistral AI - Mistral Groß | Nicht öffentlich bekannt gegeben (Large) | Open-Source mit kostenpflichtigen Optionen | September 2023 | Mistral AI | Frankreich |

| Falke 180B | 180B | Ja | Keine Angaben | Institut für technologische Innovation | UAE |

| BERT | 342 Millionen | Nein | Juli 2018 | Google KI | Vereinigte Staaten |

| Ernie | 10 Billionen | Nein | August 2023 | Baidu | China |

| OpenAI GPT-3.5 | 175B | Nein | Ende 2022 | OpenAI | Vereinigte Staaten |

| Claude | Keine Angaben | Nein | Keine Angaben | Anthropisch | Vereinigte Staaten |

| Cohere | Nicht öffentlich bekannt gegeben (Massiv) | Nein | Laufende Entwicklung | Cohere | Kanada |

| Google PaLM (Forschungsschwerpunkt) | Nicht öffentlich bekannt gegeben (wahrscheinlich sehr groß) | Nein | In Entwicklung | Google KI | Vereinigte Staaten |

| OpenAI GPT-4 | Nicht öffentlich bekannt gegeben (Nachfolger von GPT-3.5) | Nein | In Entwicklung | OpenAI | Vereinigte Staaten |

LLMs Entwicklungsländervergleich

Bei einem Vergleich der 15 größten Sprachmodelle (Large Language Models, LLM) entfallen auf die Vereinigten Staaten fast 67% des Marktanteils bei der Entwicklung von LLM in 10 von 15 Ländern.

| Land der Entwicklung | Anzahl der Modelle |

| Kanada | 1 |

| China | 1 |

| Frankreich | 1 |

| Israel | 1 |

| UAE | 1 |

| Vereinigte Staaten | 10 |

| Gesamtbetrag | 15 |

LLM-Architekturen und Ausbildungsmethoden

| Architektur/Methode | Beschreibung |

|---|---|

| Transformator | Eine neuronale Netzwerkarchitektur, die sich auf Aufmerksamkeitsmechanismen stützt, um die Effizienz und Genauigkeit der Verarbeitung sequentieller Daten zu verbessern. Sie ist die Grundlage vieler moderner LLMs. |

| Vor der Ausbildung | Die Anfangsphase des Trainings eines LLM, in der es einer großen Menge an unmarkierten Textdaten ausgesetzt wird, um die statistischen Muster und Strukturen der Sprache zu lernen. |

| Feinabstimmung | Verfeinerung eines vortrainierten Modells durch Training mit spezifischen Daten, die sich auf eine bestimmte Aufgabe beziehen, um seine Leistung für diese Aufgabe zu verbessern. |

| QLoRA | Eine Methode, bei der Gradienten durch ein eingefrorenes, 4-Bit-quantisiertes, vortrainiertes Sprachmodell in Low Rank Adapters (LoRA) zurückverfolgt werden, was eine effiziente Feinabstimmung ermöglicht. |

Die Transformer-Architektur hat den Bereich der Verarbeitung natürlicher Sprache revolutioniert, indem sie Modelle in die Lage versetzt, lange Datensequenzen effektiver zu verarbeiten. Pre-Training und Feinabstimmung sind kritische Phasen in der Entwicklung von LLMs, die es ihnen ermöglichen, aus großen Datenmengen zu lernen und sich dann auf bestimmte Aufgaben zu spezialisieren. QLoRA ist eine fortschrittliche Technik zur Feinabstimmung von LLMs, die den Speicherbedarf reduziert und gleichzeitig die Leistung aufrechterhält.

Wichtige Anwendungsfälle für große Sprachmodelle

Wie LLMs die Sprachübersetzung und Stimmungsanalyse revolutionieren

LLMs haben die Sprachübersetzung verändert, indem sie große Datenmengen verstehen und übersetzen, während die Stimmungsanalyse dank ihrer Deep-Learning-Fähigkeiten nuancierter geworden ist.

Verbesserung der Mensch-Maschine-Interaktion mit Chatbots

Chatbots, die von LLMs angetrieben werden, bieten personalisierten und effizienten Kundensupport und verändern das Gesicht des Kundendienstes.

Veränderung der Inhaltserstellung durch generative KI

Generative KI-Modelle wie GPT-3 ermöglichen die schnelle Erstellung hochwertiger Inhalte und unterstützen Autoren und Designer gleichermaßen.

Herausforderungen und Grenzen der Umsetzung von LLMs

Bedenken bezüglich Voreingenommenheit und ethischer Verwendung ansprechen

Die Trainingsdaten für LLMs können zu Verzerrungen führen, was ethische Bedenken aufwirft, die berücksichtigt werden müssen.

Verstehen der Rechenkosten für das Training großer Modelle

Die Ausbildung von LLMs erfordert erhebliche Rechenressourcen, was kostspielig und ökologisch nicht nachhaltig sein kann.

Die Grenzen des Sprachverständnisses und des Erfassens von Kontexten

Trotz ihrer Fähigkeiten haben LLMs immer noch Schwierigkeiten, den Kontext und die Feinheiten der menschlichen Sprache zu verstehen.

Wie große Sprachmodelle trainiert und feinabgestimmt werden

Die Bedeutung umfangreicher Datenmengen bei der Vorbereitung auf das LLM-Studium

LLMs benötigen große Datensätze, um ein breites Spektrum an Sprachmustern und -nuancen zu lernen.

Feinabstimmung von Techniken für spezifische Anwendungen

Techniken wie Transferlernen und Feinabstimmung mit Transformatormodellen werden eingesetzt, um LLMs an spezifische Aufgaben anzupassen.

Entstehung von Grundmodellen im maschinellen Lernen

Basismodelle sind ein neuer Trend im Bereich des maschinellen Lernens und bilden die Grundlage für den Aufbau spezialisierter Modelle.

Unterschiede zwischen Vortraining und aufgabenspezifischem Training

Pre-Training und aufgabenspezifisches Training (oft als Feinabstimmung bezeichnet) sind zwei kritische Phasen bei der Entwicklung von großen Sprachmodellen (LLMs). Diese Phasen sind grundlegend dafür, wie LLMs menschenähnlichen Text verstehen und generieren, und dienen jeweils einem bestimmten Zweck im Lernprozess des Modells.

LLM-Vorbereitungskurse

Pre-Training ist die anfängliche, umfangreiche Phase, in der ein LLM aus einem großen Korpus von Textdaten lernt. In dieser Phase erhält das Modell eine umfassende Ausbildung in den Bereichen Sprache, Kultur und Allgemeinwissen. Hier sind die wichtigsten Aspekte des Pre-Trainings:

- Allgemeine Wissensbasis: Das Modell entwickelt ein Verständnis von Grammatik, Redewendungen, Fakten und Kontext durch die Analyse eines großen Textkorpus. Diese breite Wissensbasis ermöglicht es dem Modell, kohärente und kontextgerechte Antworten zu geben.

- Lernen übertragen: Vorgefertigte Modelle können ihre gelernten Sprachmuster auf neue Datensätze anwenden, was besonders bei Aufgaben mit begrenzten Daten nützlich ist. Diese Fähigkeit reduziert den Bedarf an umfangreichen aufgabenspezifischen Daten erheblich.

- Kosten-Wirksamkeit: Trotz der beträchtlichen Rechenressourcen, die für das Vortraining erforderlich sind, kann dasselbe Modell für verschiedene Anwendungen wiederverwendet werden, was es zu einem kosteneffizienten Ansatz macht.

- Flexibilität und Skalierbarkeit: Dank des umfassenden Verständnisses, das beim Vortraining gewonnen wird, kann ein und dasselbe Modell für verschiedene Aufgaben angepasst werden. Wenn neue Daten zur Verfügung stehen, können die vortrainierten Modelle weiter trainiert werden, um ihre Leistung zu verbessern.

Aufgabenspezifisches Training (Fine-Tuning)

Nach dem Vortraining werden die Modelle einer Feinabstimmung unterzogen, bei der sie auf kleineren, aufgabenspezifischen Datensätzen trainiert werden. In dieser Phase wird das breite Wissen des Modells so angepasst, dass es bei bestimmten Aufgaben gut funktioniert. Zu den wichtigsten Aspekten der Feinabstimmung gehören:

- Aufgaben-Spezialisierung: Durch die Feinabstimmung werden die vorab trainierten Modelle an bestimmte Aufgaben oder Branchen angepasst, um ihre Leistung bei bestimmten Anwendungen zu verbessern.

- Dateneffizienz und Geschwindigkeit: Da das Modell bereits während des Vortrainings allgemeine Sprachmuster gelernt hat, erfordert die Feinabstimmung weniger Daten und Zeit, um das Modell für bestimmte Aufgaben zu spezialisieren.

- Modell-Anpassung: Die Feinabstimmung ermöglicht die Anpassung des Modells an die besonderen Anforderungen verschiedener Aufgaben, wodurch es sich sehr gut an Nischenanwendungen anpassen lässt.

- Ressourceneffizienz: Die Feinabstimmung ist besonders vorteilhaft für Anwendungen mit begrenzten Rechenressourcen, da sie die schwere Arbeit, die während des Pre-Trainings geleistet wird, ausnutzt.

Zusammenfassend lässt sich sagen, dass das Vortraining LLMs mit einem breiten Verständnis von Sprache und allgemeinem Wissen ausstattet, während das Feintuning dieses Wissen so zuschneidet, dass es sich für spezifische Aufgaben eignet. Das Vortraining legt den Grundstein für die sprachlichen Fähigkeiten des Modells, und die Feinabstimmung optimiert diese Fähigkeiten für gezielte Anwendungen, wobei ein Gleichgewicht zwischen der Verallgemeinerung und der Spezialisierung des Modells hergestellt wird.

Die Zukunft der großen Sprachmodelle

Antizipation der nächsten Generation von LLMs: GPT-4 und darüber hinaus

Die nächste Generation von LLMs, wie GPT-4, soll die Grenzen des Machbaren in der KI noch weiter verschieben.

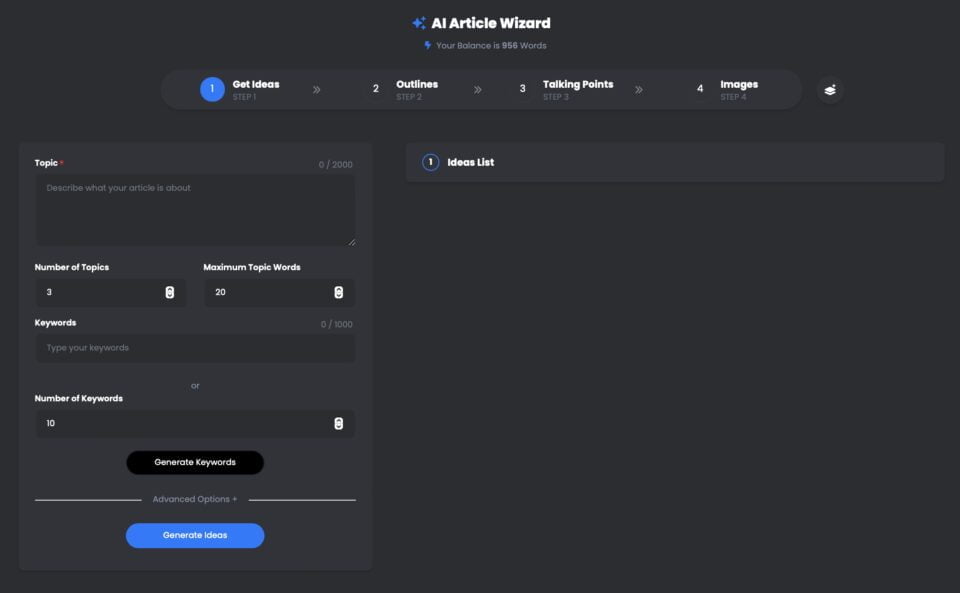

UberCreate AI Artikel-Assistent ist ein leistungsstarkes Tool, das das OpenAI GPT-4 Large Language Model (LLM) nutzt, um innerhalb von Minuten hochwertige Artikel zu erstellen.

Mit UberCreate können Sie sich in wenigen Minuten von Ihrer Schreibblockade verabschieden und einen ausführlichen Artikel schreiben. Sie müssen nur ein Thema, ein Stichwort und eine Zielwortzahl angeben, und UberCreate kümmert sich um den Rest. UberCreate erstellt eine Gliederung des Artikels, Stichpunkte, relevante Bilder und einen fertigen Artikel, der veröffentlicht werden kann.

UberCreate AI Artikel-Assistent mit GPT-4

Pin

Pin UberCreate nutzt fortschrittliche Technologie für künstliche Intelligenz, um originelle, ansprechende und informative Inhalte zu erstellen. UberCreate kann über jedes Thema schreiben, von Wirtschaft und Marketing bis hin zu Gesundheit und Lifestyle. UberCreate kann sich auch an verschiedene Töne, Stile und Formate anpassen, je nach Ihren Vorlieben und Bedürfnissen.

UberCreate ist nicht nur ein Inhaltsgenerator, sondern auch ein Inhaltsverbesserer. Es kann Ihnen helfen, Ihre bestehenden Artikel zu verbessern, indem Sie mehr Details, Fakten und Bilder hinzufügen. Es kann auch Ihre Grammatik, Rechtschreibung und Lesbarkeit überprüfen und Vorschläge zur Optimierung Ihrer Inhalte für SEO und soziale Medien machen.

UberCreate ist das einzige KI-Tool zur Erstellung von Inhalten, das Sie jemals brauchen werden. Es vereint 17 KI-Tools in einem, darunter einen Blogpost-Generator, einen Generator für Social-Media-Inhalte, einen Generator für visuelle Inhalte und mehr. Es wurde entwickelt, um jeden Aspekt der Inhaltserstellung zu erleichtern, von der Idee bis zur Produktion.

Egal, ob Sie Blogger, Vermarkter, Student oder Berufstätiger sind, UberCreate kann Ihnen helfen, Zeit, Geld und Mühe bei der Erstellung hochwertiger Inhalte zu sparen. Sie können es kostenlos ausprobieren und sich selbst von den Ergebnissen überzeugen.

Die Grenzen der Mensch-KI-Zusammenarbeit erweitern

LLMs sollen die Zusammenarbeit zwischen Menschen und KI verbessern und die Interaktionen natürlicher und produktiver machen.

Diese prominenten LLMs sind nur die Spitze des Eisbergs, wenn es darum geht, das enorme Potenzial großer Sprachmodelle für die Revolutionierung unserer Interaktion mit der Technologie und die Erweiterung der Grenzen der Zusammenarbeit zwischen Mensch und KI zu verstehen. Bleiben Sie dran für Teil II dieser Serie, in dem wir tiefer in die Fähigkeiten großer Sprachmodelle, ihre Anwendungen in verschiedenen Branchen und die Herausforderungen, die mit ihrer Nutzung einhergehen, eintauchen werden.

Aussichten für das Verstehen natürlicher Sprache im kommenden Jahrzehnt

Die Zukunft für das Verstehen natürlicher Sprache sieht rosig aus, denn LLMs werden immer ausgefeilter und in verschiedene Anwendungen integriert.

AbschließendLLMs wie BERT, GPT-3 und ihre Nachfolger revolutionieren Branchen von der Bildung bis zum Gesundheitswesen. Während wir ihre Leistungsfähigkeit weiter ausschöpfen, müssen wir auch die Herausforderungen meistern, die sie mit sich bringen, und ihre ethische und verantwortungsvolle Nutzung sicherstellen. Die Reise in die Welt der großen Sprachmodelle hat gerade erst begonnen, und die Möglichkeiten sind so groß wie die Datensätze, aus denen sie lernen. Tauchen Sie ein in dieses spannende Feld und lassen Sie uns gemeinsam die Zukunft der KI gestalten.

Häufig gestellte Fragen (FAQs)

Was ist ein Large Language Model (LLM) im Kontext von NLP?

Ein Large Language Model (LLM) bezeichnet im Rahmen der natürlichen Sprachverarbeitung (Natural Language Processing, NLP) ein fortschrittliches KI-System, das darauf ausgelegt ist, menschenähnlichen Text zu verstehen, zu interpretieren und zu erzeugen. Diese Modelle werden anhand großer Datenmengen trainiert, so dass sie eine breite Palette von Sprachaufgaben durchführen können. Durch den Trainingsprozess lernt das Modell, das nächste Wort in einem Satz vorherzusagen, was ihm hilft, bei Bedarf kohärente und kontextbezogene Texte zu erstellen.

Welche verschiedenen Arten von LLM-Studiengängen werden 2024 angeboten?

Ab 2024 gibt es verschiedene Arten von Large Language Models, die jeweils über einzigartige Fähigkeiten verfügen. Zu den bekanntesten gehören Modelle wie GPT-4, das für seine generativen Textfähigkeiten bekannt ist, und Bard, das Gegenstück von Google, das sich auf eine breite Palette von NLP-Aufgaben konzentriert. Diese Modelle unterscheiden sich durch die Anzahl der Parameter, die Daten, auf denen sie trainiert wurden, und ihre spezifischen Anwendungen, die von einfacher Texterzeugung bis hin zu komplexen Sprachverstehensaufgaben reichen.

Wie werden LLMs auf großen Datensätzen trainiert?

LLMs werden anhand großer Datensätze trainiert, die im Internet gesammelt wurden, darunter Bücher, Artikel und Websites. Bei diesem umfangreichen Trainingsprozess wird das Modell mit großen Mengen an Textdaten gefüttert, wodurch es Muster erkennen, den Kontext verstehen und Sprachstrukturen lernen kann. Der Trainingsprozess kann Wochen oder sogar Monate dauern, je nach Größe des Modells und den verfügbaren Rechenressourcen. Ziel ist es, das Modell in die Lage zu versetzen, Texte zu generieren, die nicht mehr von denen zu unterscheiden sind, die von Menschen geschrieben wurden.

Können Sie die Anwendungen von LLMs bei alltäglichen Aufgaben erklären?

LLMs können in einer Vielzahl von Anwendungen eingesetzt werden, um alltägliche Aufgaben zu vereinfachen und zu automatisieren. Dazu gehören Chatbots und virtuelle Assistenten für den Kundendienst, Tools zur Erstellung von Inhalten, um Artikel oder Berichte zu generieren, und Übersetzungsdienste für die Umwandlung von Text zwischen Sprachen. Andere Anwendungen umfassen Stimmungsanalysen, um die öffentliche Meinung in sozialen Medien zu ermitteln, Zusammenfassungs-Tools, um lange Dokumente zu kürzeren Versionen zusammenzufassen, und sogar Programmierassistenten, die Programmierern durch die Erstellung von Code-Schnipseln helfen. Im Wesentlichen haben LLMs die Art und Weise, wie wir mit Technologie interagieren, revolutioniert und sie intuitiver und menschenähnlicher gemacht.

Wie unterscheiden sich die Fähigkeiten großer Sprachmodelle von herkömmlichen Modellen?

Große Sprachmodelle sind herkömmlichen Modellen in mehrfacher Hinsicht deutlich überlegen. Erstens können LLMs aufgrund ihres umfangreichen Trainings auf verschiedenen Datensätzen kohärentere, vielfältigere und kontextuell angemessenere Antworten erzeugen. Sie sind besser in der Lage, Nuancen in der Sprache zu verstehen und können sequenzielle Daten effizienter verarbeiten. Darüber hinaus ermöglicht die schiere Anzahl von Parametern in LLMs ausgefeiltere Schlussfolgerungen und Vorhersagefähigkeiten im Vergleich zu traditionellen Modellen, die in ihrem Umfang und ihrer Skalierbarkeit eher begrenzt waren. Letztendlich bieten LLMs einen nuancierteren und vielseitigeren Ansatz zur Verarbeitung und Erzeugung von Sprache.

Welche Herausforderungen sind mit der Entwicklung und dem Einsatz von LLMs verbunden?

Die Entwicklung und der Einsatz von LLMs sind mit mehreren Herausforderungen verbunden, darunter die für das Training erforderlichen Rechenressourcen, die erheblich sein können. Darüber hinaus gibt es Bedenken hinsichtlich der Verzerrung der Trainingsdaten, die dazu führen können, dass das Modell voreingenommene oder schädliche Inhalte erzeugt. Probleme mit dem Datenschutz ergeben sich auch aus der Sensibilität der für das Training verwendeten Daten. Darüber hinaus stellt die Interpretierbarkeit dieser Modelle eine Herausforderung dar, da ihr Entscheidungsprozess komplex und nicht immer transparent ist. Und schließlich geben die Umweltauswirkungen des energieintensiven Trainingsprozesses zunehmend Anlass zur Sorge.

Wie wirken sich Sprachmodelle wie GPT-4 und Bard auf den Bereich des NLP aus?

Modelle wie GPT-4 und Bard haben den Bereich der Verarbeitung natürlicher Sprache erheblich vorangebracht, indem sie bei einer Vielzahl von NLP-Aufgaben eine beispiellose Leistung gezeigt haben. Ihre Fähigkeit, Text zu generieren, Kontext zu verstehen und menschenähnliche Antworten zu geben, hat neue Maßstäbe dafür gesetzt, was KI beim Verstehen und Produzieren von Sprache leisten kann. Diese Modelle haben nicht nur die Qualität und Effizienz von Anwendungen wie Chatbots, Inhaltserstellung und Sprachübersetzung verbessert, sondern auch neue Wege für die Forschung und Entwicklung im Bereich NLP eröffnet und die Grenzen der KI-Fähigkeiten verschoben.

Gibt es einen Leitfaden für Anfänger, um LLMs zu verstehen und mit ihnen zu arbeiten?

Ja, für diejenigen, die neu auf dem Gebiet sind, kann ein Leitfaden für Einsteiger in große Sprachmodelle unglaublich hilfreich sein. Ein solcher Leitfaden deckt in der Regel die Grundlagen dessen ab, was LLMs sind, wie sie trainiert werden und welche Anwendungen es gibt. Er kann Einblicke in die wichtigsten Modelle im Jahr 2023 bieten, die zugrunde liegende Technologie erklären und Beispiele für NLP-Aufgaben liefern, die mit LLMs durchgeführt werden können. Einsteiger können nach Online-Ressourcen, Tutorials und Kursen suchen, die eine Einführung in diese Konzepte bieten und dabei helfen, ein grundlegendes Verständnis dafür zu entwickeln, wie LLMs funktionieren und wie sie in verschiedenen Projekten eingesetzt werden können.