Generatory obrazów Stable Diffusion i DALL-E AI w UberCreate

Generowanie obrazu AI to proces tworzenia realistyczne obrazy z tekstu, szkice lub inne dane wejściowe wykorzystujące modele sztucznej inteligencji (AI). Generatory obrazów AI mają wiele zastosowań, od sztuki cyfrowej po marketing, i mogą ulepszyć opowiadanie historii, projektowanie stron internetowych i projekty multimedialne. Jednak nie wszystkie generatory obrazów AI są sobie równe.

W tym artykule przyjrzymy się dwóm najbardziej zaawansowanym i innowacyjnym modelom generowania obrazów AI: Stabilna dyfuzja I DALL-E. Porównamy ich możliwości, funkcje i technologie i pokażemy, jak mogą uwolnić Twoją kreatywność dzięki mocy szybkiej inżynierii.

Omówimy także krajobraz open source, względy etyczne i przyszłe trendy w technologii generowania obrazów AI.

Zarówno Stable Diffusion, jak i DALL-E stoją na czele cyfrowego renesansu, zmieniając sposób, w jaki postrzegamy i tworzymy sztukę. Te generatywne modele sztucznej inteligencji zdemokratyzowały ekspresję artystyczną, umożliwiając każdemu posiadaczowi komputera generowanie oszałamiających efektów wizualnych za pomocą prostych podpowiedzi tekstowych. Ta zmiana nie tylko poszerza zestaw narzędzi artystów cyfrowych, ale także zachęca osoby z różnych środowisk do odkrywania swojej kreatywności bez potrzeby posiadania tradycyjnych umiejętności artystycznych.

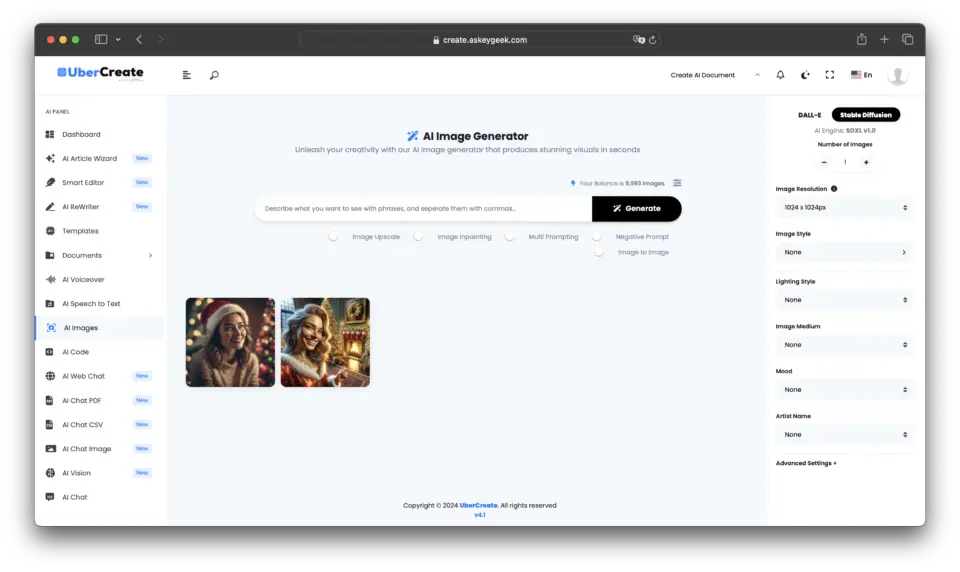

Na koniec będziemy eksplorować UberCreate, narzędzie AI typu „wszystko w jednym”, które łączy DALL-E i Stable Difussuion w jedno i jakie korzyści z tego płyną.

Co wyróżnia Stable Diffusion i DALL-E w interesie generowania obrazu AI?

Stable Diffusion i DALL-E to dwa z najnowszych i imponujących modeli generowania obrazu AI, wydanych przez Stabilność AI I OpenAI odpowiednio. Obydwa modele wykorzystują a tekst na obraz podejście, co oznacza, że mogą generować obrazy na podstawie opisów w języku naturalnym. Różnią się jednak architekturą, metodami i wynikami.

- Stabilna dyfuzja 3 jest model dyfuzyjny, co oznacza, że generuje obrazy poprzez stopniowe udoskonalanie ich z losowego szumu. Używa A transformator dyfuzyjny nauczyć się odwrotnego procesu dodawania szumu do obrazu, a następnie zastosować go w odwrotnej kolejności, aby wygenerować nowy obraz na podstawie podpowiedzi tekstowej. Stable Diffusion może generować obrazy o wysokiej jakości do 256×256 pikseli rozmiaru i radzi sobie ze złożonymi i różnorodnymi podpowiedziami. Może również występować wmalarstwo, co oznacza, że może wypełnić brakujące części obrazu, korzystając z obrazu wejściowego i podpowiedzi tekstowej.

- DALL-E 3 jest modelu transformatoraco oznacza, że generuje obrazy poprzez kodowanie podpowiedzi tekstowej i dekodowanie jej w obraz. Używa A duży model językowy zwany GPT-3 jako koder tekstu, oraz a dekonwolucyjna sieć neuronowa jako dekoder obrazu. DALL-E może generować obrazy do 64×64 piksele rozmiaru i może generować wiele obrazów dla tego samego monitu. Może również występować strzał zerowy generowanie obrazu, co oznacza, że może generować obrazy dla podpowiedzi, których nigdy wcześniej nie widział.

Porównanie możliwości modelu generowania obrazu przy stabilnej dyfuzji w porównaniu z DALL-E

Stable Diffusion i DALL-E, choć mają wspólny cel, jakim jest konwersja tekstu na obrazy, znacznie różnią się pod względem podejścia i wyników. DALL-E, opracowany przez OpenAI, specjalizuje się w dokładnym podążaniu za monitami w celu generowania obrazów ściśle odpowiadających tekstowi wejściowemu, często o wysokim stopniu fotorealizmu i dokładności. Z drugiej strony Stable Diffusion, wspierana przez Stability AI, oferuje szerszą gamę stylów artystycznych i możliwość dostrajania obrazów poprzez malowanie i odmalowywanie, zapewniając bardziej elastyczne narzędzie do twórczych poszukiwań.

Odkrywanie unikalnych cech modelu każdej generacji

Integracja DALL-E z ChatGPT zwiększa jego możliwości szybkiego śledzenia, czyniąc go wyjątkowo przyjaznym dla użytkownika i skutecznym w generowaniu pożądanego obrazu za pierwszym razem. I odwrotnie, otwarty charakter Stable Diffusion i włączenie funkcji takich jak ControlNet pozwalają na głębszy poziom dostosowywania i eksperymentowania, zaspokajając potrzeby zarówno początkujących użytkowników, jak i doświadczonych artystów.

Stabilność AI vs OpenAI: technologia kryjąca się za magią

Sercem tych modeli są zaawansowane techniki uczenia maszynowego, przy czym obie wykorzystują odmiany architektury transformatora do przetwarzania i generowania złożonych obrazów na podstawie opisów tekstowych. Kluczowa różnica polega na ich dostępności i przeznaczeniu; DALL-E OpenAI jest częścią szerszego zestawu narzędzi AI dostępnych w ramach subskrypcji, podczas gdy sztuczna inteligencja stabilności kładzie nacisk na zaangażowanie społeczności i innowacyjność poprzez podejście typu open source.

Jakie są unikalne cechy stabilnej dyfuzji i DALL-E, które wyróżniają je w dziedzinie generowania obrazu AI?

Podczas gdy Stable Diffusion przoduje w zapewnianiu kontroli nad modyfikacją obrazu i przystępności cenowej, DALL-E wyróżnia się przyjaznym dla użytkownika interfejsem, stałą jakością obrazu i możliwościami przetwarzania języka naturalnego. Wybór między generatorami obrazów AI ostatecznie zależy od konkretnych preferencji użytkownika, celów i poziomu dostosowania wymaganego do zadań związanych z generowaniem obrazów.

Stabilna dyfuzja:

- Możliwości malowania: Umożliwia użytkownikom dostosowanie rozmiarów określonych elementów w generowanych obrazach lub ich wymianę, zapewniając większą kontrolę nad modyfikacją obrazu.

- Dostępność offline: W przeciwieństwie do innych generatorów obrazów AI, Stable Diffusion można pobrać i używać w trybie offline, zapewniając elastyczność użytkowania.

- Opłacalny: oferuje podstawowy plan już od $9 miesięcznie, co czyni go tańszą opcją w porównaniu do DALL-E.

– Wszechstronność i moc: znana ze swojej zdolności do tworzenia wysokiej jakości obrazów z naciskiem na kontrolę użytkownika i dostosowywanie.

DALL-E:

- Przyjazny dla użytkownika interfejs: wymaga nieco niższego poziomu wiedzy technicznej w porównaniu do wersji Stable Diffusion, co zwiększa dostępność dla użytkowników.

- Stała jakość obrazu: znana z ciągłego generowania odpowiednich obrazów o wysokiej jakości, zapewniających niezawodne wydruki.

- Możliwości przetwarzania języka naturalnego: Umożliwia użytkownikom konwersacyjną interakcję z modelem w celu udoskonalania podpowiedzi i generowania obrazów na podstawie wprowadzonego tekstu.

Ograniczenia stabilnej dyfuzji i DALL-E w generowaniu obrazu AI są następujące:

Chociaż oba modele oferują zaawansowane możliwości generowania obrazów AI, ograniczenia te uwydatniają obszary, w których konieczne są ulepszenia lub uwagi, aby poprawić komfort użytkownika i jakość wydruku. Wybierając generator obrazów AI do swoich projektów, użytkownicy powinni dokładnie ocenić te ograniczenia w oparciu o swoje konkretne potrzeby i preferencje.

Stabilna dyfuzja:

- Niespójność w jakości obrazu: Stabilne rozproszenie może czasami powodować błędy w jakości obrazu, co prowadzi do zmienności wyników.

- Wymagania dotyczące wiedzy technicznej: Chociaż rozwiązanie Stable Diffusion jest przyjazne dla użytkownika, może wymagać pewnego poziomu wiedzy technicznej w celu optymalnego wykorzystania, co może stanowić barierę dla początkujących.

- Ograniczenia rozdzielczości: model może stawić czoła wyzwaniom związanym z pogorszeniem się i dokładnością, gdy parametry użytkownika odbiegają od zamierzonej rozdzielczości 512 × 512, co wpływa na jakość tworzonych obrazów.

DALL-E:

- Ograniczona personalizacja: DALL-E może mieć ograniczenia w zakresie dostosowywania w porównaniu ze Stable Diffusion, potencjalnie ograniczając zdolność użytkowników do dostosowywania obrazów do określonych wymagań.

- Względy etyczne: Pomimo stałej jakości obrazu, DALL-E stoi przed wyzwaniami związanymi z potencjalnymi odchyleniami w generowanych obrazach i potrzebą odpowiedzialnego użytkowania w celu dostosowania się do praktyk etycznych.

- Złożona inżynieria podpowiedzi: użytkownicy mogą napotkać trudności w tworzeniu precyzyjnych podpowiedzi tekstowych, które dokładnie oddają pożądane obrazy, wpływając na jakość i trafność generowanych obrazów.

Rodzaje obrazów, które mogą generować Stable Diffusion i DALL-E, różnią się pod kilkoma względami:

Stable Diffusion błyszczy w renderowaniu różnych stylów, wspieraniu malowania i malowania oraz oferowaniu szerokich opcji dostosowywania, DALL-E wyróżnia się łatwością obsługi, skupieniem się na obrazach abstrakcyjnych i przypominających malarstwo oraz stałą, wysoką jakością wydruku. Wybór pomiędzy tymi modelami zależy od konkretnych wymagań, preferencji użytkownika i rodzaju obrazów, które ma generować.

Stabilna dyfuzja:

- Style renderowania: Stable Diffusion wyróżnia się renderowaniem różnych stylów, szczególnie realistycznych zdjęć, lepiej niż DALL-E po wyjęciu z pudełka.

- Inpainting i Outpainting: Stable Diffusion obsługuje zarówno inpainting (regenerowanie części obrazu, pozostawiając resztę bez zmian), jak i outpainting (rozszerzanie obrazu przy zachowaniu oryginalnej zawartości), dając użytkownikom większą kontrolę nad modyfikacją obrazu.

- Wszechstronność: użytkownicy mogą udoskonalić każdy aspekt obrazu, aż spełni ich standardy, dzięki czemu Stable Diffusion nadaje się do twórczości artystycznej i dostosowywania.

DALL-E:

- Obrazy abstrakcyjne i przypominające obrazy: DALL-E jest przeszkolony do tworzenia bardziej abstrakcyjnych lub malarskich obrazów, doskonale radząc sobie z skutecznym reagowaniem na mniej szczegółowe lub szersze podpowiedzi.

- Łatwość obsługi: Znany z przyjaznego dla użytkownika interfejsu i możliwości przetwarzania języka naturalnego, DALL-E oferuje płynne generowanie obrazów w oparciu o proste i naturalne podpowiedzi.

- Stała jakość obrazu: DALL-E jest rozpoznawany za konsekwentne generowanie wysokiej jakości i odpowiednich obrazów, zapewniając użytkownikom niezawodne wydruki.

Mocne i słabe strony stabilnej dyfuzji i DALL-E dla określonych przypadków użycia

Stabilna dyfuzja:

Silne strony:

- Możliwości malowania: Umożliwia użytkownikom dostosowywanie określonych elementów obrazów lub ich zastępowanie, zapewniając kontrolę nad modyfikacjami.

- Dostępność offline: można pobrać i używać w trybie offline, co zapewnia elastyczność użytkowania.

- Wszechstronność: znana z renderowania różnych stylów, szczególnie realistycznych zdjęć, oraz obsługi malowania i przemalowywania, umożliwiając szerokie dostosowywanie.

Słabości:

- Niespójność w jakości obrazu: czasami może zapewniać zmienną jakość obrazu, co wpływa na niezawodność wydruku.

- Wymóg wiedzy technicznej: Chociaż jest przyjazny dla użytkownika, może wymagać pewnego poziomu wiedzy technicznej w celu optymalnego wykorzystania, co może stanowić barierę dla początkujących.

- Ograniczenia rozdzielczości: W przypadku odchyleń od zamierzonej rozdzielczości mogą pojawić się wyzwania, wpływające na jakość obrazu.

DALL-E:

Silne strony:

- Przyjazny dla użytkownika interfejs: wymaga mniejszej wiedzy technicznej w porównaniu do wersji Stable Diffusion, co zwiększa dostępność dla użytkowników.

- Stała jakość obrazu: znana z ciągłego generowania odpowiednich obrazów o wysokiej jakości, zapewniających niezawodne wydruki.

- Możliwości przetwarzania języka naturalnego: Doskonale radzi sobie z skutecznym reagowaniem na mniej szczegółowe lub szersze podpowiedzi, dzięki czemu szybkie prace inżynieryjne są mniej istotne.

Słabości:

- Ograniczona personalizacja: może mieć ograniczenia w dostosowywaniu w porównaniu do wersji Stable Diffusion, potencjalnie ograniczając zdolność użytkowników do dostosowywania obrazów do określonych wymagań.

- Względy etyczne: stawia czoła wyzwaniom związanym z potencjalnymi stronniczościami w generowanych obrazach i potrzebą odpowiedzialnego użytkowania w celu dostosowania się do praktyk etycznych.

- Złożona inżynieria podpowiedzi: użytkownicy mogą napotkać trudności w tworzeniu precyzyjnych podpowiedzi tekstowych, które dokładnie oddają pożądane obrazy, wpływając na jakość i trafność obrazu.

Stable Diffusion oferuje szerokie możliwości dostosowywania i wszechstronność stylów renderowania, DALL-E wyróżnia się łatwością obsługi i stałą, wysoką jakością wyników. Wybór pomiędzy tymi modelami zależy od konkretnych wymagań przypadku użycia, poziomu wiedzy użytkownika i pożądanego poziomu dostosowania do zadań związanych z generowaniem obrazu.

Konkretne przypadki użycia, w których stabilna dyfuzja przewyższa DALL-E:

- Możliwości malowania: Stable Diffusion doskonale sprawdza się w malowaniu, umożliwiając użytkownikom dostosowywanie określonych elementów obrazów lub ich zastępowanie, zapewniając większą kontrolę nad modyfikacją obrazu.

- Wszechstronność stylów renderowania: Stable Diffusion ma tę zaletę, że renderuje różne style, zwłaszcza realistyczne zdjęcia, przewyższając pod tym względem DALL-E.

- Dostępność offline: W przeciwieństwie do DALL-E, Stable Diffusion można pobrać i używać w trybie offline, oferując użytkownikom elastyczność i prywatność w zadaniach związanych z generowaniem obrazów.

- Dostosowywanie i kontrola: Stabilna dyfuzja pozwala użytkownikom udoskonalać każdy aspekt obrazu, aż spełni ich standardy, co czyni go idealnym do twórczości artystycznej i szczegółowej personalizacji w porównaniu do DALL-E.

- Opłacalność: Dzięki podstawowemu planowi rozpoczynającemu się od $9 miesięcznie, Stable Diffusion oferuje użytkownikom tańszą opcję w porównaniu do DALL-E, dzięki czemu jest dostępna dla szerszego grona osób.

Podsumowując, Stable Diffusion przewyższa DALL-E w określonych przypadkach użycia, takich jak możliwości malowania, wszechstronność stylów renderowania, dostępność offline, opcje dostosowywania i opłacalność. Użytkownicy poszukujący większej kontroli nad modyfikacjami obrazu, różnorodnymi stylami renderowania, użytkowaniem w trybie offline, szczegółowym dostosowywaniem i niedrogimi opcjami mogą uznać Stable Diffusion za bardziej odpowiedni do swoich potrzeb w zakresie generowania obrazu w porównaniu do DALL-E.

Niektóre specyficzne przypadki użycia, w których DALL-E przewyższa stabilną dyfuzję, obejmują:

- Przyjazny dla użytkownika: DALL-E wymaga mniejszej wiedzy technicznej w porównaniu do Stable Diffusion, dzięki czemu jest bardziej dostępny dla szerszego grona odbiorców.

- Stała jakość obrazu: DALL-E słynie z dostarczania wysokiej jakości i odpowiednich obrazów, zapewniając niezawodne wyniki.

- Możliwości przetwarzania języka naturalnego: DALL-E przoduje w skutecznym reagowaniu na mniej szczegółowe lub szersze podpowiedzi, dzięki czemu szybkie prace inżynieryjne są mniej istotne.

- Szybkość: DALL-E zazwyczaj generuje obrazy szybciej, często trzy do czterech razy szybciej niż Stable Diffusion w tych samych warunkach.

Należy jednak pamiętać, że Stable Diffusion oferuje korzyści w określonych przypadkach użycia, takie jak możliwości malowania, dostępność offline, opcje dostosowywania i opłacalność. Ostatecznie wybór pomiędzy DALL-E i Stable Diffusion zależy od konkretnych wymagań przypadku użycia, poziomu wiedzy użytkownika oraz pożądanych poziomów dostosowania i kontroli zadań związanych z generowaniem obrazu.

Jak wykorzystać moc szybkiej inżynierii do uzyskania oszałamiającej sztuki AI

Tworzenie skutecznych podpowiedzi tekstowych dla pożądanych obrazów

Sztuka szybkiej inżynierii polega na tworzeniu danych tekstowych, które kierują sztuczną inteligencją w celu uzyskania określonych efektów wizualnych. Wymaga to równowagi między konkretnością a kreatywnością, zapewniając, że podpowiedzi będą wystarczająco szczegółowe, aby przekazać pożądaną koncepcję, pozostawiając jednocześnie miejsce na możliwości interpretacyjne sztucznej inteligencji.

Zrozumienie znaczenia precyzyjnego języka w szybkim tworzeniu

Dobór słów w podpowiedzi może znacząco wpłynąć na wygenerowany obraz. Terminy opisujące nie tylko temat, ale także styl, nastrój i kontekst mogą prowadzić do dokładniejszych i atrakcyjniejszych wizualnie wyników.

Wskazówki i porady dotyczące optymalizacji wyjściowego obrazu dzięki szybkiej inżynierii

Eksperymentowanie jest kluczowe; iteracyjne udoskonalanie podpowiedzi w oparciu o poprzednie wyniki może pomóc w udoskonaleniu idealnej receptury. Dodatkowo wykorzystanie unikalnych cech każdego modelu, takich jak zdolność DALL-E do generowania wariacji lub malowanie Stable Diffusion, może jeszcze bardziej usprawnić proces twórczy.

Poruszanie się po krajobrazie Open Source: stabilna dyfuzja i jej wpływ

Znaczenie otwartego oprogramowania w przyspieszaniu innowacji w zakresie generatorów obrazów AI

Model open source Stable Diffusion sprzyja środowisku współpracy, w którym programiści i artyści mogą przyczyniać się do jego ewolucji, co prowadzi do szybkiego postępu i różnorodnej gamy wyspecjalizowanych modeli.

Jak rozpocząć korzystanie z modelu Open Source firmy Stable Diffusion

Dostęp do Stable Diffusion jest prosty, a dostępne są różne przewodniki i zasoby, które pomogą użytkownikom skonfigurować model do użytku osobistego lub zawodowego. Społeczność wokół Stable Diffusion zapewnia również szerokie wsparcie dla nowicjuszy.

Wkład społeczności i ulepszenia w zakresie stabilnego rozpowszechniania

Tętniąca życiem społeczność otaczająca Stable Diffusion doprowadziła do opracowania licznych wtyczek, modeli i narzędzi rozszerzających jego możliwości, umożliwiając bardziej zniuansowaną kontrolę nad procesem generowania obrazu i otwierając nowe możliwości kreatywności.

Odkrywanie granic kreatywności: przypadki użycia obrazów generowanych przez sztuczną inteligencję

Obrazy wygenerowane przez sztuczną inteligencję znalazły zastosowanie w wielu dziedzinach, od sztuki cyfrowej i marketingu po projektowanie stron internetowych i projekty multimedialne. Możliwość szybkiego generowania wizualizacji na podstawie podpowiedzi tekstowych rewolucjonizuje tworzenie treści, umożliwiając bardziej dynamiczne opowiadanie historii i innowacyjne rozwiązania projektowe.

Unikanie typowych pułapek: względy etyczne w generowaniu obrazu AI

W miarę jak generatory dzieł sztuki AI stają się coraz bardziej powszechne, rosną obawy dotyczące praw autorskich, kreatywności i możliwości niewłaściwego wykorzystania. Zarówno OpenAI, jak i Stability AI wdrożyły zabezpieczenia, aby rozwiązać te problemy, ale etyczne korzystanie z tych narzędzi pozostaje wspólną odpowiedzialnością użytkowników.

Przyszłość sztuki AI: prognozy i trendy w technologii generowania obrazu

Szybki rozwój generatorów obrazów AI sugeruje przyszłość, w której współpraca między ludzką kreatywnością a narzędziami AI stanie się jeszcze bardziej płynna. W oczekiwaniu na dalsze udoskonalenia w zakresie szybkiej interpretacji, jakości obrazu i zabezpieczeń etycznych granica między sztuką generowaną przez sztuczną inteligencję a sztuką tworzoną przez ludzi może w dalszym ciągu się zacierać, zwiastując nową erę kreatywności cyfrowej.

Podsumowując, Stable Diffusion i DALL-E reprezentują dwie wiodące krawędzie w dziedzinie generowania obrazów AI, każda ze swoimi mocnymi stronami i unikalnymi możliwościami. W miarę ewolucji tych technologii obiecują one dalszą demokratyzację twórczości artystycznej, czyniąc ją bardziej dostępną i wszechstronną niż kiedykolwiek wcześniej.

Integracja tego, co najlepsze z obu światów: UberCreate łączy Stable Diffusion i DALL-E

W stale zmieniającym się krajobrazie generowania obrazów AI pojawia się nowe narzędzie, które wykorzystuje połączoną moc dwóch najbardziej zaawansowanych modeli sztucznej inteligencji w branży: UberCreate. Ta innowacyjna platforma łączy w sobie możliwości zarówno Stable Diffusion, jak i DALL-E, oferując użytkownikom niezrównane doświadczenie w generowaniu obrazów z dowolnego opisu.

Moc połączonych generatorów obrazów AI w UberCreate

UberCreate jest świadectwem synergii, jaką można osiągnąć łącząc mocne strony różnych technologii AI. Integrując precyzję DALL-E z elastycznością Stable Diffusion, UberCreate zapewnia kompleksowe rozwiązanie dla każdego, kto chce szybko i wydajnie generować obrazy.

Pin

Pin Główne cechy i funkcjonalności UberCreate

UberCreate może poszczycić się intuicyjnym interfejsem, który upraszcza proces tworzenia wizualizacji, czyniąc go dostępnym dla użytkowników niezależnie od ich wiedzy technicznej. Dzięki możliwości generowania obrazów z dowolnego opisu, narzędzie zaspokaja szeroki zakres potrzeb twórczych, od profesjonalnych prac projektowych po osobiste projekty artystyczne.

Jedną z wyróżniających się funkcji UberCreate jest funkcja AI Vision Expert, która umożliwia użytkownikom przesłanie obrazu i otrzymanie szczegółowego zestawienia jego zawartości. Ta funkcja umożliwia identyfikację obiektów, osób i miejsc, a także dostrzeganie skomplikowanych szczegółów, dostarczając cennych informacji, które można wykorzystać do udoskonalenia procesu twórczego.

Korzyści z posiadania zarówno stabilnej dyfuzji, jak i DALL-E w jednym narzędziu

Posiadanie zarówno Stable Diffusion, jak i DALL-E w UberCreate oznacza, że użytkownicy mogą cieszyć się tym, co najlepsze z obu światów. Niezależnie od tego, czy wymagają wyrafinowanych stylów artystycznych oferowanych przez Stable Diffusion, czy też wysokiej jakości i szybkiego działania DALL-E, UberCreate bezproblemowo zaspokoi te potrzeby. Ta podwójna funkcja gwarantuje, że tworzone obrazy są nie tylko oszałamiające wizualnie, ale także ściśle dopasowane do wizji użytkownika.

Co więcej, połączenie tych modeli w jednym narzędziu znacznie skraca czas i wysiłek potrzebny do stworzenia wizualizacji. Użytkownicy mogą generować obrazy w ciągu kilku minut, czego tradycyjnie tworzenie ręczne lub przy użyciu oddzielnych narzędzi zajmowało wiele godzin. Ta wydajność jest nieoceniona dla profesjonalistów, którzy muszą dotrzymywać napiętych terminów bez utraty jakości.

Wniosek

UberCreate stanowi znaczący krok naprzód w generowaniu obrazów AI, zapewniając wszechstronne i potężne narzędzie, które wykorzystuje połączone zalety Stable Diffusion i DALL-E.

Przyjazny dla użytkownika interfejs i zaawansowane funkcje sprawiają, że jest to niezbędny atut dla artystów, projektantów i twórców, którzy chcą przesuwać granice sztuki cyfrowej i tworzenia treści.

Dzięki UberCreate możliwości są tak nieograniczone, jak wyobraźnia, umożliwiając użytkownikom łatwe i precyzyjne wprowadzanie w życie najbardziej ambitnych koncepcji wizualnych.

Często zadawane pytania (FAQ)

Jakie są kluczowe różnice między DALL-E i Stable Diffusion w narzędziu UberCreate?

Kluczowe różnice między DALL-E i Stable Diffusion w narzędziu UberCreate polegają na ich możliwościach modelowania tekstu na obraz i technikach osadzania obrazu. DALL-E doskonale radzi sobie z generowaniem fotorealistycznych obrazów z opisów w języku naturalnym dzięki wyrafinowanemu procesowi wnioskowania i ulepszonemu zbiorowi danych, co czyni go lepszym do precyzyjnego tworzenia obrazów opartych na podpisach. Z kolei Stable Diffusion wykorzystuje ukrytą dyfuzję i osadzanie obrazów klipów, oferując większą swobodę w procesie dyfuzji w celu tworzenia abstrakcyjnych lub stylizowanych obrazów bezpośrednio z tekstowo-warunkowych podpowiedzi obrazu.

W jaki sposób integracja DALL-E i Stable Diffusion poprawia sztukę generowaną przez sztuczną inteligencję w UberCreate?

Integrując zarówno DALL-E, jak i Stable Diffusion, UberCreate oferuje wszechstronną platformę dla grafiki generowanej przez sztuczną inteligencję. Ta kombinacja pozwala użytkownikom wykorzystać możliwości DALL-E do generowania fotorealistycznych obrazów w oparciu o szczegółowe opisy w języku naturalnym oraz zdolność Stable Diffusion do tworzenia unikalnych, stylizowanych dzieł sztuki poprzez ukryty proces rozpowszechniania. Dzięki temu niezależnie od złożoności obrazów, które chcesz wygenerować, UberCreate zapewni kompleksowe rozwiązanie.

Czy połączona platforma DALL-E i Stable Diffusion firmy UberCreate może zrozumieć złożone dane wejściowe w języku naturalnym na potrzeby generowania obrazu?

Tak, połączona platforma DALL-E i Stable Diffusion w UberCreate została zaprojektowana z myślą o zrozumieniu złożonych danych wejściowych w języku naturalnym. Zaawansowany model zamiany tekstu na obraz w DALL-E oraz inteligentne wykorzystanie osadzania klipów i zestawu danych w rozwiązaniu Stable Diffusion umożliwiają systemowi interpretację i konwertowanie skomplikowanych opisów na odpowiednie obrazy, ułatwiając płynne tłumaczenie podpisów na obraz.

Jakie ulepszenia oferuje Stable Diffusion w porównaniu z DALL-E 2 w UberCreate?

Stable Diffusion oferuje kilka ulepszeń w porównaniu z DALL-E 2 w UberCreate, w tym bardziej elastyczną kontrolę nad procesem generowania obrazu i lepszą jakość obrazu. Wykorzystując techniki stabilnej dyfuzji i ulepszone osadzanie obrazów, Stable Diffusion może generować bardziej abstrakcyjne i zróżnicowane stylistycznie obrazy niż model zamiany tekstu na obraz w DALL-E 2. Dodatkowo w wydaniu Stable Diffusion wprowadzono bardziej wydajny proces wnioskowania, co skutkowało krótszym czasem generowania i bardziej wyrafinowanymi obrazami.

Jak wykorzystać sztuczną inteligencję do płynnego łączenia obrazów wygenerowanych za pomocą DALL-E i Stable Diffusion w UberCreate?

Aby używać sztucznej inteligencji do płynnego łączenia obrazów wygenerowanych za pomocą DALL-E i Stable Diffusion w UberCreate, użytkownicy mogą skorzystać z funkcji malowania na platformie i jej możliwości w zakresie zbiorów danych. Określając, które aspekty grafiki generowanej przez sztuczną inteligencję powinny pochodzić z któregokolwiek modelu, narzędzie w inteligentny sposób wykorzystuje techniki osadzania obrazów i możliwości generowania obrazów warunkowych tekstowo obu modeli w celu naturalnego łączenia elementów. To mieszanie jest ułatwione dzięki zrozumieniu przez sztuczną inteligencję kontekstów obrazu i subtelnych niuansów szczegółów oryginalnego obrazu.

Jakie jest znaczenie osadzania obrazów klipów w połączeniu DALL-E i Stable Diffusion?

Osadzanie obrazów klipów odgrywa kluczową rolę w łączeniu DALL-E i Stable Diffusion, ponieważ umożliwia sztucznej inteligencji zrozumienie i interpretację treści i stylu obrazów na poziomie szczegółowym. Jest to niezbędne podczas łączenia obrazów wygenerowanych przez oba modele w UberCreate, ponieważ zapewnia spójne połączenie elementów z różnych obrazów. Osadzanie klipów obrazowych wykorzystuje wiedzę sztucznej inteligencji na temat zawartości obrazu, ułatwiając dokładniejszą i naturalną integrację wygenerowanych obrazów.

Czy funkcje DALL-E i Stable Diffusion aplikacji UberCreate mogą generować obrazy z tego samego podpowiedzi w języku naturalnym w inny sposób?

Tak, przy użyciu tego samego podpowiedzi w języku naturalnym, DALL-E i Stable Diffusion mogą generować wyraźnie różne obrazy ze względu na różne podejścia do generowania obrazu. DALL-E koncentruje się na tworzeniu precyzyjnych, fotorealistycznych obrazów, które ściśle odpowiadają danemu podpisowi, wykorzystując bogaty zbiór danych i zaawansowany model zamiany tekstu na obraz. I odwrotnie, Stable Diffusion może zinterpretować ten sam zachętę bardziej abstrakcyjnie lub stylistycznie, wykorzystując proces dyfuzji i techniki generowania ukrytego obrazu. Ta różnica pokazuje różnorodny potencjał twórczy wykorzystania sztucznej inteligencji w UberCreate.

W jaki sposób DALL-E i Stable Diffusion potrafią generować dokładne i szczegółowe obrazy na podstawie niejasnych podpowiedzi?

DALL-E i Stable Diffusion zostały zaprojektowane tak, aby wydobywać i wykorzystywać najbardziej istotne informacje z nawet najbardziej niejasnych podpowiedzi, dzięki zaawansowanym modelom sztucznej inteligencji i kompleksowym zbiorom danych. DALL-E wykorzystuje wyrafinowany model zamiany tekstu na obraz, który może wywnioskować szczegóły i kontekst, które mogą nie zostać wyraźnie wymienione w monicie. Stable Diffusion, poprzez swój ukryty proces rozpowszechniania i wykorzystanie osadzonych obrazów klipów, wypełnia luki, opierając się na obszernym szkoleniu na temat zróżnicowanej zawartości obrazu. Razem wykorzystują wnioskowanie, kreatywność i zrozumienie języka naturalnego, aby wygenerować szczegółowe obrazy zgodne z intencjami użytkownika.