Diffusion stable et générateurs d'images d'IA DALL-E dans UberCreate

La génération d'images d'IA est le processus de création des images réalistes à partir d'un texteLes générateurs d'images d'IA permettent de créer des images à partir de dessins, d'esquisses ou d'autres données à l'aide de modèles d'intelligence artificielle (IA). Les générateurs d'images à intelligence artificielle ont de nombreuses applications, de l'art numérique au marketing, et peuvent améliorer la narration, la conception de sites web et les projets multimédias. Cependant, tous les générateurs d'images d'IA ne se valent pas.

Dans cet article, nous allons explorer deux des modèles de génération d'images d'IA les plus avancés et les plus innovants : Diffusion stable et DALL-E. Nous comparerons leurs capacités, leurs caractéristiques et leurs technologies, et nous montrerons comment ils peuvent libérer votre créativité grâce à la puissance de l'ingénierie rapide.

Nous discuterons également du paysage open source, des considérations éthiques et des tendances futures de la technologie de génération d'images par l'IA.

Stable Diffusion et DALL-E sont tous deux à l'avant-garde d'une renaissance numérique, transformant la manière dont nous concevons et créons l'art. Ces modèles d'IA générative ont démocratisé l'expression artistique, permettant à toute personne disposant d'un ordinateur de générer des images époustouflantes à partir de simples invites textuelles. Cette évolution élargit non seulement la palette d'outils des artistes numériques, mais invite également des personnes de tous horizons à explorer leur créativité sans avoir besoin de compétences artistiques traditionnelles.

Enfin, nous explorerons UberCréerUn outil d'IA tout-en-un qui fusionne DALL-E et Stable Difussuion en un seul et comment vous en bénéficiez.

Qu'est-ce qui différencie Stable Diffusion et DALL-E dans l'intérêt de la génération d'images par l'IA ?

Stable Diffusion et DALL-E sont deux des modèles les plus récents et les plus impressionnants de génération d'images par l'IA, lancés par Stabilité AI et OpenAI respectivement. Les deux modèles utilisent un texte-image Ils sont donc capables de générer des images à partir de descriptions en langage naturel. Cependant, elles diffèrent dans leurs architectures, leurs méthodes et leurs résultats.

- Diffusion stable 3 est un modèle de diffusionCela signifie qu'il génère des images en les affinant progressivement à partir d'un bruit aléatoire. Il utilise un transformateur de diffusion pour apprendre le processus inverse d'ajout de bruit à une image, puis l'applique à l'inverse pour générer une nouvelle image à partir d'un texte. Stable Diffusion peut générer des images de haute qualité jusqu'à 256×256 pixels et peut traiter des messages complexes et variés. Il peut également effectuer peinturece qui signifie qu'il peut compléter les parties manquantes d'une image à partir d'une image d'entrée et d'une invite textuelle.

- DALL-E 3 est un modèle de transformateurCela signifie qu'il génère des images en codant l'invite de texte et en la décodant en une image. Il utilise un grand modèle linguistique appelé GPT-3 comme codeur de texte, et un réseau neuronal déconvolutionnel comme décodeur d'images. DALL-E peut générer des images jusqu'à 64×64 pixels et peut produire plusieurs images pour le même message. Il peut également effectuer des zéro-coup de feu la génération d'images, ce qui signifie qu'il peut générer des images pour des invites qu'il n'a jamais vues auparavant.

Comparaison des capacités du modèle de génération d'images de Stable Diffusion et de DALL-E

Stable Diffusion et DALL-E, tout en partageant l'objectif commun de convertir du texte en images, divergent considérablement dans leur approche et leur résultat. DALL-E, développé par OpenAI, excelle à suivre de près les instructions pour générer des images qui correspondent étroitement au texte saisi, souvent avec un degré élevé de photoréalisme et de précision. En revanche, Stable Diffusion, soutenu par Stability AI, offre un plus large éventail de styles artistiques et la possibilité d'affiner les images en les peignant et les dépeignant, ce qui en fait un outil plus souple pour l'exploration créative.

Explorer les caractéristiques uniques de chaque modèle de génération

L'intégration de DALL-E avec ChatGPT améliore ses capacités de suivi, ce qui le rend exceptionnellement convivial et efficace pour générer l'image souhaitée dès le premier essai. À l'inverse, la nature open-source de Stable Diffusion et l'inclusion de fonctionnalités telles que ControlNet permettent un niveau plus élevé de personnalisation et d'expérimentation, s'adressant à la fois aux utilisateurs novices et aux artistes expérimentés.

Stability AI vs OpenAI : la technologie derrière la magie

Au cœur de ces modèles se trouvent des techniques avancées d'apprentissage automatique, les deux modèles tirant parti de variations de l'architecture du transformateur pour traiter et générer des images complexes à partir de descriptions textuelles. La principale différence réside dans l'accessibilité et l'utilisation prévue : DALL-E d'OpenAI fait partie d'une suite plus large d'outils d'IA disponibles sur abonnement, tandis que Stability AI met l'accent sur l'implication de la communauté et l'innovation grâce à son approche open-source.

Quelles sont les caractéristiques uniques de la diffusion stable et de DALL-E qui les distinguent dans le domaine de la génération d'images aériennes ?

Alors que Stable Diffusion excelle dans le contrôle de la modification des images et dans son prix, DALL-E se distingue par son interface conviviale, sa qualité d'image constante et ses capacités de traitement du langage naturel. Le choix entre ces générateurs d'images d'IA dépend en fin de compte des préférences de l'utilisateur, de ses objectifs et du niveau de personnalisation requis pour les tâches de génération d'images.

Diffusion stable :

- Capacités d'inpainting : Permet aux utilisateurs d'ajuster la taille d'éléments spécifiques dans les images générées ou de les remplacer, offrant ainsi un plus grand contrôle sur la modification des images.

- Accessibilité hors ligne : Contrairement à d'autres générateurs d'images d'IA, Stable Diffusion peut être téléchargé et utilisé hors ligne, ce qui offre une grande souplesse d'utilisation.

- Rentable : Offre un plan de base à partir de $9 par mois, ce qui en fait une option plus abordable que DALL-E.

- Polyvalence et puissance : Reconnu pour sa capacité à créer des images de haute qualité, il met l'accent sur le contrôle et la personnalisation par l'utilisateur.

DALL-E :

- Interface conviviale : Nécessite un niveau d'expertise technique légèrement inférieur à celui de la diffusion stable, ce qui améliore l'accessibilité pour les utilisateurs.

- Une qualité d'image constante : Reconnu pour sa capacité à générer des images pertinentes et de haute qualité, ce qui garantit la fiabilité des résultats.

- Capacités de traitement du langage naturel : Permet aux utilisateurs d'interagir de manière conversationnelle avec le modèle afin d'affiner les messages-guides et de générer des images sur la base des entrées textuelles.

Les limites de la diffusion stable et de DALL-E dans la génération d'images d'IA sont les suivantes :

Bien que les deux modèles offrent des capacités avancées en matière de génération d'images d'IA, ces limitations mettent en évidence les domaines dans lesquels des améliorations ou des considérations sont nécessaires pour améliorer l'expérience de l'utilisateur et la qualité des résultats. Les utilisateurs doivent évaluer soigneusement ces contraintes en fonction de leurs besoins et préférences spécifiques lorsqu'ils choisissent un générateur d'images d'IA pour leurs projets.

Diffusion stable :

- Incohérence dans la qualité de l'image : La diffusion stable peut parfois s'avérer aléatoire en termes de qualité d'image, ce qui entraîne une variabilité des résultats.

- Expertise technique requise : Bien que conviviale, la diffusion stable peut nécessiter un certain niveau d'expertise technique pour une utilisation optimale, ce qui peut constituer un obstacle pour les débutants.

- Contraintes de résolution : Le modèle peut être confronté à des problèmes de détérioration et de précision lorsque les paramètres de l'utilisateur s'écartent de la résolution 512×512 prévue, ce qui affecte la qualité des images créées.

DALL-E :

- Personnalisation limitée : DALL-E peut présenter des limitations en termes de personnalisation par rapport à la diffusion stable, ce qui pourrait restreindre la capacité des utilisateurs à adapter les images à des besoins spécifiques.

- Considérations éthiques : Malgré sa qualité d'image constante, DALL-E est confronté à des défis liés aux biais potentiels dans les images générées et à la nécessité d'une utilisation responsable pour s'aligner sur les pratiques éthiques.

- Ingénierie des messages-guides complexes : Les utilisateurs peuvent éprouver des difficultés à rédiger des messages-guides textuels précis qui transmettent avec exactitude les images souhaitées, ce qui a une incidence sur la qualité et la pertinence des images générées.

Les types d'images que la diffusion stable et DALL-E peuvent générer diffèrent à plusieurs égards :

Stable Diffusion se distingue par le rendu de différents styles, la prise en charge de l'inpainting et de l'outpainting, ainsi que par des options de personnalisation étendues. DALL-E se distingue par sa facilité d'utilisation, sa focalisation sur les images abstraites et de type peinture, ainsi que par la qualité constante de ses résultats. Le choix entre ces modèles dépend des exigences spécifiques de l'utilisateur, de ses préférences et du type d'images qu'il souhaite générer.

Diffusion stable :

- Styles de rendu : Stable Diffusion excelle dans le rendu d'une variété de styles, en particulier les photos réalistes, mieux que DALL-E dès sa sortie de la boîte.

- Inpainting et Outpainting : Stable Diffusion prend en charge à la fois l'inpainting (régénération d'une partie de l'image tout en gardant le reste inchangé) et l'outpainting (extension de l'image tout en préservant le contenu original), ce qui permet aux utilisateurs de mieux contrôler la modification de l'image.

- Polyvalence : Les utilisateurs peuvent affiner chaque aspect de l'image jusqu'à ce qu'elle réponde à leurs critères, ce qui rend Stable Diffusion adapté à la création artistique et à la personnalisation.

DALL-E :

- Images abstraites et picturales : DALL-E est entraîné à produire des images plus abstraites ou proches de la peinture, excellant à répondre efficacement à des messages moins détaillés ou plus généraux.

- Facilité d'utilisation : Connu pour son interface conviviale et ses capacités de traitement du langage naturel, DALL-E offre une expérience transparente de génération d'images à partir d'invites simples et naturelles.

- Une qualité d'image constante : DALL-E est reconnu pour sa capacité à générer des images pertinentes et de haute qualité, garantissant ainsi une production fiable pour les utilisateurs.

Forces et faiblesses de la diffusion stable et de DALL-E pour des cas d'utilisation spécifiques

Diffusion stable :

Points forts :

- Capacités d'inpainting : Permet aux utilisateurs d'ajuster des éléments spécifiques dans les images ou de les remplacer, offrant ainsi un contrôle sur les modifications.

- Accessibilité hors ligne : Peut être téléchargé et utilisé hors ligne, ce qui offre une grande souplesse d'utilisation.

- Polyvalence : Réputé pour rendre différents styles, en particulier des photos réalistes, et pour prendre en charge l'inpainting et l'outpainting, ce qui permet une personnalisation poussée.

Faiblesses :

- Incohérence dans la qualité de l'image : La qualité de l'image peut parfois varier, ce qui a un impact sur la fiabilité des résultats.

- Expertise technique requise : Bien qu'il soit convivial, il peut nécessiter un certain niveau d'expertise technique pour une utilisation optimale, ce qui peut constituer un obstacle pour les débutants.

- Contraintes de résolution : Des problèmes peuvent survenir lorsqu'on s'écarte de la résolution prévue, ce qui affecte la qualité de l'image.

DALL-E :

Points forts :

- Interface conviviale : Nécessite moins d'expertise technique que la diffusion stable, ce qui améliore l'accessibilité pour les utilisateurs.

- Une qualité d'image constante : Reconnu pour sa capacité à générer des images pertinentes et de haute qualité, ce qui garantit la fiabilité des résultats.

- Capacités de traitement du langage naturel : Il excelle à répondre efficacement à des messages moins détaillés ou plus généraux, ce qui rend l'ingénierie des messages moins critique.

Faiblesses :

- Personnalisation limitée : La personnalisation peut être limitée par rapport à la diffusion stable, ce qui peut restreindre la capacité des utilisateurs à adapter les images à des besoins spécifiques.

- Considérations éthiques : Les défis sont liés aux biais potentiels des images générées et à la nécessité d'une utilisation responsable pour s'aligner sur les pratiques éthiques.

- Ingénierie des messages-guides complexes : Les utilisateurs peuvent éprouver des difficultés à rédiger des messages-guides textuels précis qui transmettent exactement l'imagerie souhaitée, ce qui a un impact sur la qualité et la pertinence de l'image.

Stable Diffusion offre des options de personnalisation étendues et une grande polyvalence dans les styles de rendu, DALL-E se distingue par sa facilité d'utilisation et la qualité constante de ses résultats. Le choix entre ces modèles dépend des exigences spécifiques du cas d'utilisation, du niveau d'expertise de l'utilisateur et du niveau de personnalisation souhaité pour les tâches de génération d'images.

Cas d'utilisation spécifiques dans lesquels la diffusion stable est plus performante que DALL-E :

- Capacités d'inpainting : Stable Diffusion excelle dans l'inpainting, permettant aux utilisateurs d'ajuster des éléments spécifiques dans les images ou de les remplacer, offrant ainsi un plus grand contrôle sur la modification de l'image.

- Polyvalence dans le rendu des styles : Stable Diffusion a un avantage dans le rendu de différents styles, en particulier les photos réalistes, surpassant DALL-E dans cet aspect.

- Accessibilité hors ligne : Contrairement à DALL-E, Stable Diffusion peut être téléchargé et utilisé hors ligne, offrant aux utilisateurs flexibilité et confidentialité dans les tâches de génération d'images.

- Personnalisation et contrôle : La diffusion stable permet aux utilisateurs d'affiner chaque aspect de l'image jusqu'à ce qu'elle réponde à leurs normes, ce qui la rend idéale pour la création artistique et la personnalisation détaillée par rapport à DALL-E.

- Rentabilité : Avec un plan de base à partir de $9 par mois, Stable Diffusion offre une option plus abordable pour les utilisateurs que DALL-E, ce qui la rend accessible à un plus grand nombre de personnes.

En résumé, Stable Diffusion surpasse DALL-E dans des cas d'utilisation spécifiques tels que les capacités d'inpainting, la polyvalence des styles de rendu, l'accessibilité hors ligne, les options de personnalisation et le rapport coût-efficacité. Les utilisateurs à la recherche d'un plus grand contrôle sur la modification des images, de divers styles de rendu, d'une utilisation hors ligne, d'une personnalisation détaillée et d'options économiques peuvent trouver que Stable Diffusion convient mieux que DALL-E à leurs besoins en matière de génération d'images.

Voici quelques cas d'utilisation spécifiques où DALL-E est plus performant que la diffusion stable :

- Convivialité : DALL-E requiert moins d'expertise technique que la diffusion stable, ce qui la rend plus accessible à un public plus large.

- Une qualité d'image constante : DALL-E est réputé pour la qualité et la pertinence de ses images, ce qui garantit des résultats fiables.

- Capacités de traitement du langage naturel : DALL-E excelle à répondre efficacement à des messages moins détaillés ou plus généraux, ce qui rend l'ingénierie des messages moins critique.

- Vitesse : DALL-E est généralement plus rapide pour produire des images, souvent trois à quatre fois plus rapide que la diffusion stable dans les mêmes conditions.

Cependant, il est important de noter que la diffusion stable offre des avantages dans des cas d'utilisation spécifiques, tels que les capacités d'inpainting, l'accessibilité hors ligne, les options de personnalisation et le rapport coût-efficacité. En fin de compte, le choix entre DALL-E et Stable Diffusion dépend des exigences spécifiques du cas d'utilisation, du niveau d'expertise de l'utilisateur et des niveaux souhaités de personnalisation et de contrôle pour les tâches de génération d'images.

Comment exploiter la puissance de l'ingénierie des messages-guides pour créer des œuvres d'art d'IA époustouflantes

Créer des textes d'incitation efficaces pour l'imagerie souhaitée

L'art de l'ingénierie de l'invite consiste à élaborer des entrées textuelles qui guident l'IA pour produire des résultats visuels spécifiques. Il faut pour cela trouver un équilibre entre spécificité et créativité, en veillant à ce que l'invite soit suffisamment détaillée pour transmettre le concept souhaité tout en laissant une marge de manœuvre pour les capacités d'interprétation de l'IA.

Comprendre l'importance d'un langage précis dans la rédaction d'un appel d'offres

Le choix des mots dans une invite peut influencer de manière significative l'image générée. Les termes qui décrivent non seulement le sujet, mais aussi le style, l'ambiance et le contexte peuvent donner des résultats plus précis et plus attrayants sur le plan visuel.

Conseils et astuces pour optimiser la production d'images grâce à Prompt Engineering

L'expérimentation est essentielle ; l'affinage itératif des messages-guides sur la base des résultats précédents peut aider à trouver la formulation parfaite. En outre, l'exploitation des caractéristiques uniques de chaque modèle, telles que la capacité de DALL-E à générer des variations ou l'inpainting de Stable Diffusion, peut encore améliorer le processus créatif.

Naviguer dans le paysage de l'Open Source : La diffusion stable et son impact

L'importance de l'Open-Source pour accélérer l'innovation en matière de générateurs d'images d'IA

Le modèle open-source de Stable Diffusion favorise un environnement collaboratif dans lequel les développeurs et les artistes peuvent contribuer à son évolution, ce qui permet des avancées rapides et un large éventail de modèles spécialisés.

Comment démarrer avec le modèle Open Source de Stable Diffusion

L'accès à Stable Diffusion est simple, avec divers guides et ressources disponibles pour aider les utilisateurs à mettre en place le modèle pour un usage personnel ou professionnel. La communauté qui entoure Stable Diffusion offre également un soutien important aux nouveaux arrivants.

Contributions communautaires et améliorations de la diffusion stable

La communauté dynamique qui entoure la diffusion stable a conduit au développement de nombreux plugins, modèles et outils qui étendent ses capacités, permettant un contrôle plus nuancé du processus de génération d'images et ouvrant de nouvelles voies à la créativité.

Explorer les limites de la créativité : Cas d'utilisation d'images générées par l'IA

Les images générées par l'IA ont trouvé des applications dans un large éventail de domaines, de l'art numérique et du marketing à la conception de sites web et aux projets multimédias. La possibilité de générer rapidement des images à partir d'un texte révolutionne la création de contenu, permettant une narration plus dynamique et des solutions de conception innovantes.

Éviter les pièges courants : Considérations éthiques sur la génération d'images par l'IA

À mesure que les générateurs d'art à base d'IA se répandent, les préoccupations relatives aux droits d'auteur, à la créativité et au risque d'utilisation abusive augmentent. OpenAI et Stability AI ont mis en place des garde-fous pour répondre à ces questions, mais l'utilisation éthique de ces outils reste une responsabilité partagée par les utilisateurs.

L'avenir de l'art de l'IA : Prédictions et tendances en matière de technologie de génération d'images

Les progrès rapides des générateurs d'images par IA laissent entrevoir un avenir où la collaboration entre la créativité humaine et les outils d'IA deviendra encore plus transparente. Si l'on prévoit de nouvelles améliorations en matière d'interprétation rapide, de qualité d'image et de garanties éthiques, la frontière entre l'art généré par l'IA et l'art créé par l'homme pourrait continuer à s'estomper, annonçant une nouvelle ère de créativité numérique.

En conclusion, la diffusion stable et DALL-E représentent les deux extrémités de la frontière de la génération d'images par l'IA, chacune avec ses forces et ses capacités uniques. À mesure que ces technologies évoluent, elles promettent de démocratiser davantage la création artistique, en la rendant plus accessible et plus polyvalente que jamais.

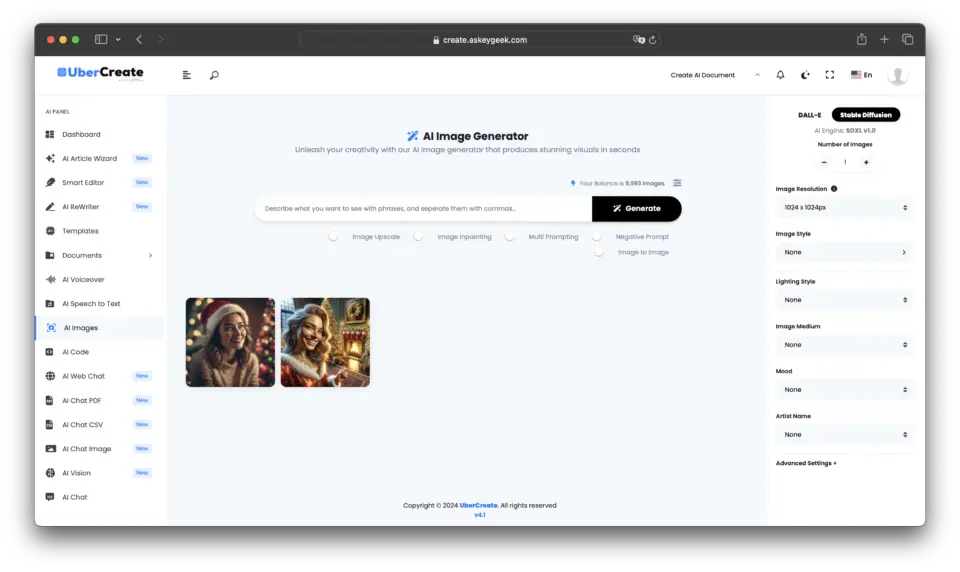

Intégrer le meilleur des deux mondes : UberCreate fusionne la diffusion stable et DALL-E

Dans le paysage en constante évolution de la génération d'images par l'IA, un nouvel outil émerge qui exploite la puissance combinée des deux modèles d'IA les plus avancés du secteur : UberCreate. Cette plateforme innovante réunit les capacités de Stable Diffusion et de DALL-E, offrant aux utilisateurs une expérience inégalée dans la génération d'images à partir de n'importe quelle description.

La puissance des générateurs d'images combinés à l'IA dans UberCreate

UberCreate témoigne de la synergie qui peut être obtenue en combinant les forces de différentes technologies d'IA. En intégrant la précision de DALL-E et la flexibilité de la diffusion stable, UberCreate offre une solution complète à tous ceux qui souhaitent générer des images rapidement et efficacement.

Pin

Pin Principales caractéristiques et fonctionnalités d'UberCreate

UberCreate est doté d'une interface intuitive qui simplifie le processus de création de visuels et le rend accessible aux utilisateurs, quelle que soit leur expertise technique. Pouvant générer des images à partir de n'importe quelle description, l'outil répond à un large éventail de besoins créatifs, qu'il s'agisse de travaux de conception professionnels ou de projets artistiques personnels.

L'une des caractéristiques les plus remarquables d'UberCreate est son expert en vision artificielle, qui permet aux utilisateurs de télécharger une image et de recevoir une analyse détaillée de son contenu. Cette fonction permet d'identifier des objets, des personnes et des lieux, ainsi que de discerner des détails complexes, fournissant ainsi des informations précieuses qui peuvent être utilisées pour affiner le processus créatif.

Les avantages de la diffusion stable et de DALL-E dans un seul outil

Le fait d'avoir à la fois Stable Diffusion et DALL-E dans UberCreate signifie que les utilisateurs peuvent profiter du meilleur des deux mondes. Qu'ils aient besoin des styles artistiques nuancés qu'offre la diffusion stable ou de la haute fidélité et de l'adhésion rapide de DALL-E, UberCreate peut répondre à ces besoins de manière transparente. Cette double capacité garantit que les images produites ne sont pas seulement visuellement étonnantes, mais qu'elles sont également en parfaite adéquation avec la vision de l'utilisateur.

De plus, la combinaison de ces modèles en un seul outil réduit considérablement le temps et les efforts nécessaires à la création de visuels. Les utilisateurs peuvent générer des images en quelques minutes, alors qu'il faudrait traditionnellement des heures pour les créer à la main ou à l'aide d'outils distincts. Cette efficacité est inestimable pour les professionnels qui doivent respecter des délais serrés sans compromettre la qualité.

Conclusion

UberCreate représente une avancée significative dans la génération d'images d'IA, en fournissant un outil polyvalent et puissant qui exploite les forces combinées de la diffusion stable et de DALL-E.

Son interface conviviale et ses fonctionnalités avancées en font un atout essentiel pour les artistes, les concepteurs et les créatifs qui cherchent à repousser les limites de l'art numérique et de la création de contenu.

Avec UberCreate, les possibilités sont aussi illimitées que l'imagination, permettant aux utilisateurs de donner vie à leurs concepts visuels les plus ambitieux avec facilité et précision.

Foire aux questions (FAQ)

Quelles sont les principales différences entre DALL-E et la diffusion stable dans l'outil UberCreate ?

Les principales différences entre DALL-E et Stable Diffusion au sein de l'outil UberCreate résident dans leurs capacités de modélisation texte-image et leurs techniques d'intégration d'images. DALL-E excelle dans la génération d'images photoréalistes à partir de descriptions en langage naturel grâce à un processus d'inférence raffiné et à un ensemble de données amélioré, ce qui le rend supérieur pour la création d'images précises basées sur des légendes. En revanche, Stable Diffusion utilise la diffusion latente et l'intégration d'images clip pour offrir une plus grande liberté dans le processus de diffusion afin de créer des images abstraites ou stylisées directement à partir d'invites textuelles conditionnelles.

Comment l'intégration de DALL-E et de la diffusion stable améliore-t-elle l'art généré par l'IA dans UberCreate ?

En intégrant à la fois DALL-E et Stable Diffusion, UberCreate offre une plateforme polyvalente pour l'art généré par l'IA. Cette combinaison permet aux utilisateurs de tirer parti de la capacité de DALL-E à générer des images photoréalistes basées sur des descriptions détaillées en langage naturel et de la capacité de Stable Diffusion à produire un art unique et stylisé grâce à son processus de diffusion latente. Ainsi, quelle que soit la complexité des images que vous souhaitez générer, UberCreate offre une solution complète.

La plateforme combinée DALL-E et Stable Diffusion d'UberCreate peut-elle comprendre des données complexes en langage naturel pour la génération d'images ?

Oui, la plateforme combinée de DALL-E et de Stable Diffusion dans UberCreate est conçue pour comprendre des entrées complexes en langage naturel. Le modèle avancé de conversion texte-image de DALL-E et l'utilisation intelligente par Stable Diffusion d'incrustations d'images de clips et d'ensembles de données permettent au système d'interpréter et de convertir des descriptions complexes en images correspondantes, facilitant ainsi une traduction transparente de la légende à l'image.

Quelles sont les avancées de la diffusion stable par rapport à DALL-E 2 dans UberCreate ?

Stable Diffusion offre plusieurs avancées par rapport à DALL-E 2 dans UberCreate, notamment un contrôle plus souple du processus de génération d'images et une meilleure qualité d'image. Grâce à des techniques de diffusion stables et à une meilleure intégration des images, Stable Diffusion peut générer des images plus abstraites et stylistiquement plus variées que le modèle texte-image de DALL-E 2. En outre, la version de Stable Diffusion a introduit un processus d'inférence plus efficace, ce qui se traduit par des temps de génération plus rapides et des images plus raffinées.

Comment utiliser l'IA pour mélanger de manière transparente les images générées par DALL-E et la diffusion stable dans UberCreate ?

Pour utiliser l'IA afin de fusionner de manière transparente les images générées par DALL-E et Stable Diffusion dans UberCreate, les utilisateurs peuvent recourir à la fonction d'inpainting de la plateforme et à ses capacités en matière d'ensembles de données. En spécifiant quels aspects de l'art généré par l'IA doivent provenir de l'un ou l'autre modèle, l'outil utilise intelligemment les techniques d'intégration d'images et les capacités de génération d'images conditionnelles de texte des deux modèles pour fusionner les éléments de manière naturelle. Cette fusion est facilitée par la compréhension qu'a l'IA sous-jacente des contextes des images et des nuances subtiles des détails de l'image originale.

Quelle est l'importance de l'intégration des images de clips dans la combinaison de DALL-E et de la diffusion stable ?

Les incrustations d'images clip jouent un rôle crucial dans la combinaison de DALL-E et de Stable Diffusion, car elles permettent à l'IA de comprendre et d'interpréter le contenu et le style des images à un niveau granulaire. Cet aspect est essentiel lors du mélange d'images générées par les deux modèles dans UberCreate, car il permet de s'assurer que les éléments des différentes images sont fusionnés de manière cohérente. Les incrustations d'images clip tirent parti de la compréhension du contenu de l'image par l'IA, ce qui facilite une intégration plus précise et plus naturelle des images générées.

DALL-E et Stable Diffusion d'UberCreate peuvent-ils générer différemment des images à partir du même message en langage naturel ?

Oui, en utilisant la même invite en langage naturel, DALL-E et Stable Diffusion peuvent générer des images nettement différentes en raison de leurs approches différentes de la génération d'images. DALL-E se concentre sur la création d'images précises et photoréalistes qui correspondent étroitement à la légende donnée, en tirant parti de son riche ensemble de données et de son modèle avancé de conversion de texte en image. À l'inverse, Stable Diffusion peut interpréter le même message de manière plus abstraite ou stylistique, en tirant parti de son processus de diffusion et de ses techniques de génération d'images latentes. Cette variance démontre la diversité du potentiel créatif de l'utilisation de l'IA au sein d'UberCreate.

Comment DALL-E et Stable Diffusion parviennent-ils à produire des images précises et détaillées à partir d'indications vagues ?

DALL-E et Stable Diffusion sont conçus pour extraire et utiliser les informations les plus pertinentes, même à partir des messages les plus vagues, grâce à leurs modèles d'IA avancés et à leurs ensembles de données complets. DALL-E utilise un modèle texte-image sophistiqué qui peut déduire des détails et un contexte qui ne seraient pas explicitement mentionnés dans l'invite. Stable Diffusion, grâce à son processus de diffusion latente et à l'utilisation d'images clip intégrées, comble les lacunes en s'appuyant sur sa formation approfondie en matière de contenu d'images diverses. Ensemble, ils appliquent l'inférence, la créativité et la compréhension du langage naturel pour générer des images détaillées qui correspondent à l'intention de l'utilisateur.