Difusión estable y generadores de imágenes DALL-E AI en UberCreate

La generación de imágenes de IA es el proceso de crear imágenes realistas a partir de un textoo cualquier otra información utilizando modelos de inteligencia artificial (IA). Los generadores de imágenes con IA tienen muchas aplicaciones, desde el arte digital al marketing, y pueden mejorar la narración de historias, el diseño web y los proyectos multimedia. Sin embargo, no todos los generadores de imágenes de IA son iguales.

En este artículo, exploraremos dos de los modelos de generación de imágenes de IA más avanzados e innovadores: Difusión estable y DALL-E. Compararemos sus capacidades, características y tecnologías, y mostraremos cómo pueden dar rienda suelta a tu creatividad con el poder de la ingeniería rápida.

También hablaremos del panorama del código abierto, las consideraciones éticas y las tendencias futuras de la tecnología de generación de imágenes por IA.

Tanto Stable Diffusion como DALL-E están a la vanguardia de un renacimiento digital que está transformando nuestra forma de concebir y crear arte. Estos modelos generativos de IA han democratizado la expresión artística, permitiendo a cualquiera que disponga de un ordenador generar imágenes asombrosas a partir de simples mensajes de texto. Este cambio no sólo amplía las herramientas de los artistas digitales, sino que también invita a personas de todas las profesiones y condiciones sociales a explorar su creatividad sin necesidad de tener conocimientos artísticos tradicionales.

Por último, exploraremos UberCrearuna herramienta de IA todo en uno que fusiona DALL-E y Stable Difussuion en una y cómo le beneficia.

¿Qué diferencia a Stable Diffusion y DALL-E en la generación de imágenes de IA?

Stable Diffusion y DALL-E son dos de los más recientes e impresionantes modelos de generación de imágenes por IA, lanzados por Estabilidad AI y OpenAI respectivamente. Ambos modelos utilizan un texto a imagen lo que significa que pueden generar imágenes a partir de descripciones en lenguaje natural. Sin embargo, difieren en sus arquitecturas, métodos y resultados.

- Difusión estable 3 es un modelo de difusiónlo que significa que genera imágenes refinándolas gradualmente a partir de ruido aleatorio. Utiliza un transformador de difusión para aprender el proceso inverso de añadir ruido a una imagen, y luego lo aplica a la inversa para generar una nueva imagen a partir de una indicación de texto. Stable Diffusion puede generar imágenes de alta calidad de hasta 256×256 píxeles y puede gestionar solicitudes complejas y diversas. También puede realizar inpaintinglo que significa que puede rellenar las partes que faltan de una imagen a partir de una imagen de entrada y un texto.

- DALL-E 3 es un modelo de transformadorlo que significa que genera imágenes codificando el mensaje de texto y descodificándolo en una imagen. Utiliza un gran modelo lingüístico llamado GPT-3 como codificador de texto, y un red neuronal deconvolucional como decodificador de imágenes. DALL-E puede generar imágenes de hasta 64×64 píxeles y puede producir varias imágenes para la misma solicitud. También puede realizar disparo cero generación de imágenes, lo que significa que puede generar imágenes para solicitudes que nunca ha visto antes.

Comparación de las capacidades del modelo de generación de imágenes de difusión estable frente a DALL-E

Stable Diffusion y DALL-E, aunque comparten el objetivo común de convertir texto en imágenes, difieren significativamente en su enfoque y resultados. DALL-E, desarrollado por OpenAI, destaca por seguir al pie de la letra las instrucciones para generar imágenes que se ajustan al texto introducido, a menudo con un alto grado de fotorrealismo y precisión. Por otro lado, Stable Diffusion, respaldada por Stability AI, ofrece una gama más amplia de estilos artísticos y la posibilidad de ajustar las imágenes mediante inpainting y outpainting, proporcionando una herramienta más flexible para la exploración creativa.

Exploración de las características únicas de cada modelo de generación

La integración de DALL-E con ChatGPT mejora sus capacidades de seguimiento de indicaciones, lo que lo hace excepcionalmente fácil de usar y eficaz a la hora de generar la imagen deseada al primer intento. Por el contrario, la naturaleza de código abierto de Stable Diffusion y la inclusión de funciones como ControlNet permiten un mayor nivel de personalización y experimentación, y se adaptan tanto a usuarios principiantes como a artistas experimentados.

Stability AI frente a OpenAI: la tecnología detrás de la magia

Ambos modelos se basan en técnicas avanzadas de aprendizaje automático y aprovechan variaciones de la arquitectura del transformador para procesar y generar imágenes complejas a partir de descripciones textuales. La diferencia clave radica en su accesibilidad y el uso previsto; DALL-E de OpenAI forma parte de un conjunto más amplio de herramientas de IA disponibles mediante suscripción, mientras que Stability AI hace hincapié en la participación de la comunidad y la innovación a través de su enfoque de código abierto.

¿Cuáles son las características únicas de la difusión estable y DALL-E que las distinguen en el ámbito de la generación de imágenes ai?

Mientras que Stable Diffusion destaca por su control sobre la modificación de imágenes y su asequibilidad, DALL-E sobresale por su interfaz fácil de usar, su calidad de imagen constante y sus capacidades de procesamiento de lenguaje natural. La elección entre estos generadores de imágenes de IA depende, en última instancia, de las preferencias específicas del usuario, sus objetivos y el nivel de personalización necesario para las tareas de generación de imágenes.

Difusión estable:

- Capacidades de repintado: Permite a los usuarios ajustar el tamaño de elementos específicos en las imágenes generadas o sustituirlos, lo que ofrece un mayor control sobre la modificación de las imágenes.

- Accesibilidad sin conexión: A diferencia de otros generadores de imágenes AI, Stable Diffusion puede descargarse y utilizarse sin conexión, lo que proporciona flexibilidad de uso.

- Rentable: Ofrece un plan básico a partir de $9 al mes, lo que lo convierte en una opción más asequible en comparación con DALL-E.

- Versatilidad y potencia: Conocida por su capacidad para crear imágenes de alta calidad con especial atención al control y la personalización por parte del usuario.

DALL-E:

- Interfaz fácil de usar: Requiere un nivel ligeramente inferior de conocimientos técnicos en comparación con Stable Diffusion, lo que mejora la accesibilidad para los usuarios.

- Calidad de imagen constante: Conocida por generar constantemente imágenes relevantes y de alta calidad, lo que garantiza un resultado fiable.

- Capacidad de procesamiento del lenguaje natural: Permite a los usuarios interactuar conversacionalmente con el modelo para refinar las indicaciones y generar imágenes basadas en entradas de texto.

Las limitaciones de Stable Diffusion y DALL-E en la generación de imágenes de IA son las siguientes:

Aunque ambos modelos ofrecen capacidades avanzadas en la generación de imágenes de IA, estas limitaciones ponen de manifiesto áreas en las que son necesarias mejoras o consideraciones para mejorar la experiencia del usuario y la calidad del resultado. Los usuarios deben evaluar detenidamente estas limitaciones en función de sus necesidades y preferencias específicas a la hora de seleccionar un generador de imágenes de IA para sus proyectos.

Difusión estable:

- Calidad de imagen irregular: En ocasiones, la difusión estable puede ofrecer una calidad de imagen irregular, lo que provoca variaciones en los resultados.

- Requisito de conocimientos técnicos: Aunque es fácil de usar, Stable Diffusion puede requerir un cierto nivel de conocimientos técnicos para un uso óptimo, lo que puede suponer una barrera para los principiantes.

- Restricciones de resolución: El modelo puede enfrentarse a problemas de deterioro y precisión cuando los parámetros del usuario se desvían de la resolución prevista de 512×512, lo que afecta a la calidad de las imágenes creadas.

DALL-E:

- Personalización limitada: DALL-E puede tener limitaciones en términos de personalización en comparación con Stable Diffusion, restringiendo potencialmente la capacidad de los usuarios para adaptar las imágenes a requisitos específicos.

- Consideraciones éticas: A pesar de su constante calidad de imagen, DALL-E se enfrenta a retos relacionados con posibles sesgos en las imágenes generadas y la necesidad de un uso responsable que se ajuste a las prácticas éticas.

- Ingeniería de avisos compleja: Los usuarios pueden tener dificultades para crear mensajes de texto precisos que transmitan con exactitud las imágenes deseadas, lo que repercute en la calidad y relevancia de las imágenes generadas.

Los tipos de imágenes que pueden generar Stable Diffusion y DALL-E difieren en varios aspectos:

Stable Diffusion brilla en el renderizado de varios estilos, soporta inpainting y outpainting, y ofrece amplias opciones de personalización, DALL-E destaca por su facilidad de uso, su enfoque en imágenes abstractas y pictóricas, y un resultado consistente de alta calidad. La elección entre estos modelos depende de los requisitos específicos del usuario, sus preferencias y el tipo de imágenes que pretenda generar.

Difusión estable:

- Estilos de renderizado: Stable Diffusion destaca en el renderizado de una gran variedad de estilos, especialmente fotos realistas, mejor que DALL-E nada más sacarlo de la caja.

- Inpainting y Outpainting: Stable Diffusion admite tanto el inpainting (regeneración de una parte de la imagen manteniendo el resto sin cambios) como el outpainting (ampliación de la imagen conservando el contenido original), lo que ofrece a los usuarios un mayor control sobre la modificación de la imagen.

- Versatilidad: Los usuarios pueden refinar cada aspecto de la imagen hasta que cumpla sus estándares, lo que hace que Stable Diffusion sea adecuado para la creación artística y la personalización.

DALL-E:

- Imágenes abstractas y pictóricas: DALL-E está entrenado para producir imágenes más abstractas o similares a la pintura, destacando en la respuesta eficaz a indicaciones menos detalladas o más amplias.

- Facilidad de uso: Conocido por su interfaz fácil de usar y sus capacidades de procesamiento de lenguaje natural, DALL-E ofrece una experiencia fluida para generar imágenes basadas en indicaciones sencillas y naturales.

- Calidad de imagen constante: DALL-E es reconocido por generar de forma consistente imágenes relevantes y de alta calidad, asegurando una salida fiable para los usuarios.

Puntos fuertes y débiles de la difusión estable y DALL-E para casos de uso específicos

Difusión estable:

Puntos fuertes:

- Capacidades de repintado: Permite a los usuarios ajustar elementos específicos de las imágenes o sustituirlos, proporcionando control sobre las modificaciones.

- Accesibilidad sin conexión: Puede descargarse y utilizarse sin conexión, lo que ofrece flexibilidad de uso.

- Versatilidad: Conocido por renderizar varios estilos, especialmente fotos realistas, y por admitir inpainting y outpainting, lo que permite una amplia personalización.

Debilidades:

- Calidad de imagen irregular: En ocasiones puede ofrecer una calidad de imagen variable, lo que repercute en la fiabilidad de la salida.

- Requiere conocimientos técnicos: Aunque es fácil de usar, puede requerir un cierto nivel de conocimientos técnicos para un uso óptimo, lo que puede suponer una barrera para los principiantes.

- Restricciones de resolución: Pueden surgir problemas al desviarse de la resolución prevista, lo que afecta a la calidad de la imagen.

DALL-E:

Puntos fuertes:

- Interfaz fácil de usar: Requiere menos conocimientos técnicos que Stable Diffusion, lo que mejora la accesibilidad de los usuarios.

- Calidad de imagen constante: Conocida por generar constantemente imágenes relevantes y de alta calidad, lo que garantiza un resultado fiable.

- Capacidad de procesamiento del lenguaje natural: Destaca por su capacidad para responder eficazmente a instrucciones menos detalladas o más amplias, lo que hace que la ingeniería de instrucciones sea menos crítica.

Debilidades:

- Personalización limitada: Puede tener limitaciones en la personalización en comparación con la Difusión Estable, restringiendo potencialmente la capacidad de los usuarios para adaptar las imágenes a requisitos específicos.

- Consideraciones éticas: Se enfrenta a retos relacionados con posibles sesgos en las imágenes generadas y la necesidad de un uso responsable que se ajuste a las prácticas éticas.

- Ingeniería de avisos compleja: Los usuarios pueden tener dificultades para crear mensajes de texto precisos que transmitan con exactitud las imágenes deseadas, lo que afecta a la calidad y la relevancia de las imágenes.

Stable Diffusion ofrece amplias opciones de personalización y versatilidad en los estilos de renderizado, mientras que DALL-E destaca por su facilidad de uso y su producción constante de alta calidad. La elección entre estos modelos depende de los requisitos específicos del caso de uso, el nivel de experiencia del usuario y el nivel de personalización deseado para las tareas de generación de imágenes.

Casos concretos en los que la difusión estable supera a DALL-E:

- Capacidades de inpainting: Stable Diffusion destaca en el inpainting, permitiendo a los usuarios ajustar elementos específicos en las imágenes o reemplazarlos, proporcionando un mayor control sobre la modificación de la imagen.

- Versatilidad en el renderizado de estilos: Stable Diffusion tiene ventaja en el renderizado de varios estilos, especialmente fotos realistas, superando a DALL-E en este aspecto.

- Accesibilidad sin conexión: A diferencia de DALL-E, Stable Diffusion puede descargarse y utilizarse sin conexión, lo que ofrece a los usuarios flexibilidad y privacidad en las tareas de generación de imágenes.

- Personalización y control: La Difusión Estable permite a los usuarios refinar cada aspecto de la imagen hasta que cumpla con sus estándares, por lo que es ideal para la creación artística y la personalización detallada en comparación con DALL-E.

- Rentabilidad: Con un plan básico a partir de $9 al mes, Stable Diffusion ofrece una opción más asequible para los usuarios en comparación con DALL-E, lo que la hace accesible a un mayor número de personas.

En resumen, Stable Diffusion supera a DALL-E en casos de uso específicos como las capacidades de inpainting, la versatilidad en los estilos de renderizado, la accesibilidad offline, las opciones de personalización y la rentabilidad. Los usuarios que busquen un mayor control sobre la modificación de la imagen, diversos estilos de renderizado, uso fuera de línea, personalización detallada y opciones económicas pueden encontrar Stable Diffusion más adecuado para sus necesidades de generación de imágenes en comparación con DALL-E.

Algunos casos de uso específicos en los que DALL-E supera a Stable Diffusion son:

- Facilidad de uso: DALL-E requiere menos conocimientos técnicos que Stable Diffusion, lo que lo hace más accesible a un público más amplio.

- Calidad de imagen constante: DALL-E es famoso por ofrecer imágenes relevantes y de alta calidad, lo que garantiza resultados fiables.

- Capacidad de procesamiento del lenguaje natural: DALL-E es capaz de responder eficazmente a instrucciones menos detalladas o más amplias, lo que hace que la ingeniería de las instrucciones sea menos crítica.

- Rapidez: DALL-E es normalmente más rápido en la producción de imágenes, a menudo tres o cuatro veces más rápido que la Difusión Estable en las mismas condiciones.

Sin embargo, es importante señalar que Stable Diffusion ofrece ventajas en casos de uso específicos, como las capacidades de inpainting, la accesibilidad offline, las opciones de personalización y la rentabilidad. En última instancia, la elección entre DALL-E y Stable Diffusion depende de los requisitos específicos del caso de uso, el nivel de experiencia del usuario y los niveles deseados de personalización y control de las tareas de generación de imágenes.

Cómo aprovechar el poder de la ingeniería de prompts para crear un arte de IA asombroso

Creación de mensajes de texto eficaces para obtener imágenes deseadas

El arte de la ingeniería de instrucciones consiste en crear entradas de texto que guíen a la IA para producir resultados visuales específicos. Esto requiere un equilibrio entre especificidad y creatividad, asegurándose de que el mensaje es lo suficientemente detallado como para transmitir el concepto deseado, dejando al mismo tiempo espacio para las capacidades interpretativas de la IA.

Comprender la importancia del lenguaje preciso en la redacción de prompts

La elección de las palabras de una pregunta puede influir significativamente en la imagen generada. Los términos que describen no sólo el tema, sino también el estilo, el estado de ánimo y el contexto pueden conducir a resultados más precisos y visualmente atractivos.

Trucos y consejos para optimizar la salida de imágenes mediante la ingeniería Prompt

La experimentación es clave; perfeccionar iterativamente las instrucciones basándose en resultados anteriores puede ayudar a dar con la fórmula perfecta. Además, aprovechar las características únicas de cada modelo, como la capacidad de DALL-E para generar variaciones o la inpainting de Stable Diffusion, puede mejorar aún más el proceso creativo.

Navegando por el panorama del código abierto: La difusión estable y su impacto

La importancia del código abierto para acelerar la innovación del generador de imágenes de IA

El modelo de código abierto de Stable Diffusion fomenta un entorno de colaboración en el que desarrolladores y artistas pueden contribuir a su evolución, lo que da lugar a rápidos avances y a una variada gama de modelos especializados.

Cómo empezar con el modelo de código abierto de Stable Diffusion

Acceder a Stable Diffusion es sencillo, con varias guías y recursos disponibles para ayudar a los usuarios a configurar el modelo para uso personal o profesional. La comunidad que rodea a Stable Diffusion también ofrece un amplio apoyo a los recién llegados.

Contribuciones comunitarias y mejoras de la difusión estable

La vibrante comunidad que rodea a Stable Diffusion ha propiciado el desarrollo de numerosos plugins, modelos y herramientas que amplían sus capacidades, permitiendo un control más matizado del proceso de generación de imágenes y abriendo nuevas vías a la creatividad.

Explorando los límites de la creatividad: Casos de uso de imágenes generadas por IA

Las imágenes generadas por IA han encontrado aplicaciones en una amplia gama de campos, desde el arte digital y el marketing hasta el diseño web y los proyectos multimedia. La capacidad de generar imágenes rápidamente a partir de mensajes de texto está revolucionando la creación de contenidos, permitiendo una narración más dinámica y soluciones de diseño innovadoras.

Evitar errores comunes: Consideraciones éticas en la generación de imágenes con IA

A medida que los generadores artísticos de IA se hacen más frecuentes, aumentan las preocupaciones en torno a los derechos de autor, la creatividad y el potencial de uso indebido. Tanto OpenAI como Stability AI han implementado salvaguardas para abordar estas cuestiones, pero el uso ético de estas herramientas sigue siendo una responsabilidad compartida entre los usuarios.

El futuro del arte de la IA: Predicciones y tendencias en la tecnología de generación de imágenes

El rápido avance de los generadores de imágenes por IA sugiere un futuro en el que la colaboración entre la creatividad humana y las herramientas de IA será aún más fluida. Anticipando nuevas mejoras en la interpretación rápida, la calidad de la imagen y las garantías éticas, la frontera entre el arte generado por IA y el arte creado por humanos puede seguir difuminándose, anunciando una nueva era de creatividad digital.

En conclusión, Stable Diffusion y DALL-E representan dos puntas de lanza en la frontera de la generación de imágenes mediante IA, cada una con sus puntos fuertes y capacidades únicas. A medida que evolucionen, estas tecnologías prometen democratizar aún más la creación artística, haciéndola más accesible y versátil que nunca.

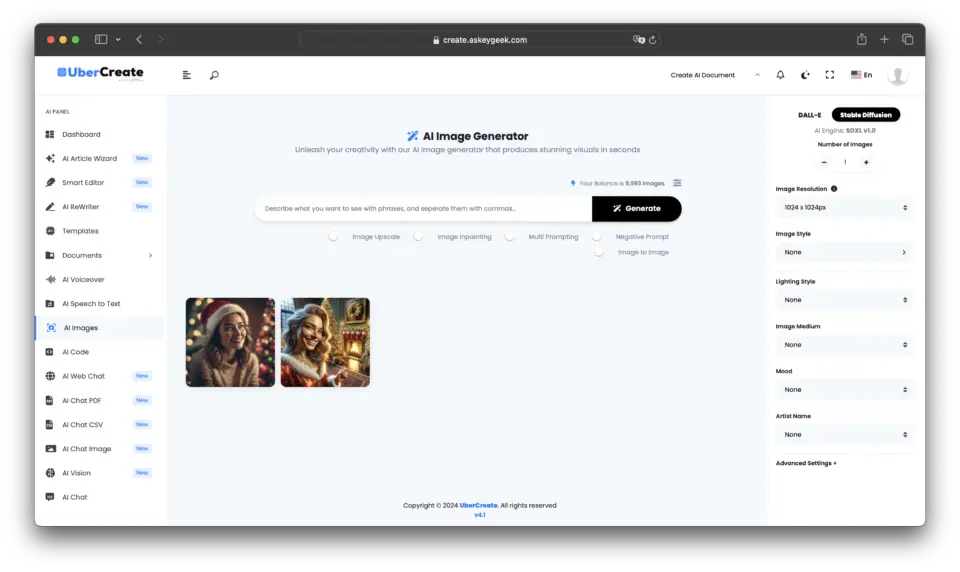

Integrar lo mejor de dos mundos: UberCreate fusiona difusión estable y DALL-E

En el panorama en constante evolución de la generación de imágenes mediante IA, surge una nueva herramienta que aprovecha la potencia combinada de los dos modelos de IA más avanzados del sector: UberCreate. Esta innovadora plataforma aúna las capacidades de Stable Diffusion y DALL-E, ofreciendo a los usuarios una experiencia inigualable en la generación de imágenes a partir de cualquier descripción.

El poder de los generadores de imágenes de IA combinados en UberCreate

UberCreate es un testimonio de la sinergia que puede lograrse al combinar los puntos fuertes de diferentes tecnologías de IA. Al integrar la precisión de DALL-E con la flexibilidad de Stable Diffusion, UberCreate ofrece una solución integral para cualquiera que busque generar imágenes de forma rápida y eficiente.

Pin

Pin Principales características y funciones de UberCreate

UberCreate cuenta con una interfaz intuitiva que simplifica el proceso de creación de imágenes, haciéndolo accesible a los usuarios independientemente de sus conocimientos técnicos. Con la capacidad de generar imágenes a partir de cualquier descripción, la herramienta satisface una amplia gama de necesidades creativas, desde trabajos de diseño profesional hasta proyectos artísticos personales.

Una de las características más destacadas de UberCreate es su AI Vision Expert, que permite a los usuarios cargar una imagen y recibir un desglose detallado de su contenido. Esta función puede identificar objetos, personas y lugares, así como discernir detalles intrincados, proporcionando información valiosa que puede utilizarse para refinar el proceso creativo.

Ventajas de disponer de difusión estable y DALL-E en una sola herramienta

Disponer de Stable Diffusion y DALL-E en UberCreate significa que los usuarios pueden disfrutar de lo mejor de ambos mundos. Ya sea que requieran los estilos artísticos matizados que ofrece Stable Diffusion o la alta fidelidad y rápida adherencia de DALL-E, UberCreate puede adaptarse a estas necesidades sin problemas. Esta doble capacidad garantiza que las imágenes producidas no sólo sean visualmente impresionantes, sino que también se ajusten estrechamente a la visión del usuario.

Además, la combinación de estos modelos en una sola herramienta reduce considerablemente el tiempo y el esfuerzo necesarios para crear elementos visuales. Los usuarios pueden generar en cuestión de minutos imágenes que tradicionalmente tardarían horas en elaborarse a mano o con herramientas independientes. Esta eficacia es inestimable para los profesionales que necesitan cumplir plazos ajustados sin renunciar a la calidad.

Conclusión

UberCreate representa un importante salto adelante en la generación de imágenes de IA, ya que proporciona una herramienta versátil y potente que aprovecha los puntos fuertes combinados de Stable Diffusion y DALL-E.

Su interfaz fácil de usar y sus funciones avanzadas lo convierten en un activo esencial para artistas, diseñadores y creativos que buscan ampliar los límites del arte digital y la creación de contenidos.

Con UberCreate, las posibilidades son tan ilimitadas como la imaginación, permitiendo a los usuarios dar vida a sus conceptos visuales más ambiciosos con facilidad y precisión.

Preguntas frecuentes (FAQ)

¿Cuáles son las principales diferencias entre DALL-E y Stable Diffusion en la herramienta UberCreate?

Las diferencias clave entre DALL-E y Stable Diffusion dentro de la herramienta UberCreate radican en sus capacidades de modelo de texto a imagen y en sus técnicas de incrustación de imágenes. DALL-E destaca en la generación de imágenes fotorrealistas a partir de descripciones en lenguaje natural con un proceso de inferencia refinado y un conjunto de datos mejorado, lo que lo hace superior para la creación precisa de imágenes basadas en leyendas. En cambio, Stable Diffusion utiliza la difusión latente y las incrustaciones de imágenes de clip para ofrecer más libertad en el proceso de difusión para crear imágenes abstractas o estilizadas directamente a partir de indicaciones de imágenes condicionadas por texto.

¿Cómo mejora la integración de DALL-E y Stable Diffusion el arte generado por IA en UberCreate?

Al integrar tanto DALL-E como Stable Diffusion, UberCreate ofrece una plataforma versátil para el arte generado por IA. Esta combinación permite a los usuarios aprovechar la capacidad de DALL-E para generar imágenes fotorrealistas basadas en descripciones detalladas en lenguaje natural y la capacidad de Stable Diffusion para producir arte único y estilizado a través de su proceso de difusión latente. Esto garantiza que, independientemente de la complejidad de las imágenes que se deseen generar, UberCreate ofrece una solución integral.

¿Puede la plataforma combinada DALL-E y Stable Diffusion de UberCreate comprender entradas complejas de lenguaje natural para la generación de imágenes?

Sí, la plataforma combinada de DALL-E y Stable Diffusion en UberCreate está diseñada para comprender entradas complejas en lenguaje natural. El modelo avanzado de conversión de texto a imagen de DALL-E y el uso inteligente de incrustaciones de imágenes de clip y conjuntos de datos de Stable Diffusion permiten al sistema interpretar y convertir descripciones complejas en las imágenes correspondientes, lo que facilita una traducción perfecta de subtítulos a imágenes.

¿Qué avances ofrece la difusión estable con respecto a DALL-E 2 en UberCreate?

Stable Diffusion ofrece varios avances sobre DALL-E 2 dentro de UberCreate, incluyendo un control más flexible sobre el proceso de generación de imágenes y una calidad de imagen mejorada. Utilizando técnicas de difusión estable e incrustaciones de imagen mejoradas, Stable Diffusion puede generar imágenes más abstractas y estilísticamente diversas que el modelo de texto a imagen de DALL-E 2. Además, el lanzamiento de Stable Diffusion introdujo un proceso de inferencia más eficiente, lo que se traduce en tiempos de generación más rápidos e imágenes más refinadas.

¿Cómo se utiliza la IA para mezclar a la perfección imágenes generadas por DALL-E y Stable Diffusion en UberCreate?

Para utilizar la IA para mezclar a la perfección imágenes generadas por DALL-E y Stable Diffusion en UberCreate, los usuarios pueden emplear la función de inpainting de la plataforma y sus capacidades de conjunto de datos. Al especificar qué aspectos del arte generado por la IA deben proceder de uno u otro modelo, la herramienta utiliza de forma inteligente técnicas de incrustación de imágenes y las capacidades de generación de imágenes condicionadas al texto de ambos modelos para fusionar los elementos de forma natural. Esta combinación se ve facilitada por la comprensión de la IA subyacente de los contextos de imagen y los sutiles matices de los detalles de la imagen original.

¿Qué importancia tienen las incrustaciones de imágenes clip en la combinación de DALL-E y Stable Diffusion?

Las incrustaciones de imágenes clip desempeñan un papel crucial en la combinación de DALL-E y Stable Diffusion, ya que permiten a la IA comprender e interpretar el contenido y el estilo de las imágenes a un nivel granular. Esto es esencial cuando se mezclan imágenes generadas por ambos modelos en UberCreate, ya que garantiza que los elementos de diferentes imágenes se fusionen de forma coherente. Las incrustaciones de imágenes de clip aprovechan la comprensión de la IA del contenido de la imagen, facilitando una integración más precisa y natural de las imágenes generadas.

¿Pueden DALL-E y Stable Diffusion de UberCreate generar imágenes de forma diferente a partir de la misma petición en lenguaje natural?

Sí, cuando se utiliza el mismo texto en lenguaje natural, DALL-E y Stable Diffusion pueden generar imágenes claramente diferentes debido a sus distintos enfoques para la generación de imágenes. DALL-E se centra en crear imágenes precisas y fotorrealistas que se ajusten al pie de foto, aprovechando su rico conjunto de datos y su avanzado modelo de conversión de texto en imagen. En cambio, Stable Diffusion puede interpretar el mismo mensaje de forma más abstracta o estilística, aprovechando su proceso de difusión y sus técnicas de generación de imágenes latentes. Esta variación demuestra el diverso potencial creativo del uso de la IA en UberCreate.

¿Cómo consiguen DALL-E y Stable Diffusion producir imágenes precisas y detalladas a partir de indicaciones imprecisas?

DALL-E y Stable Diffusion están diseñados para extraer y utilizar la información más relevante incluso de las indicaciones más imprecisas, gracias a sus avanzados modelos de IA y a sus completos conjuntos de datos. DALL-E emplea un sofisticado modelo de conversión de texto en imagen que permite deducir detalles y contextos que podrían no mencionarse explícitamente en la instrucción. Stable Diffusion, a través de su proceso de difusión latente y el uso de imágenes de clip incrustadas, rellena los huecos basándose en su amplia formación sobre diversos contenidos de imágenes. Juntos, aplican la inferencia, la creatividad y la comprensión del lenguaje natural para generar imágenes detalladas que se ajusten a la intención del usuario.